Künstliche Intelligenz: Retro-Game zeigt Deep-Learning-Schwächen

Die NetHack-Challenge 2021 ist zu Ende. Die Ergebnisse des Wettbewerbs zeigen die Schwächen aktueller Deep-Learning-Systeme deutlich auf.

2020 stellten Forschende von Meta (damals noch Facebook), der University of Oxford, der New York University, des Imperial College London und des University College London die NetHack-Lernumgebung für Künstliche Intelligenz vor.

Das 1987 veröffentlichte Rollenspiel taucht regelmäßig in Listen der schwersten Videospiele aller Zeiten auf. Spieler:innen müssen sich mit einer von zahlreichen Klassen durch 50 zufällig generierte Dungeons schlagen, um ein magisches Amulett zu finden.

Die komplexen Spielmechaniken mit Hunger, Erschöpfung, Haustieren, Göttern, Monstern, Rätseln, giftigen Wasserstellen oder Halluzinationen führen schnell und häufig zum Tod der Spielfigur. In diesem Fall startet das Spiel neu und die Welt wird ebenfalls neu generiert.

NetHack ist komplexer als Starcraft II

Das Navigieren der enorm komplexen Spielwelt erfordert Einfallsreichtum und Kreativität. Seit Jahrzehnten tauschen sich NetHack-Spielende daher über Strategien aus. Sie haben ein umfassendes Wiki verfasst, das Neueinsteigern auf der schweren Reise zum Amulett helfen kann. Laut den Forschenden benötigen menschliche Profis auf dem Weg zum Sieg etwa 25- bis 50-mal so viele Spielschritte wie für eine Starcraft-II-Partie.

Der Vergleich ist relevant, da moderne Videospiele wie Starcraft II, DOTA 2 oder Minecraft seit einigen Jahren im Fokus von KI-Forschenden sind. So hat Deepmind mit AlphaStar ein System geschaffen, das menschliche Profispieler in Starcraft II besiegen kann.

NetHack hat jedoch einen Vorteil als Trainingsumgebung für Künstliche Intelligenz: Die Spielwelt ist zwar offener und komplexer als bei vielen anderen Videospielen. Doch das Training von KI-Agenten für das Spiel ist wegen der geringen Anforderungen in wenigen Stunden oder Tagen auf handelsüblichen Grafikkarten möglich. Systeme wie AlphaStar benötigen dagegen Wochen oder Monate, um komplexe Videospiele wie Starcraft zu lernen, und sind dabei auf Supercomputer angewiesen. Im Juni starteten die Forschenden dann die NetHack-Challenge mit Unterstützung von Meta und Deepmind. Das Ziel: den besten NetHack-Bot zu schaffen.

NetHack-Challenge 2021 zeigt Kluft zwischen zwei Ansätzen

Unter den zahlreichen Einreichungen finden sich zwei unterschiedliche Ansätze: bestärkendes Lernen und symbolische Systeme. Letztere gleichen klassischen Bots und setzten auf externes, von Menschen gesammeltes Wissen, vorprogrammierte Überlebensstrategien etwa für Nahrung, Inventarnutzung, Kämpfen oder Flüchten und höherwertige Ziele wie die Suche nach Gnom-Minen. Die Deep-Learning-Einreichungen setzen dagegen in Teilen oder komplett auf bestärkendes Lernen.

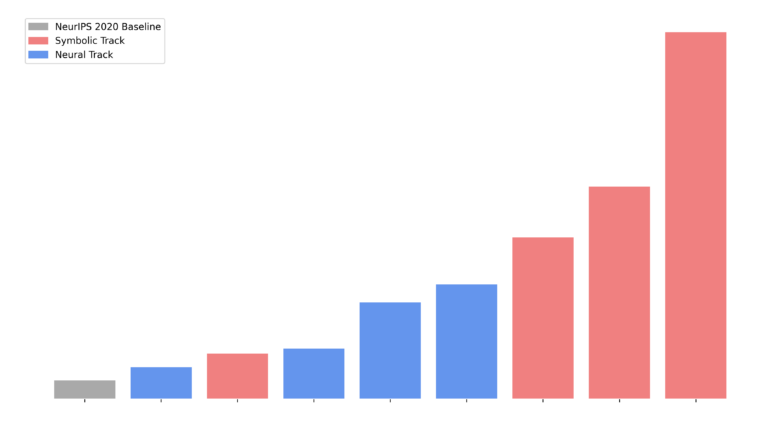

Im Vergleich versagen die moderneren KI-Methoden gegenüber den symbolischen Systemen: Die drei besten Teams verwendeten symbolische Systeme. Im Median erreichen symbolische Bots die zwei- bis dreifache, in Einzelfällen sogar die bis zu zehnfache Punktzahl. In den besten Durchgängen überlebten symbolische Bots dreimal länger als Deep-Learning-Bots und kamen bis zu Dungeon 22. Häufigste Todesursache aller Bots war Hunger.

NetHack: Lichtblick für Deep Learning

Die vernichtende erste Runde ist gleichzeitig eine gute Nachricht: NetHack scheint ein geeignetes Testbed für noch ausstehende große Herausforderungen bei Deep-Learning-Methoden. Der beste neuronale Bot schlug die 2020 in der Veröffentlichung vorgestellte Bot-Variante der Forschenden außerdem um das Fünffache.

Alle Systeme - auch symbolische - liegen zudem immer noch weit hinter menschlicher Leistung. Kein System hat es in den insgesamt knapp 500000 Runden geschafft, NetHack zu beenden.

"Die NetHack-Challenge erinnert uns daran, dass die Suche nach AGI noch nicht zu Ende ist und dass es noch mehr als ein Pferd im Rennen gibt. Meine Wette: Hybridmodelle werden nächstes Jahr die Nase vorn haben", so KI-Forscher Gary Marcus. Kognitionsforscher Steven Pinker stimmt Marcus zu: "Für eine echte KI braucht es strukturierte Repräsentationen (auch Ideen genannt)."

Für KI-Forscher Yann LeCun zeigt NetHack, dass Belohnung allein nicht ausreiche. Das für die jeweilige Welt notwendige Domänenwissen würde zusätzlich benötigt. "Die wichtige Frage ist, ob Domänenwissen erlernt werden kann." LeCuns Antwort: ein klares Ja.

Die zweite große Herausforderung sei dann, lernende Maschinen in die Lage zu versetzen, zu denken und zu planen. "Wie machen wir logisches Denken mit gradientenbasiertem Lernen vereinbar? Die NetHack Challenge reibt uns diese Frage unter die Nase."

Die Reise hat also gerade erst begonnen und die zweite NetHack-Challenge 2022 könnte Fortschritte bei Deep Learning bringen. In der zweiten Runde soll der Fokus voraussichtlich stärker auf der Integration von externem Wissen aus dem NetHack-Wiki und Spielaufnahmen menschlicher Profis liegen.

Warum das wichtig ist und welche Herausforderungen bestärkendes Lernen neben NetHack noch lösen soll, erklärt uns der beteiligte KI-Forscher Tim Rocktäschel in unserem KI-Podcast DEEP MINDS bei YouTube, Spotify, Apple, Soundcloud, Amazon Music, Google Podcasts oder per RSS Feed.

Alle weiteren Informationen zur NetHack-Challenge gibt es in der vollständigen Session von der NeurIPS 2021 und im Report der Projektseite.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.