Das KI-System StyleGAN-NADA generiert dank OpenAIs CLIP Bilder per Textanweisung – auch für Kategorien und Stile, die es noch nie gesehen hat. Weshalb ist das so besonders?

GANs generieren Bilder wie Porträts, Tiere, Gebäude oder Fahrzeuge. Wie viele andere KI-Systeme sind die neuronalen Netze jedoch Spezialisten: Ein mit Katzenbildern trainiertes System kann keine Hundebilder erzeugen. Dieses Katzen-GAN müsste zuerst viele Fotos von Hunden sehen, bevor es die Haustierfavoriten gemeinsam auf ein Bild malen kann.

Dieses Trainingsprinzip gilt auch für Stiländerungen: Soll das GAN statt fotorealistischer Bilder von Katzen lieber Katzen in Öl zeichnen, muss es die spezifischen visuellen Eigenheiten von Ölgemälden zunächst antrainiert bekommen.

Bislang galt diese Regel ziemlich unverrückbar. Doch Anfang 2021 zeigte OpenAI neben DALL-E auch CLIP, ein multimodales KI-Modell. CLIP ist multimodal, weil es mit Bildern und mit Texten trainiert wurde. So kann es zum Beispiel feststellen, ob eine Bildunterschrift zum Bildinhalt passt.

Seit der Veröffentlichung von CLIP experimentieren KI-Forscher:innen und Künstler:innen mit OpenAIs Bild-KI. Einige kombinieren das Bild-Sprache-Modell mit generativen Netzwerken wie Nvidias StyleGAN - und schaffen so eine neue Generation generativer KI.

StyleCLIP ändert Bild-Details per Texteingabe

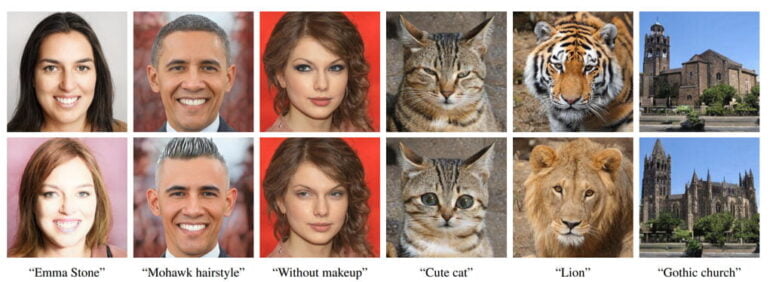

Israelische Forscher:innen zeigten gemeinsam mit Adobe im März 2021 StyleCLIP, ein GAN, das per Texteingabe gesteuert werden kann. Über ein einfaches Interface ändern die Forscher etwa die Haarfarbe einer Person, verniedlichen eine Katze oder verwandeln einen Tiger in einen Löwen.

Für solche Veränderungen innerhalb der jeweiligen Domäne (etwa Katzenbilder oder menschliche Porträts) brauchte StyleCLIP allerdings zuvor Beispielbilder und zusätzliches Training.

Doch könnte CLIP GA-Netze auch so steuern, dass diese Bilder außerhalb ihrer ursprünglich antrainierten Domäne generieren? Kann ein GA-Netz, das nur mit Katzenbildern trainiert wurde, Hundebilder erzeugen?

Dank multimodaler Ausrichtung: Bild-KI wird vielseitiger

Genau diese Aufgabe soll StyleGAN-NADA meisten. Wie StyleCLIP setzt das neue System auf Nvidias StyleGAN für die Bildgenerierung und auf CLIP als Steuerungsmechanismus. Das "Nada" (span. "nichts") im Namen ist eine Anspielung auf die nicht benötigten Trainingsdaten.

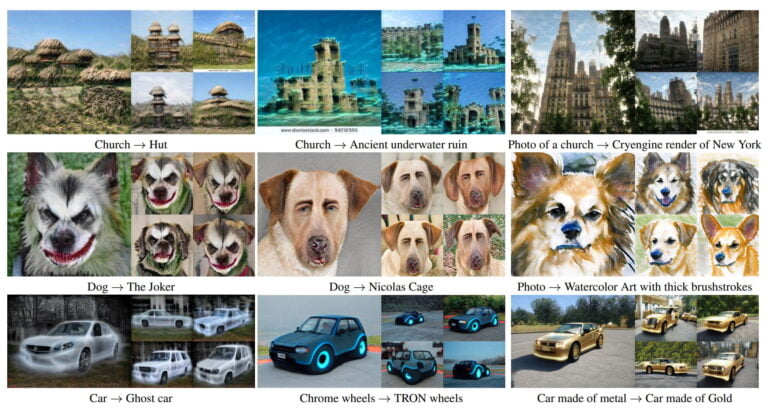

Denn anders als StyleCLIP können StyleGAN-NADA-Netze Bilder und Stile ohne Zusatztraining außerhalb ihrer Domäne generieren: Künstliche Menschen in fotorealistische Porträts verwandeln sich in Werwölfe. Zeichnungen oder Gemälde erscheinen im Stil ausgewählter Künstler:innen. Aus Hunden werden Bären oder Hunde mit dem Gesicht von Nicolas Cage. Das Bild einer Kirche wird zur Stadtlandschaft von New York.

Die Besonderheit: Keines dieser bildgebenden GA-Netze hat jemals Aufnahmen von Werwölfen, Zeichnungen von Künstler:innen, Bären, Nicolas Cage oder New York gesehen.

Möglich wird dieser Fortschritt durch eine besondere Architektur des KI-Modells: Die Forscher setzen auf zwei Generatoren, deren Fähigkeiten sich am Anfang gleichen. Die Gewichtungen im neuronalen Netz eines Generators werden eingefroren und dienen als Orientierung für den zweiten Generator, der seine Gewichtungen anpasst, bis aus einem Ausgangsbild neue Bilder entstehen, die den Vorgaben von CLIP entsprechen.

Als Eingabe dienen Ausgangs- und Zielkategorie, etwa "Mensch" und "Werwolf" oder "Hund" und "Nicolas Cage". Um die Qualität der generierten Bilder zu erhöhen, ändert der zweite Generator seine Gewichte Schicht für Schicht.

Riesige Modelle machen Künstliche Intelligenz flexibler

Auch wenn die beschriebenen GA-Netze ihre Zielkategorien oder Stile nicht explizit gesehen haben, implizit sind all diese Informationen in CLIP enthalten. Denn OpenAI trainierte das KI-Modell mit großen Bild- und Textmengen aus dem Internet: Nicolas Cage, Tron, Bären, Gemälde von Picasso - all diese visuellen Motive waren in CLIPs-Datentraining enthalten und sind mit ihren jeweiligen sprachlichen Begriffen verknüpft. Eine Untersuchung von OpenAI demonstrierte dieses an das Großmutterneuron erinnernde Phänomen.

StyleGAN-NADA nutzt die in CLIP enthaltenen umfassenden Repräsentationen visueller Motive als Vorgaben für die eigenen spezifisch trainierten GANs. Im Vergleich mit anderen GAN-Systemen, die auf explizite Trainingsbilder als Vorlage setzen, sei StyleGAN-NADA deutlich effektiver. Das gelte auch für Varianten, die auf wenige Trainingsdaten setzen, schreiben die Forscher. Eine Verschiebung der Domäne dauere nur wenige Minuten. Das folgende Video veranschaulicht den Prozess.

StyleGAN-NADA ist ein weiteres Beispiel für die Vielseitigkeit großer KI-Modelle wie CLIP oder GPT-3, die in den letzten rund zwei Jahren trainiert wurden. Wegen ihres umfassenden Vortrainings mit riesigen Datenmengen dienen sie als Grundlage für spezifische KI-Anwendungen, die dann durch vergleichsweise weniger aufwendige Feinjustierung schneller entwickelt werden können.

Den Code für StyleGAN-NADA gibt es bei Github.