Neue Google-KI kann einzelne Stimmen gezielt heraushören

Eine neue Analyse-KI von Google kann sich auf eine einzelne Stimme in einem Raum oder während eines Gesprächs fokussieren und nur dieser zuhören.

Laut den Google-Forschern ist die KI dem sogenannten "Cocktail-Party-Effekt" nachempfunden. Gemeint ist die Fähigkeit eines Menschen, sich selbst in einer lauten Umgebung auf eine einzelne Schallquelle zu konzentrieren und sie aus einem Stimmgewirr oder Hintergrundgeräuschen herauszufiltern - zum Beispiel bei einer Unterhaltung auf einer lauten Party.

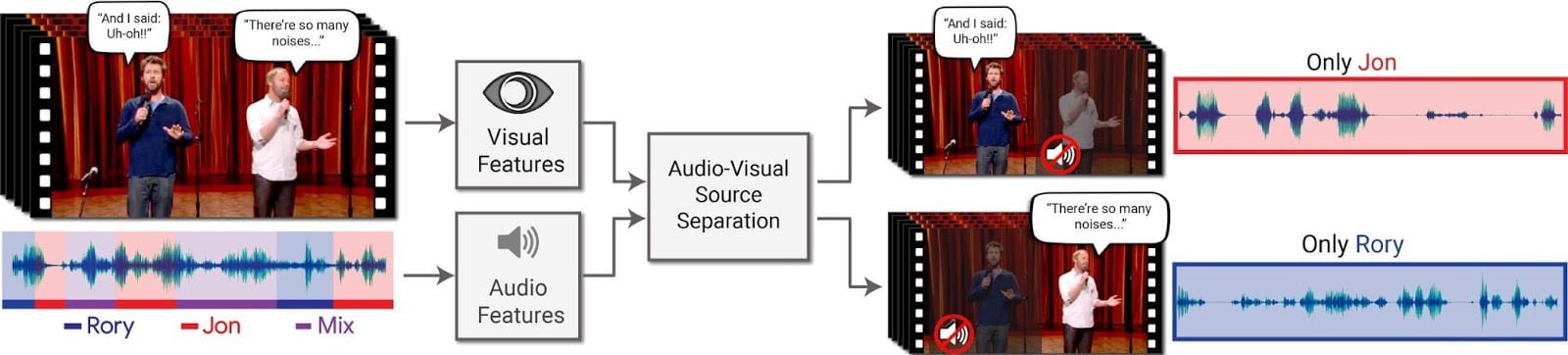

Die Forscher entwickelten für diese Stimmisolation ein Deep-Learning-Verfahren mit einem auf Bildanalyse optimierten neuronalen Netz. Denn zusätzlich zur Tonspur braucht die KI visuelle Eingabe. Erst die Kombination aus Video- und Audiodaten ermöglicht es ihr, eine einzelne Schallquelle von Nebengeräuschen zu unterscheiden.

Die KI berechnet dafür sogenannte Spektrogramme - das ist die grafische Darstellung eines Klangs - und ordnet diese passend den Gesichtern im Video zu. Ein Nutzer könnte laut Google so in einem Video mit vielen Menschen gezielt eine Person aussuchen, deren Stimme er heraushören möchte.

Trainiert wurde das System laut Google mit 2.000 Stunden ungestörtem Audio-Video-Material, in dem Menschen gut sichtbar in eine Kamera sprechen - ein Sprecher pro Video. Diese Szenen wurden aus rund 100.000 YouTube-Vorträgen und -Gesprächen extrahiert und zu einer "künstlichen Cocktailparty" vermischt. Ergänzt wurden dann noch Hintergrundgeräusche.

Laut Google könnte das neue KI-Verfahren automatisiert Untertitel erstellen oder die Spracherkennung verbessern. Womöglich könnten auch YouTube-Videos nach gesprochenem Wort durchsucht werden. Das Unternehmen prüfe derzeit, wie sich die Software in die eigenen Produkte integrieren lasse.

Einige YouTube-Videos zeigen das Verfahren in Aktion. Es scheint ziemlich gut zu funktionieren. Die vollständigen Ergebnisse veröffentlicht Googles KI-Team im eigenen Blog.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.