Auf der ersten eigenen Entwicklerkonferenz hat OpenAI seinen Anspruch untermauert, ein neues Chatbot-Ökosystem zu schaffen.

Die wichtigsten News sind zweifelsohne GPT-4 Turbo samt zahlreicher API-Neuerungen wie Assistants sowie Custom ChatGPTs, die Anwender:innen mit eigenen Daten füttern und in natürlicher Sprache programmieren können. Doch neben diesen beiden großen Neuerungen hatte OpenAI noch viele weitere Neuigkeiten im Gepäck.

Sprache zu Text: Whisper v3 als Open Source verfügbar

Whisper ist das KI-Modell für Sprache-zu-Text von OpenAI. Das neue Modell v3 wurde auf einer Million Stunden schwach markierter Audiodaten und vier Millionen Stunden pseudobeschrifteter Audiodaten trainiert, die mit Whisper v2 gesammelt wurden. Zusätzlich wurde Kantonesisch als Sprache hinzugefügt. In Benchmarks übertrifft das Modell v3 sein Vorgängermodell in der Fehlerrate noch einmal deutlich.

Die Leistung variiert je nach Sprache, aber im Allgemeinen kann Whisper v3 in der größten Version eine Fehlerrate von weniger als 60 Prozent für Common Voice 15 und Fleurs vorweisen, was laut OpenAI einer Fehlerreduktion von 10 bis 20 Prozent im Vergleich zu large-v2 entspricht. Whisper v3 ist auf Github verfügbar. Eine API-Implementierung bei OpenAI wird in Kürze folgen.

Text to Speech: OpenAIs Computerstimmen klingen menschlich

OpenAI kündigte auch den umgekehrten Weg an: ein Text-zu-Sprache-Modell, das Elevenlabs und Co. Kopfzerbrechen bereiten könnte. Mit dem TTS-Modell kann man sich seine Texte von bis zu sechs menschenähnlich klingenden synthetischen Stimmen vorlesen lassen.

Die Stimmen sind von der ChatGPT-Applikation bekannt und verfügen über eine glaubwürdige Intonation. OpenAIs TTS gibt es in einer qualitativ hochwertigen und einer auf Geschwindigkeit getrimmten Version.

Pro 1000 gesprochene Zeichen nimmt OpenAI $0.015 und ist damit deutlich günstiger als ElevenLabs, wenn man aus der Flatrate fällt (bis zu $0.30 pro 1000 Zeichen).

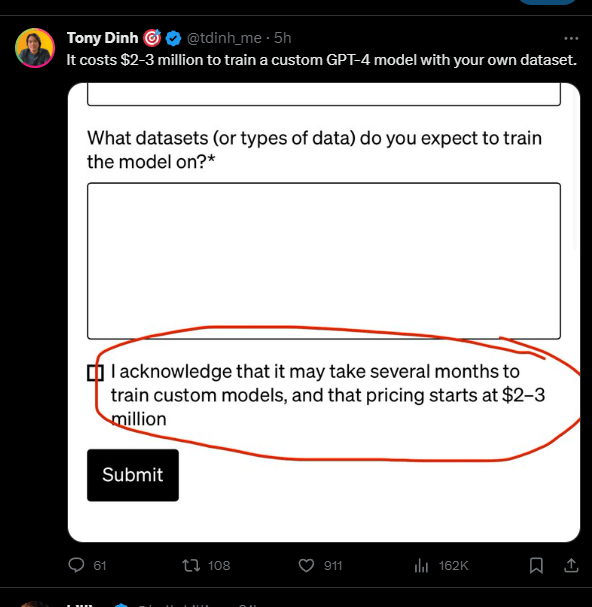

GPT-4-Feintuning ist ziemlich teuer

Ebenfalls auf der Entwicklermesse kündigte OpenAI ein "sehr begrenztes" Programm für erste GPT-4-Feintuning-Projekte an. Für GPT-3.5 gibt es bereits seit einiger Zeit Feintuning-Optionen, die direkt im Webinterface vorgenommen werden können.

Das GPT-4-Feintuning scheint jedoch wesentlich aufwendiger zu sein, mit Preisen, die erst bei zwei Millionen US-Dollar beginnen, und einer Datenmenge von mindestens einer Milliarde Token im Besitz des Unternehmens. OpenAI bietet das Feintuning nur ausgewählten Unternehmen an, die dann exklusiven Zugriff auf ihr eigenes Modell haben.

OpenAI schützt vor Urheberrechtsverletzungen

Wie bereits Microsoft und Google kündigt nun auch OpenAI eine Art Rechtsschutz gegen generative Urheberrechtsklagen an. Unternehmen, die aufgrund von Inhalten, die mit OpenAI-Modellen generiert wurden, urheberrechtlich belangt werden, können sich die Kosten eines möglichen Rechtsstreits von OpenAI erstatten lassen. Dies gilt jedoch nur für ChatGPT Enterprise und die Entwicklerplattform. Der "normale" ChatGPT-Benutzer fällt nicht unter das Copyright Shield.

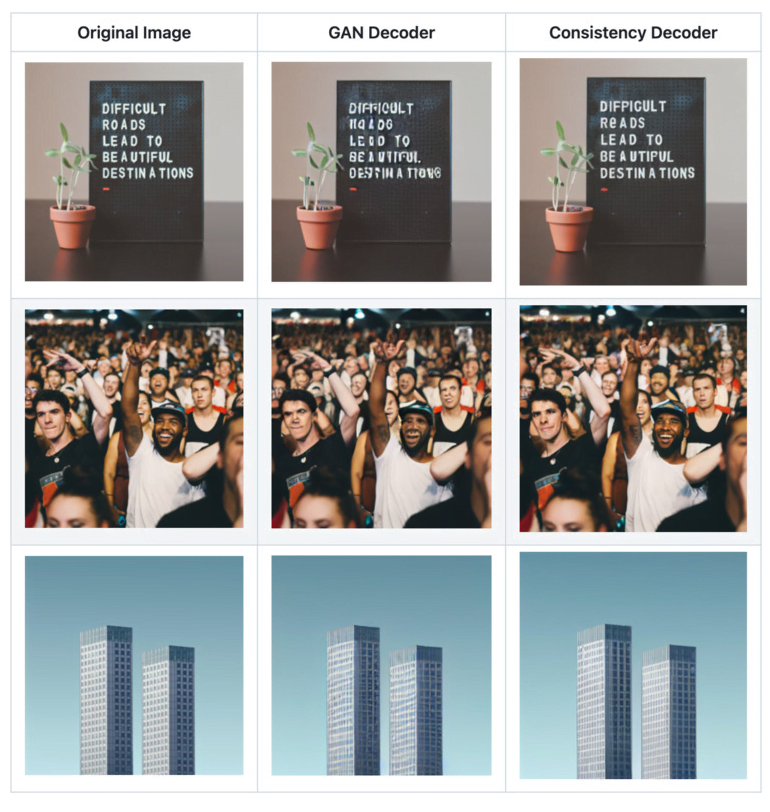

Neuer Decoder für Stable Diffusion

Der OpenAI Consistency Decoder ist ein Open-Source-Upgrade für den Decoder, der im Stable Diffusion Variational Autoencoder (VAE) verwendet wird. Er verwendet Konsistenztraining, um die Bilderzeugung zu verbessern, insbesondere bei Text, Gesichtern und geraden Linien. Er ist vollständig kompatibel mit Stable Diffusion 1.0+ VAE. Verbesserungen durch den neuen Decoder kann man hier ansehen oder hier.

ChatGPT ist wieder aktueller und bekommt häufiger Updates

Mit dem GPT-4 Turbo Modell bekommt ChatGPT auch ein Content-Update bis April 2023. Aber nicht nur das: Laut OpenAI CEO Sam Altman nervt es OpenAI am meisten, dass ChatGPT nicht aktuell ist. Er plant daher für die Zukunft regelmäßigere Content-Updates. So lernt ChatGPT kontinuierlicher dazu.

Bezahlung von GPTs hängt am ChatGPT-Umsatz

Eine große Ankündigung auf der Entwicklerkonferenz waren die GPTs, ChatGPT-Instanzen, die von Nutzern für ihre Zwecke angepasst, optimiert und dann auf einem Marktplatz angeboten werden. OpenAI kündigte an, dass erfolgreiche Anbieter auch finanziell beteiligt werden sollen, der Modus war aber noch unklar.

Gegenüber Alex Heath von The Verge bestätigt Altman, dass zunächst eine Umsatzbeteiligung an den ChatGPT-Abonnement-Einnahmen geplant sei. Dabei soll es verschiedene Stufen geben, abhängig von der Anzahl der teilnehmenden User, sowie spezielle Boni für Kategorien. Konkrete Zahlen nennt Altman nicht und erwartet, dass sich die Finanzierung "noch stark entwickeln" wird.

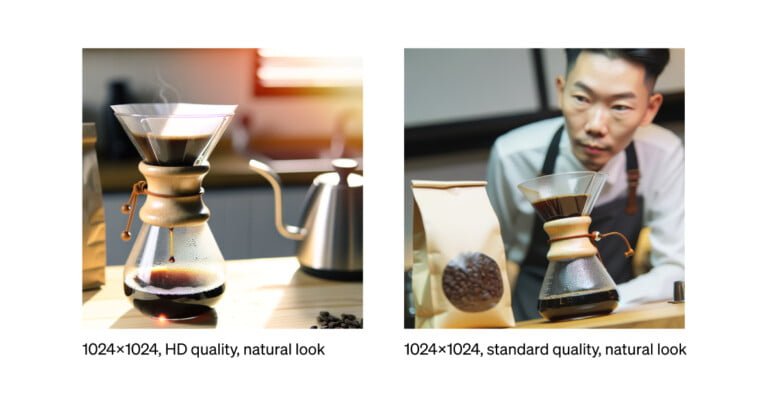

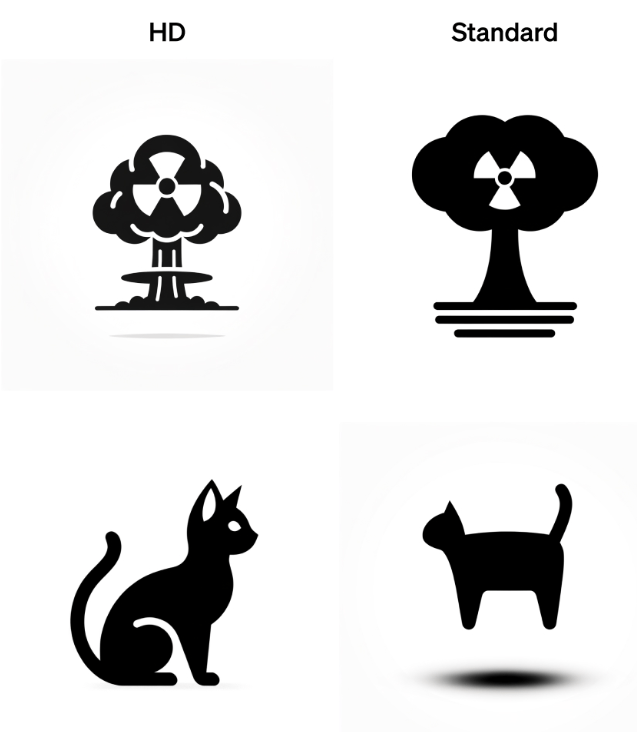

DALL-E 3 hat vier Modi

OpenAI stellt in seinem "Cookbook" für Entwickler auch einige Details zu DALL-E 3 vor, wenn das Modell über die API betrieben wird. DALL-E 3 bietet zwei grundlegende Betriebsmodi, "natural" und "vivid", die, wie der Name schon sagt, eher natürliche, realistische oder hyperrealistische, dramatische Inhalte erzeugen. Der DALL-E 3 in ChatGPT ist auf "vivid" eingestellt. "Natural" sollte DALL-E 2 ähnlicher und etwa für Fotos geeignet sein.

Zwei weitere Qualitätsmodi sind "HD" und "Standard", letzterer ist von ChatGPT bekannt. HD soll mehr Details darstellen und dem Prompt genauer folgen. Allerdings ist HD teurer und die Generierung dauert durchschnittlich zehn Sekunden länger. Für Entwickler ist es dennoch interessant, dass sie für ihre eigenen Anwendungen vielleicht eine etwas bessere Qualität als mit DALL-E 3 in ChatGPT erreichen können.

ChatGPT hat immer noch unglaubliche Nutzungsdaten

ChatGPT hat in weniger als einem Jahr eine unglaubliche Wachstumsgeschichte hingelegt, wie OpenAI CEO Sam Altman auf der Entwicklerkonferenz noch einmal betonte: Die Plattform hat derzeit 100 Millionen wöchentlich aktive Nutzerinnen und Nutzer.

Dazu kommen zwei Millionen Entwicklerinnen und Entwickler, die auf die Programmierschnittstelle zugreifen und deren Apps wiederum von Millionen Menschen genutzt werden. 92 Prozent der Fortune-500-Unternehmen arbeiten laut Altman mit OpenAI-Technologien.

In den Sommermonaten hat sich das Wachstum laut Similarweb etwas verlangsamt oder ist sogar leicht zurückgegangen. Angesichts der oben genannten Zahlen sollte dies den Erfolg der Plattform insgesamt nicht schmälern.