Eine neue Studie untersucht Bewusstsein in KI und entwickelt Indikatoren, die anzeigen könnten, ob ein KI-System über ein Bewusstsein verfügt.

Künstliche Intelligenz hat in den letzten Jahren viele Fortschritte gemacht und in einigen Fällen - ob zu Recht oder nicht - die Frage aufgeworfen, ob sie ein Bewusstsein entwickeln könnte. Ein berühmtes Beispiel aus jüngster Zeit war der Google-Mitarbeiter Blake Lemoine und sein Bericht über den vermeintlich empfindungsfähigen LaMDA-Chatbot von Google. Ein offensichtliches Problem seiner Zuschreibung war, dass sie allein auf dem Verhalten des Modells beruhte.

Nun hat ein interdisziplinäres Forscherteam einen neuen Bericht veröffentlicht, der einen "rigorosen und empirisch fundierten Ansatz für das Bewusstsein von KI" entwickelt. In Bezug auf Fälle wie Lemoines argumentiert das Team: "Wir glauben, dass ein theorielastiger Ansatz für KI notwendig ist. Ein theoriegeleiteter Ansatz ist ein Ansatz, der sich darauf konzentriert, wie Systeme funktionieren, und nicht darauf, ob sie äußeres Verhalten zeigen, das als charakteristisch für bewusste Wesen angesehen werden könnte."

In dem Bericht argumentiert das Team, dass die Beurteilung, ob ein KI-System bewusst ist, so wissenschaftlich nachvollziehbar sein kann, und stellt eine Liste von Eigenschaften auf, die als Indikatoren dienen können.

Neurowissenschaftliche Theorien des Bewusstseins informieren über Indikatoreigenschaften

Die Forschenden nehmen eine "computational functionalist"-Perspektive ein, gehen also davon aus, dass Bewusstsein in einem KI-System davon abhängt, dass es bestimmte Berechnungen durchführt.

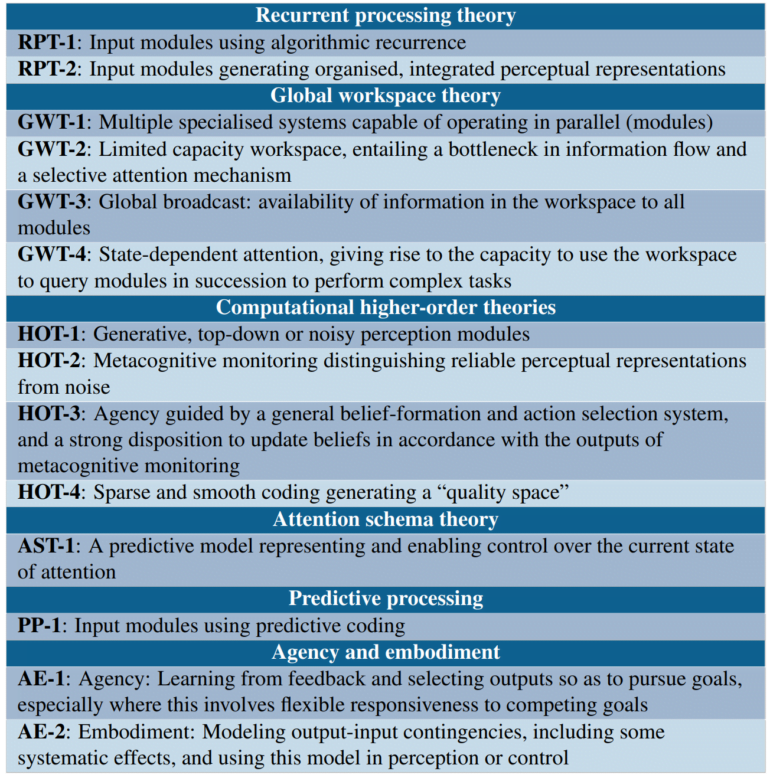

Sie stützen sich dabei auf neurowissenschaftliche Theorien, die darauf abzielen, die spezifischen Rechenfunktionen zu identifizieren, die beim Menschen mit dem Bewusstsein verbunden sind. Dazu gehören etwa die Global-Workspace-Theorie, Attention-Schema-Theorie oder Theorien der Agency und des Embodiments.

Aus diesen Theorien leiten die Forschenden eine Liste von Indikatoreigenschaften ab, deren Vorhandensein die Wahrscheinlichkeit erhöht, dass ein KI-System bewusst ist. Die Global-Workspace-Theorie umfasst beispielsweise Eigenschaften, wie das Vorhandensein mehrerer spezialisierter Subsysteme und eines Arbeitsraums mit begrenzter Kapazität, der den Informationsaustausch zwischen den Subsystemen ermöglicht.

Bewertung bestehender Systeme anhand von Indikatoreigenschaften

Die Forschenden verwenden die so gefundenen Indikatoreigenschaften, um einige bestehende Systeme zu bewerten. So argumentieren sie etwa, dass großen Sprachmodellen wie GPT-3 die meisten Merkmale der GWT fehlen, während die Perceiver-Architektur zwar näher kommt, aber noch nicht alle Indikatoren der GWT erfüllt.

In Bezug auf verkörperte KI-Agenten untersuchen die Forscher PaLM-E von Google, ein "virtuelles Nagetier", und AdA von Google Deepmind. Das Team ist der Ansicht, dass KI-Agenten die Bedingungen für Agency und Embodiment erfüllen, wenn sie so trainiert werden, dass sie geeignete Muster lernen, die Handlungen mit Wahrnehmungen und Belohnungen verknüpfen. Das Team betrachtet AdA als das System, das nach ihren Kriterien am ehesten als verkörpert beschrieben werden kann.

Die Forschenden fordern abschließend robuste Methoden zu entwickeln, mit denen die Wahrscheinlichkeit von Bewusstsein in geplanten Systemen bewertet werden kann, bevor diese gebaut werden und will die eigene Forschung weiter vorantreiben.