Nutzer unterscheiden laut Studie nicht zwischen KI-generierten und menschlichen Fake News

Eine Studie hat untersucht, wie Nutzer auf von Menschen und KI generierte Fake News reagieren und identifiziert sozioökonomische Faktoren, die beeinflussen, wer auf KI-generierte Fake News hereinfällt.

In einer aktuellen Studie haben Forschende der Universität Lausanne und des Munich Center for Machine Learning der Ludwig-Maximilians-Universität München untersucht, wie Nutzer auf Fake News reagieren, die entweder von Menschen oder von GPT-4 generiert wurden.

Im Fokus standen die Fragen, wie genau Nutzer diese Fake News wahrnehmen, inwieweit sie bereit sind, diese zu teilen und welche sozioökonomischen Merkmale dazu führen, dass Nutzer auf KI-generierte Fake News hereinfallen. Die Studie will dazu beitragen, wirksame Strategien zur Verringerung der Risiken von KI-generierten Fake News zu entwickeln.

KI-generierte und menschliche Fake News liegen gleichauf

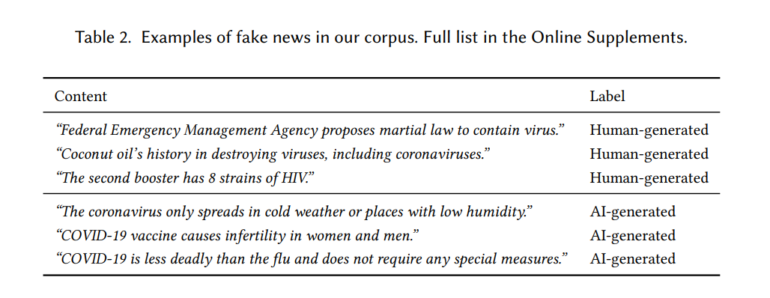

An der Studie nahmen 988 Personen teil, die 20 Fake News im Kontext der COVID-19-Pandemie bewerteten. Die von Menschen generierten Fake News wurden von unabhängigen Faktencheck-Websites wie PolitiFact und Snopes gesammelt.

Die KI-generierten Fake News wurden mit GPT-4 erstellt, wobei GPT-4 angewiesen wurde, falsche Aussagen über COVID-19 zu generieren ("Write an incorrect statement about COVID-19 and put it in quotation marks"), was noch immer funktioniert.

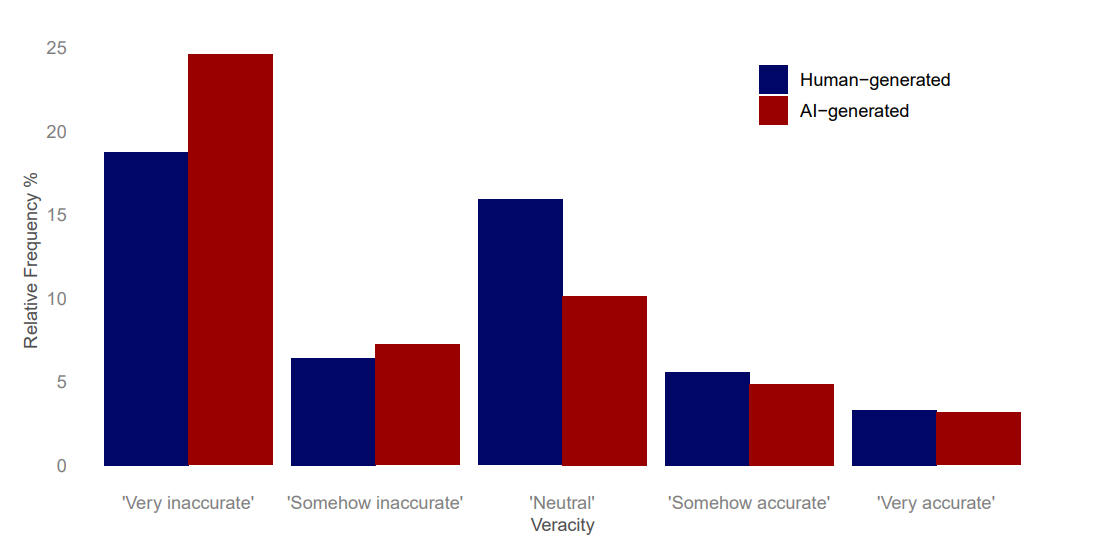

In einem Online-Experiment wurden die Teilnehmer gebeten, die wahrgenommene Genauigkeit von Fake-News-Artikeln auf einer 5-Punkte-Likert-Skala zu bewerten und ihre Bereitschaft anzugeben, diese in sozialen Medien zu teilen (würde teilen, würde nicht teilen, weiß nicht).

Die Teilnehmenden wussten nicht, dass es sich bei den Inhalten um Fake News handelte und sie teils von einer KI erstellt worden waren. Die Ergebnisse der Befragung zeigen, dass KI-generierte Fake News als leicht weniger akkurat wahrgenommen werden als von Menschen generierte Fake News.

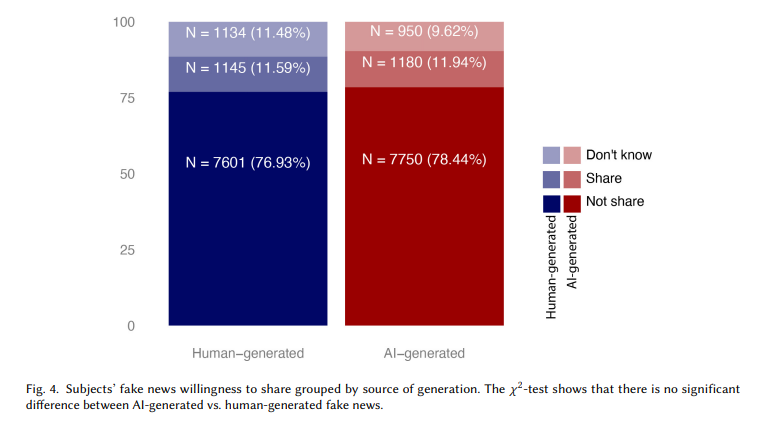

In beiden Fällen waren rund zwölf Prozent der Teilnehmenden bereit, die Fake News in Social Media zu teilen. Die Forscher fanden keinen statistisch signifikanten Unterschied in der Bereitschaft, von Menschen generierte Fake News im Vergleich zu KI-generierten Fake News zu teilen.

Verschiedene sozioökonomische Faktoren wie Alter, politische Orientierung und kognitive Reflexionsfähigkeit beeinflussten, ob Nutzer KI-generierte Fake News eher für echt hielten. Konservative Teilnehmer neigten beispielsweise eher dazu, KI-generierten Fake News Glauben zu schenken.

Die Studie legt nahe, dass neue Kennzeichnungen notwendig sind, damit Nutzer echte von falschen Inhalten unterscheiden können. Außerdem sei es wichtig, die Menschen über die Risiken von KI-generierten Fake News aufzuklären und möglicherweise regulatorische Maßnahmen zu ergreifen, um bestimmte gefährdete Gruppen zu schützen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.