Nvidia öffnet sein Chip-Ökosystem – neue Strategie für künftige KI-Infrastrukturen

Auf der Computex 2025 stellt Nvidia mit "NVLink Fusion" eine wichtige Neuerung vor: Künftig können auch Nicht-Nvidia-Chips mit Nvidia-GPUs kombiniert werden. Das soll die Position des Unternehmens im Zentrum der KI-Infrastruktur sichern.

Nvidia hat auf der Computex 2025 in Taiwan eine neue Initiative vorgestellt, die das bisher geschlossene Ökosystem des Unternehmens deutlich öffnet. Mit dem Programm "NVLink Fusion" sollen Kunden künftig CPUs und GPUs anderer Hersteller gemeinsam mit Nvidia-Produkten in KI-Rechenzentren einsetzen können – über Nvidias eigene Hochgeschwindigkeitsverbindung NVLink. Bislang war NVLink ausschließlich für Nvidia-eigene Chips zugänglich.

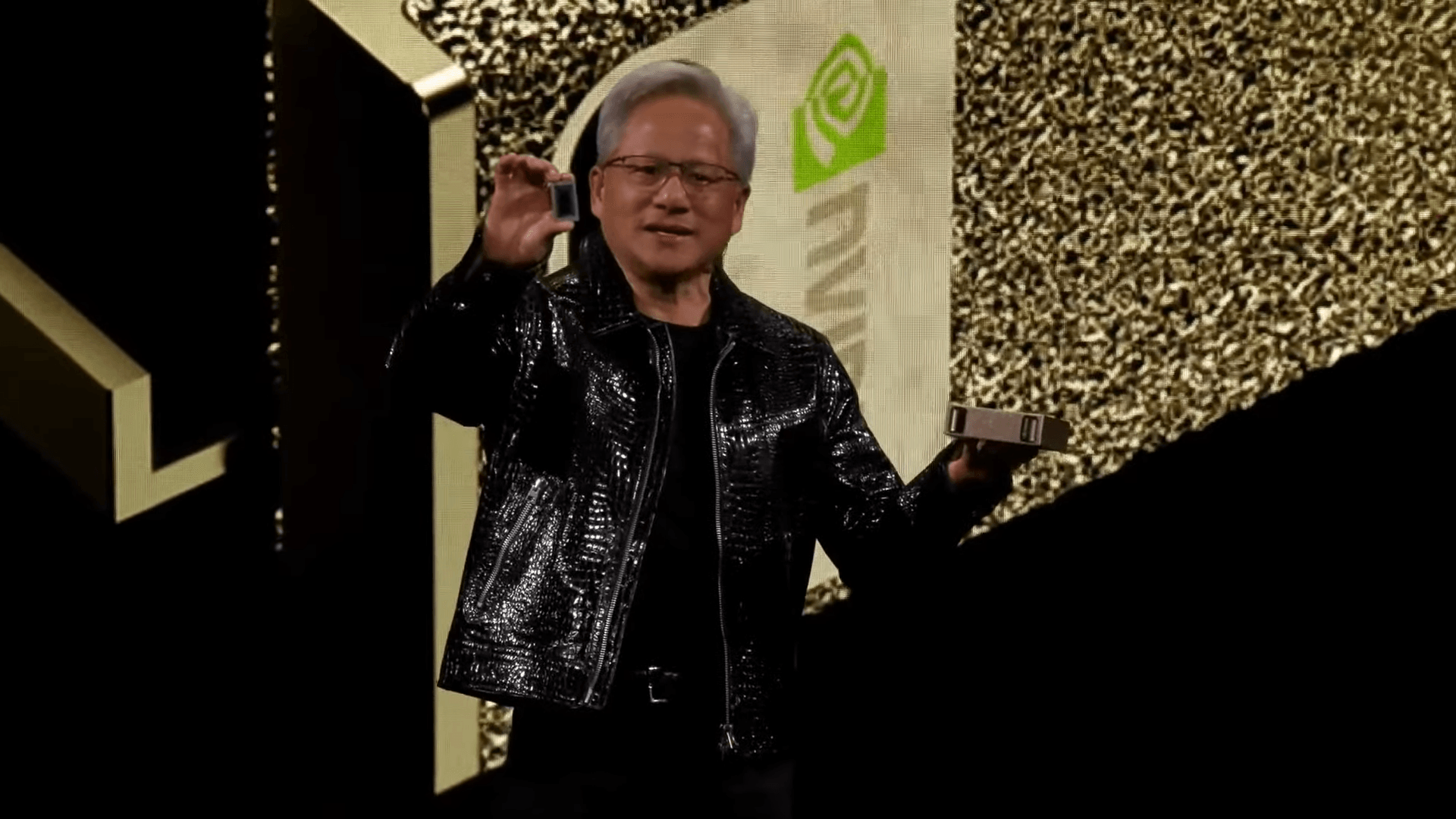

"NVLink Fusion ist dafür gedacht, halb-kundenspezifische KI-Infrastrukturen zu bauen, nicht nur halb-kundenspezifische Chips", sagte Nvidia-CEO Jensen Huang auf der Messe. Die Idee: Unternehmen können Nvidia-Prozessoren mit beliebigen CPUs oder anwendungsspezifischen Chips (ASICs) kombinieren und dabei weiterhin auf die NVLink-Infrastruktur und das dazugehörige Ökosystem zurückgreifen.

Zu den ersten Partnern des neuen Programms gehören unter anderem MediaTek, Marvell, Alchip, Astera Labs, Synopsys und Cadence. Unternehmen wie Fujitsu und Qualcomm sollen ihre eigenen Prozessoren künftig mit Nvidia-GPUs in Rechenzentren verbinden können, teilte das Unternehmen mit.

Für Nvidia ist das Programm ein strategischer Schritt: NVLink Fusion könnte Nvidia zum Zentrum der nächsten Generation von KI-Fabriken machen – selbst wenn diese nicht ausschließlich mit Nvidia-Chips ausgestattet sind. Wird NVLink Fusion von der Branche breit angenommen, könnte Nvidia seine Stellung im KI-Markt weiter ausbauen.

Große Konkurrenten wie Broadcom, AMD und Intel gehören allerdings bisher nicht zum NVLink-Fusion-Ökosystem.

Weitere Produktneuheiten und Ausbau in Taiwan

Mit "NVIDIA DGX Cloud Lepton" stellte das Unternehmen eine neue Cloud-Plattform vor, die Entwicklern Zugang zu zehntausenden GPUs aus einem globalen Netzwerk von Cloud-Anbietern ermöglichen soll. Ziel sei es, zuverlässige und performante GPU-Ressourcen über das Nvidia-Compute-Ökosystem hinweg bereitzustellen - Lepton dient dabei als Marktplatz. Laut Nvidia werde damit ein zentraler Engpass bei der KI-Entwicklung adressiert.

Darüber hinaus kündigte Huang ein neues Büro in Taiwan an. Gemeinsam mit dem taiwanischen Elektronikkonzern Foxconn will Nvidia dort auch ein KI-Supercomputerprojekt umsetzen. Auch Unternehmen wie TSMC sollen dabei gefördert werden.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.