Nvidias CEO Jensen Huang kündigt im Rahmen seiner GTC-Keynote zahlreiche Neuerungen für Nvidias KI-Geschäft an. Alle Informationen im Überblick.

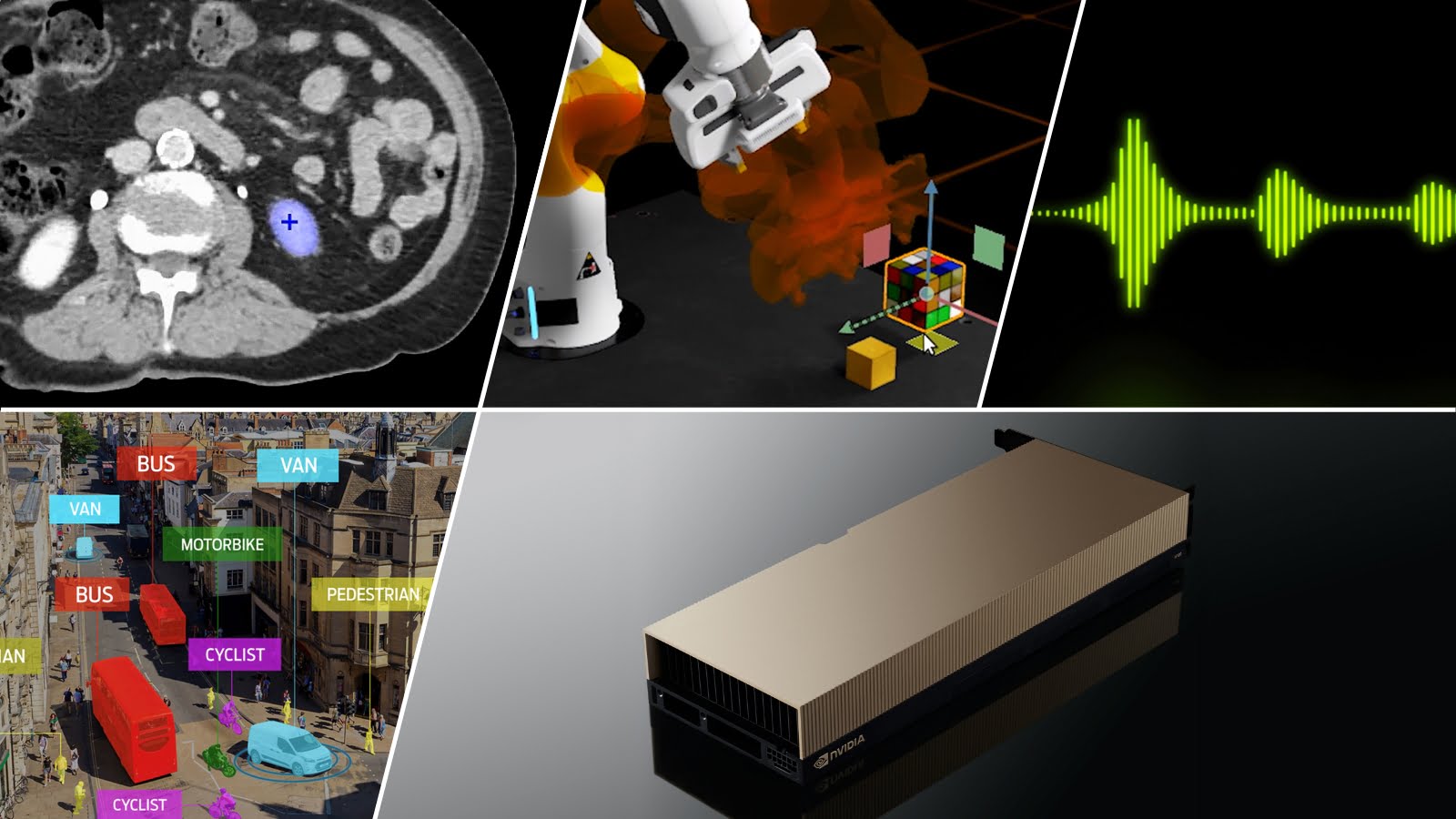

Im März stellte Nvidia das erste Mal die Hopper H100 GPU vor. Der KI-Beschleuniger soll Nvidias erfolgreiches A100-Modell ablösen und zeigte im jüngsten MLPerf-Benchmark eine bis zu 4,5-fach höhere Geschwindigkeit als A100-basierte Systeme.

Im Rahmen der GTC-Keynote kündigte Nvidias CEO Jensen Huang nun den Verkauf erster H100-Systeme von Partnern für den Oktober an. Die eigenen DGX H100-Systeme sollen im ersten Quartal 2023 ausgeliefert werden.

In einem gemischten KI-Workload von Training und Inferenz verschiedener KI-Modelle soll ein KI-Datencenter mit 64 HGX H100-Systemen eine Performance erreichen, die einem A100 Datencenter mit 320 HGX A100-Systemen entspricht.

Möglich ist dieser Sprung unter anderem durch die verbaute Transformer-Engine, die KI-Modelle mit Transformer-Architektur schneller verarbeiten kann.

Nvidia kündigt NeMo Sprachmodell-Service an

Große Sprachmodelle nehmen in der KI-Forschung und dem KI-Markt eine immer größere Rolle ein, so Nvidia. Die Anzahl an Transformer- und Sprachmodell-Papern sei seit 2017 rasant gestiegen. Hopper sei daher explizit für solche Modelle designt worden, so Nvidia.

In der Praxis soll Hopper das Training solcher Modelle um das Fünffache beschleunigen und die Ausführung um das 30-fache. Mit zehn DGX A100-Systemen könne man aktuell zehn gleichzeitige Nutzer:innen mit großen Sprachmodellen bedienen, mit zehn DGX H100-Systemen seien es 300, so das Unternehmen.

Mit diesem Fortschritt sei es nun für Unternehmen möglich, diese Modelle für spezifische Anwendungen, Domänen und Erfahrungen zu nutzen. Ermöglichen möchte Nvidia das mit der entsprechenden Hardware sowie einem Cloud-Service für große Sprachmodelle.

Mit Nvidia NeMo können Unternehmen große Sprachmodelle wie Megatron oder T5 an ihre Bedürfnisse per Nachtraining anpassen und einsetzen. Damit tritt Nvidia in direkte Konkurrenz zu anderen Anbietern großer Sprachmodelle. Der Fokus läge darauf, Unternehmen konkrete Produkte zu ermöglichen, so Nvidia.

Nvidia bringt KI-Hardware und Modelle für Medizin

Ein wichtiges Einsatzgebiet solcher großen Sprachmodelle sei die Medizin: Spezialisierte Varianten der Modelle sagen etwa Moleküle, Proteine oder DNA-Sequenzen vorher. Chemie und Biologie hätten ihre eigene Sprache, so Nvidia.

Mit dem BioNeMo Cloud-Service bringt das Unternehmen vortrainierte Modelle für Chemie und Biologie-Anwendungen, etwa ESM-1b, ein mit Proteindatenbanken trainiertes Sprachmodell, oder OpenFold, ein Modell, das Proteinfaltungen vorhersagt.

BioNeMo startet im Oktober im Early Access und ist Teil von Nvidias Clara-Framework für KI-Anwendungen für das Gesundheitswesen. Nvidia bringt zudem weitere Modelle für konkrete Anwendungen in der Medizin, wie Bilderkennung über Clara Holoscan.

Das Unternehmen kündigte zudem eine Kooperation mit dem Broad Institut an und bringt Clara auf die Terra Cloud Plattform, eine Open-Source-Plattform für biomedizinische Forschende.

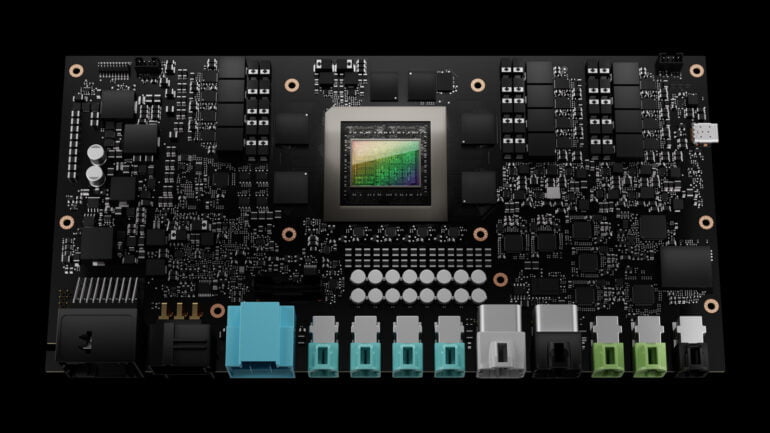

IGX-Systeme für Medizin und autonome Fabriken

Für den Medizinmarkt zeigte Nvidia das IGX-System, eine All-in-one-Plattform für die Entwicklung und den Einsatz von KI-Anwendungen in intelligenten Maschinen. IGX soll etwa Echtzeit-Bildanalyse via Holoscan ermöglichen. Unternehmen wie Activ, Moon Surgical oder Proximie sollen Holoscan mit IGX für ihre neuen Medizin-Plattformen nutzen.

Die IGX-Systeme sollen zudem in der industriellen Automatisierung zum Einsatz kommen und dort etwa intelligente Räume ermöglichen, in denen Kameras, LIDAR und Radarsensoren gleichzeitig verarbeitet werden. Die intelligenten Räume etwa in Fabriken verminderten Sicherheitsrisiken, weil Unternehmen sich nicht mehr ausschließlich auf die Sensorik in Robotern verlassen müssten, so Nvidia.

Jetson Orin Nano und Thor für die Edge

Für Edge-Berechnungen verwies Nvidia auf den neuen Jetson Orin Nano, der etwa in Robotern verbaut werden kann. Orin Nano soll im Vergleich zu Vorgänger eine 80-fach höhere Leistung bieten. Die KI-Modelle für Orin Nano können etwa in Nvidias Roboterumgebung Isaac Sim trainiert werden.

Im Markt für autonome Fahrzeuge zeigte Nvidia letztes Jahr die Entwicklung eines Atlan-Chips für 2024 mit 1.000 TOPS-Rechenleistung, das Vierfache des Orin-Chips. Autonome Fahrzeuge benötigten jedoch weitaus mehr Rechenleistung, um noch sicherer zu werden, so Nvidia. Man habe sich daher für die Entwicklung des Thor-Chips entschieden, der ganze 2.000 TOPS liefert.

Thor soll 2024 auf den Markt kommen und in Nvidia Drive Thor-System verbaut werden. Drive Thor ist ein zentralisierter Computer für autonome Fahrzeuge, der neben dem Thor-Chip auch eine Next-Gen GPU sowie eine Grace CPU umfasst. Nvidia will damit andere Computersysteme überflüssig machen. Drive Thor soll Linux, QNX und Android ausführen können und kommt mit der Transformer-Engine der Hopper GPUs.

Als erste Unternehmen habe der Autohersteller Zeekr sich für Thor entschieden. Mittlerweile nutzten 40 Unternehmen die Drive-Plattform, so Nvidia.

Die Plattform, die auch für das Training autonomer Fahrzeuge ausgelegt ist, erhält zudem Updates wie eine Neural Engine, die in der echten Welt aufgezeichnete Fahrten in einer realistischen Simulation wiedergeben kann. Das soll etwa das Training von Edge-Cases vereinfachen.