Nvidia will KI-Agenten-Entwicklung mit fertigen Blaupausen beschleunigen

Der Chip-Hersteller Nvidia stellt "Blueprints" vor - vorgefertigte Bauanleitungen für agentische KI-Systeme. Zusammen mit neuen Sprachmodellen sollen sie Entwicklern den Einstieg in autonome KI-Agenten erleichtern.

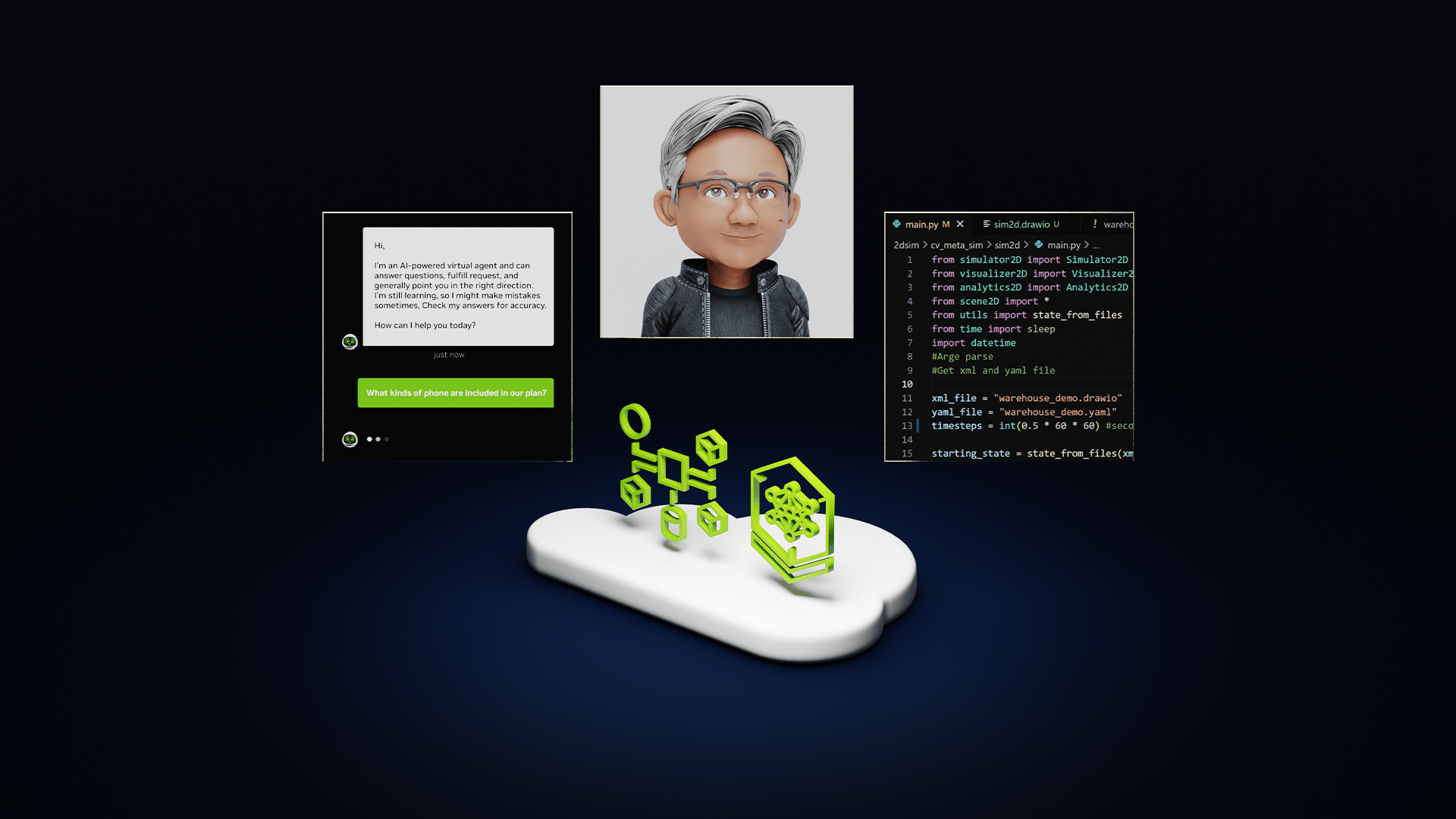

Nvidia will die Entwicklung von KI-Agenten mit einer neuen Art von Bauanleitung vereinfachen. Die sogenannten "Blueprints" enthalten nach Angaben des Unternehmens alle notwendigen Komponenten und Konfigurationen, damit Entwickler nicht bei null anfangen müssen.

Die Blueprints werden als "Launchables" bereitgestellt - fertig konfigurierte Entwicklungsumgebungen, die sich sofort starten lassen. Ziel sei es, KI-Systeme zu schaffen, die komplexe Aufgaben selbstständig planen und ausführen können.

Fünf KI-Unternehmen haben bereits eigene, spezialisierte Blueprints entwickelt: CrewAI für automatische Codedokumentation, Daily für Sprach-KI-Agenten, LangChain für die Erstellung strukturierter Berichte, LlamaIndex für Recherche-Assistenz bei Blogbeiträgen und Weights & Biases für virtuelle KI-Assistenten.

Nvidia selbst steuert zwei Blueprints bei: Einen für die Umwandlung von PDFs in Podcasts und einen für die Video-Analyse. Der Video-Blueprint soll laut Nvidia 30-mal schneller arbeiten als eine Echtzeit-Analyse in Echtzeit.

Die praktische Umsetzung der Blueprints erfolgt über die Nvidia AI Enterprise Software. Sie lässt sich sowohl in Rechenzentren von Dell, HPE, Lenovo und Supermicro als auch in Cloud-Diensten von AWS, Google, Microsoft und Oracle einsetzen.

Neue Nemotron-Modelle für Nvidia-Agenten

Die technische Basis für die Blueprints bildet die neue Nemotron-Modellfamilie, die wiederum auf Metas Llama basiert. Sie besteht aus dem Llama Nemotron für Textverarbeitung und dem Cosmos Nemotron für Bildanalyse.

Die Llama-Nemotron-Modelle wurden laut Nvidia mit den neuesten Techniken und hochwertigen Datensätzen für den agentischen Einsatz optimiert. Nach Angaben des Unternehmens zeichnen sie sich besonders durch ihre Fähigkeiten in den Bereichen Instruktionsverarbeitung, Chat, Funktionsaufrufe, Programmierung und Mathematik aus.

Die Modelle kommen in drei Größen: Nano für Echtzeitanwendungen auf PCs, Super für hohe Genauigkeit auf einzelnen GPUs und Ultra für Rechenzentrumsanwendungen.

Entwickler im Nvidia Developer Program können die Modelle bald über gehostete APIs nutzen oder direkt von build.nvidia.com und Hugging Face für "Tests und Forschung" herunterladen. Geschäftskunden erhalten das komplette Paket - einschließlich NeMo, NeMo Retriever und beiden Nemotron-Modellen als NIM-Microservices - über Nvidias zuvor erwähnte AI Enterprise Plattform.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.