Nvidias EmerNeRF soll selbstfahrende Autos sicherer machen

EmerNeRF lernt 3D-Repräsentationen der realen Welt und soll so Robotern und autonomen Autos helfen, sich sicher zu orientieren.

Forschende der University of Southern California, des Georgia Institute of Technology, der University of Toronto, der Stanford University, Technion und von Nvidia haben EmerNeRF entwickelt. Das KI-Modell kann anhand von Videoaufnahmen selbstständig erkennen, welche Teile einer Verkehrsszene sich bewegen und welche statisch sind.

Für selbstfahrende Autos oder andere Roboter, die sich in der realen Welt bewegen, ist es entscheidend zu erkennen, welche Elemente in ihrer Umgebung statisch sind und welche sich bewegen. Nur so können sie sich in der Welt orientieren und sicher mit ihr interagieren. Beim autonomen Fahren werden daher beispielsweise Verkehrsszenen in statische und sich bewegende Objekte wie andere Fahrzeuge unterteilt. Dieser Prozess erfordert heute jedoch meist eine menschliche Überwachung - das ist teuer und schlecht skalierbar.

EmerNeRF lernt selbst-überwacht und schlägt ältere Methoden

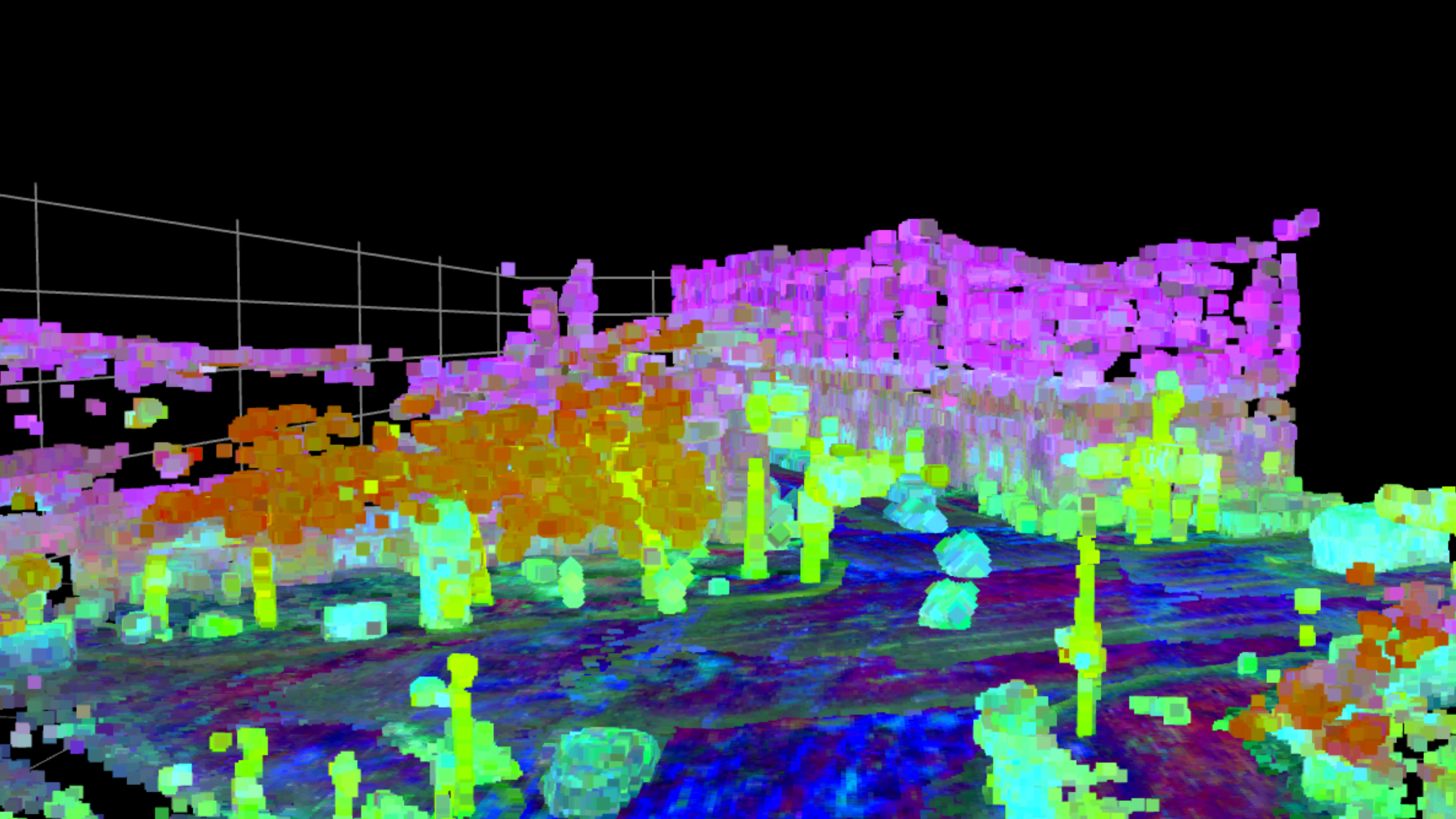

EmerNeRF hingegen lernt die Einteilung völlig autonom aus Kamera- und LiDAR-Aufnahmen. Für EmerNeRF nutzten die Forschenden die namensgebenden neuronalen Strahlungsfelder: eines für statische, eines für bewegte Repräsentationen. Das Programm optimiert diese Felder so, dass die Nachbildungen der Szenen möglichst realistisch aussehen - ohne Information darüber, welche Objekte statisch oder bewegt sind.

Um bewegte Objekte besser wiedergeben zu können, berechnet EmerNeRF zusätzlich ein Strömungsfeld, das darstellt, wie sich die Objekte im Laufe der Zeit bewegen. Mit dieser Bewegungsinformation kann es Daten aus mehreren Zeitpunkten kombinieren, um bewegte Objekte detaillierter darzustellen.

Durch das Training war EmerNeRF dann in der Lage, dynamische Szenen wie Videoaufnahmen von Autofahrten ohne menschliche Markierungen direkt in statische und bewegte Elemente zu trennen. Zusätzlich verbesserte das Team EmerNeRF mit Teilen eines Foundation-Modells für 2D-Bilder und konnte so die Leistung bei der Erkennung von Objekten in 3D-Umgebungen um durchschnittlich knapp 38 Prozent steigern.

Video: Yang et al.

In einem anspruchsvollen Benchmark mit 120 Fahrszenen übertrifft EmerNeRF bisherige State-of-the-Art-Methoden wie HyperNeRF und D2NeRF deutlich.

Mehr Informationen, Videos und den Code gibt es auf GitHub.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.