Auf der Oculus Connect 5 gab es neben den großen Keynotes zahlreiche Vorträge für Entwickler. Besonders interessant: Das Unternehmen Deep Motion stellte ein KI-gestütztes Animationssystem für digitale Charaktere vor.

Das kalifornische Unternehmen Deep Motion ist auf die physikbasierte Animation digitaler Charaktere spezialisiert. Im Connect-Vortrag sprach Gründer Kevin He über den Weg von vorprogrammierten hin zu interaktiven Bewegungen.

Vorprogrammierte Bewegungen, wie sie zum Beispiel bei Motion-Capture-Verfahren entstehen, sind nicht flexibel. Sie laufen immer gleich ab und reagieren nicht in Echtzeit auf Veränderungen in der Umgebung.

Seit Jahren gibt es daher Versuche, digitale Charaktere realistisch und flexibel auf die Umgebung reagieren zu lassen: 1998 erschien mit dem seltsamen, aber innovativen „Jurassic Park: Trespasser“ das erste Videospiel mit Ragdoll-Engine. 2008 setzte GTA IV die Euphoria Engine ein.

Deep Motion möchte diese Ansätze deutlich übertreffen: Figuren sollen jederzeit dynamisch und physikalisch korrekt auf ihre Umgebung reagieren. Die Firma entwickelt dafür eine KI-gestützte Physik-Engine, die digitalen Charakteren Bewegungen von Grund auf antrainiert.

Physik und Balance

Deep Motion nutzt dasselbe Deep-Learning-Prinzip wie andere KI-Verfahren, die Charakteren Bewegungen beibringen sollen: Im ersten Schritt lernt die Figur, ihre Balance zu halten, zu laufen und sich von einem Sturz zu erholen.

Deep Motion simuliert dafür die Umgebungsphysik sowie die Gelenke und Muskeln der Figur. Schon diese einfachen Grundlagen ermöglichen realistische Charaktere und interaktive Bewegungen.

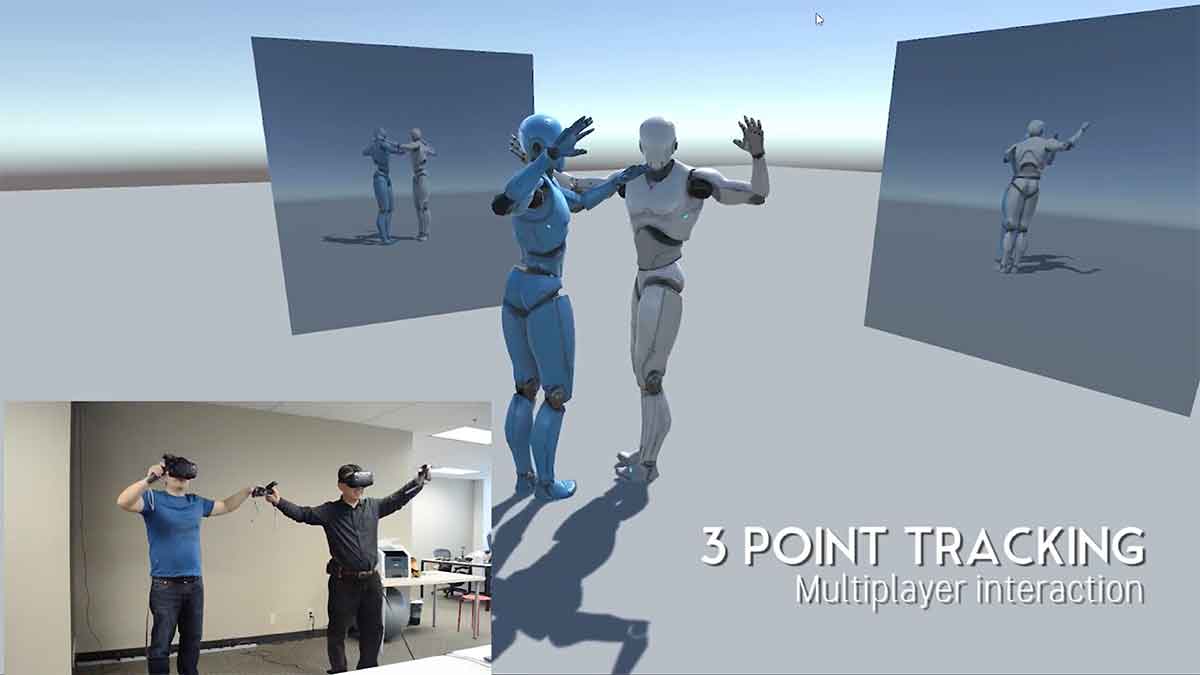

Die physikbasierten Charaktere können anschließend in VR eingesetzt werden. Selbst mit nur einem Trackingsensor sind realistische Bewegungsabläufe möglich.

Egal, wo der Trackingsensor am realen Körper sitzt, die Avataranimation passt sich realistisch den Sensordaten an. Jede Bewegung des Charakters folgt den Regeln der Physik und den biologischen Möglichkeiten. Verdrehte Handgelenke und Ellbogen gehören so der Vergangenheit an.

Mit den klassischen drei Trackern (VR-Brille und zwei Controller) sind komplexe Interaktionen möglich. So können zwei VR-Nutzer miteinander tanzen oder kämpfen. Ihre Gliedmaßen bewegen sich realistisch und reagieren aufeinander.

Künstliche Intelligenz lernt Parcours

Um die Charaktere noch glaubhafter und flexibler zu gestalten, nutzt Deep Motion Künstliche Intelligenz. Als Grundlage dienen die sich selbst ausbalancierenden, physikbasierten Charaktere.

Mit verstärkendem Lernen wird ein solcher Charakter mit Motion-Capture-Aufnahmen trainiert. So lernt der Charakter laufen, springen oder aufstehen.

Die Referenzszenen können unterschiedlich komplex sein: ein kurzer Clip eines Joggers oder ein mehrstufiger Bewegungsablauf eines Parcours-Läufers - beides funktioniert als Lernmaterial.

Durch zahlreiche Wiederholungen mit minimalen Justierungen wird der Bewegungsablauf des digitalen Charakters immer glaubhafter. Anschließend werden mehrere Bewegungsabläufe kombiniert. So entsteht eine interaktive Bewegungsintelligenz, die auf alle Hindernisse passend reagieren kann.

Kevin He zeigt als Beispiel einen digitalen Parcours-Läufer mit natürlich wirkendem Bewegungsablauf. Bemerkenswert ist, dass die Bewegungen - wie im echten Leben - nie exakt gleich aussehen.

Ein weiteres Beispiel für die interaktive Bewegungsintelligenz: Deep Motion entwickelte kürzlich in Kooperation mit Forschern der Carnegie Mellon University einen digitalen Basketballer, der seine Dribblingfähigkeiten anhand von Motion-Capture-Aufnahmen realer Basketballer lernte.

Deep Motions Technologie ist schon verfügbar

Deep Motions Ziel sind Charaktere, die in ihrem Bewegungsverhalten Mensch und Tier gleichen. Das erlaube glaubwürdige und realistische Avatare für VR und AR, so He.

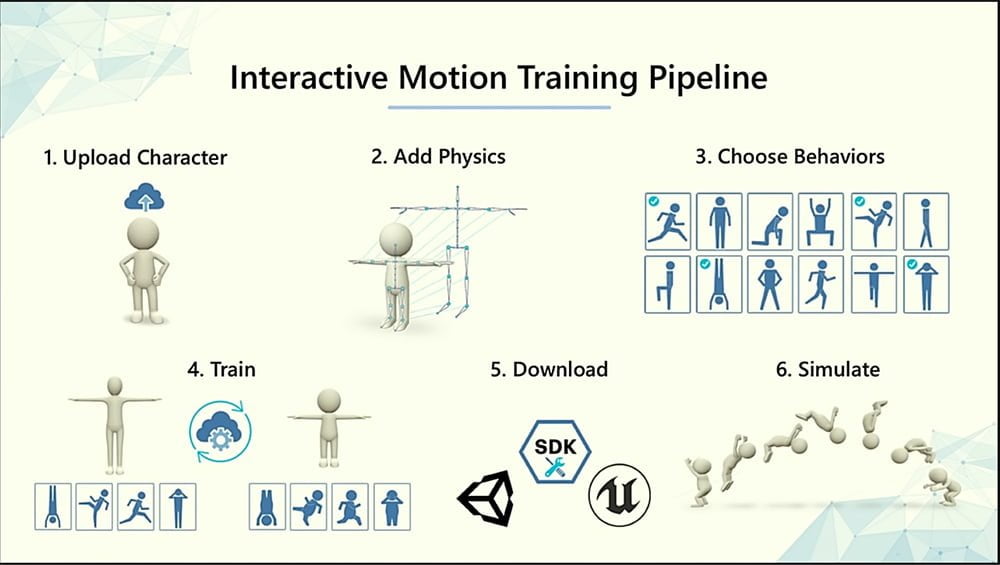

Das Unternehmen bietet Entwicklern Werkzeuge für Unity und die Unreal Engine 4 an. Mit diesen können Entwickler Bewegungsmodelle für ihre eigenen Charaktere über Deep Motions Cloud trainieren.

Den kompletten Vortrag von der Oculus Connect 5 gibt es im folgenden Video: