OpenAI beschleunigt KI-Bildgenerierung um das 50-fache

OpenAI stellt eine neue Methode vor, die das Training von KI-Bildmodellen dramatisch vereinfacht und beschleunigt.

OpenAI hat eine neue Methode namens sCM (für "simplified, stabilized and scaled Consistency Models") vorgestellt, die das Training von Consistency Models (CMs) für die Bilderzeugung verbessert. CMs sind eine Klasse von diffusionsbasierten generativen Modellen, die für schnelles Sampling optimiert sind und an denen das Unternehmen schon länger forscht.

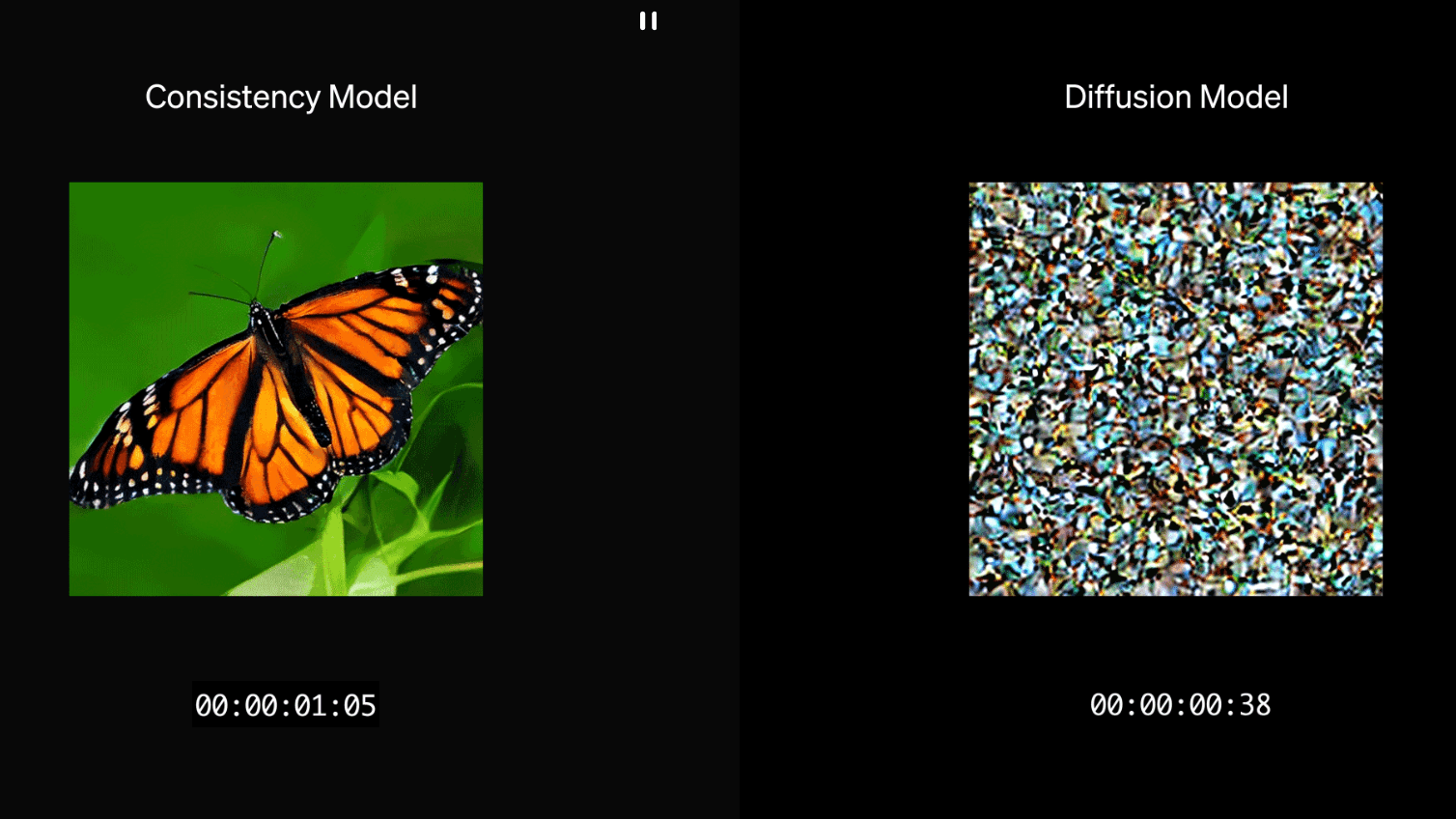

Die als "sCM" bezeichnete Methode macht das Training dieser Modelle stabiler und skalierbarer. Laut OpenAI können die neuen Modelle bereits mit nur zwei Berechnungsschritten hochwertige Bilder erzeugen. Bisherige Methoden benötigten dafür deutlich mehr Schritte. Nach Angaben von OpenAI erreicht das größte sCM-Modell mit 1,5 Milliarden Parametern eine Generierungszeit von nur 0,11 Sekunden pro Bild auf einer A100-GPU - und das ohne spezielle Optimierungen. Im Vergleich zu herkömmlichen Diffusionsmodellen bedeute dies eine 50-fache Beschleunigung.

Technischer Durchbruch bei der Bildgenerierung

Nach Angaben von OpenAI löst die neue Methode ein grundlegendes Problem: Bisherige Consistency Models arbeiteten mit diskreten Zeitschritten, was zusätzliche Parameter erforderte und fehleranfällig war. Die Forscher entwickelten dafür ein vereinfachtes theoretisches Framework, das verschiedene Ansätze vereint. Damit konnten sie die Hauptursachen für Instabilitäten beim Training identifizieren und beheben.

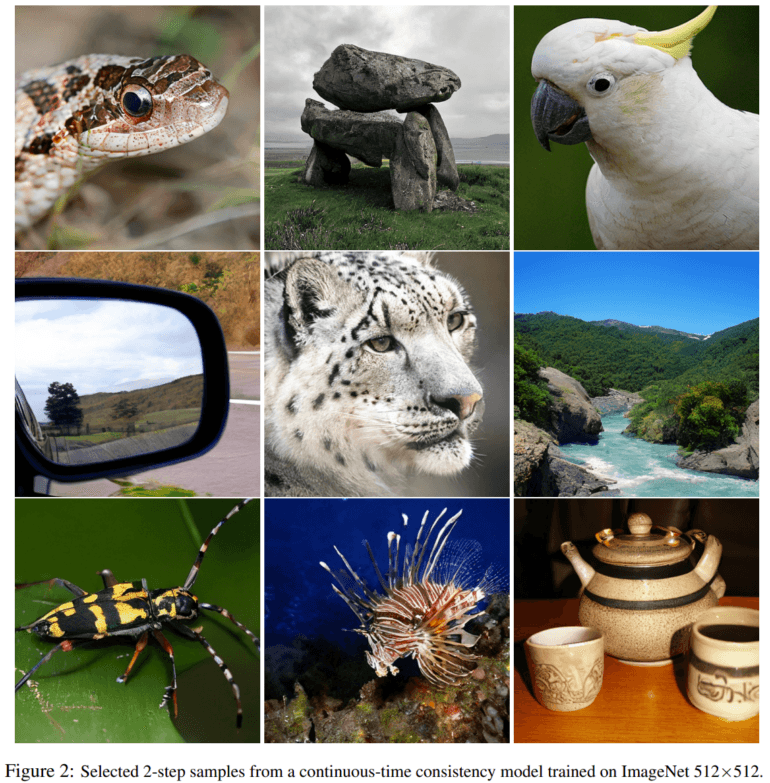

Das Ergebnis ist beeindruckend: In Tests erreichte das System mit nur zwei Rechenschritten FID-Scores von 2,06 auf dem CIFAR-10-Datensatz und 1,88 auf ImageNet mit 512x512-Pixel-Bildern - die Qualität der generierten Bilder liegt nach diesen Maßstäben nur noch knapp zehn Prozent hinter den besten bisherigen Diffusionsmodellen zurück.

Skalierung auf Rekordgröße möglich

Ein weiterer Vorteil der neuen Methode ist ihre Skalierbarkeit. OpenAI konnte damit erstmals Modelle mit bis zu 1,5 Milliarden Parametern auf dem ImageNet-Datensatz trainieren - eine bisher unerreichte Größenordnung für diese Art von Modellen. Die Forscher beobachteten dabei, dass die Qualität der generierten Bilder mit zunehmender Modellgröße kontinuierlich steigt.

Das deute darauf hin, dass sich die Methode auch für noch größere Modelle eignen könnte. Das ist ein wichtiger Aspekt für die weitere Entwicklung von KI-Bildgenerierung - und womöglich darüber hinaus für Video-, Audio- und 3D-Modelle.

Mehr Details und Beispiele gibt es im Blogpost von OpenAI.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.