OpenAI hat einen 99,9 % genauen ChatGPT-Text-Detektor, veröffentlicht ihn aber nicht

Update –

- OpenAIs Update ergänzt

Update vom 5. August 2024:

Nach der Berichterstattung des Wall Street Journal hat OpenAI einen älteren Blogpost zum Thema KI-Inhaltserkennung aktualisiert. Darin wird die Existenz des Watermarking-Detektors bestätigt.

Dieser sei zwar sehr genau und effektiv gegen punktuelle Veränderungen, aber weniger effektiv gegen globale Veränderungen wie Übersetzungen oder das Umschreiben mit einem anderen KI-Modell oder Sonderzeichen zwischen Wörtern, die dann gelöscht werden.

Die Umgehung des Detektors sei letztlich trivial. Außerdem könnte der Detektor bestimmte Gruppen stigmatisieren, etwa Menschen, die Tools wie ChatGPT verwenden, um bessere englische Texte zu schreiben.

Obwohl die Text-Wasserzeichen-Methode prinzipiell eine geringe Falsch-Positiv-Rate aufweist, würde ihre Anwendung auf große Textmengen insgesamt zu einer hohen Anzahl von Falsch-Positiven führen.

OpenAIs Teams erforschen daher auch, wie Metadaten als Methode zur Herkunftsbestimmung von Texten verwendet werden könnten. Das Unternehmen befinde sich noch in einem frühen Erkundungsstadium, sodass es zu früh sei, um die Wirksamkeit des Ansatzes zu beurteilen.

Es gebe jedoch Merkmale von Metadaten, die diesen Ansatz besonders vielversprechend machen würden. Im Gegensatz zu Wasserzeichen seien Metadaten etwa kryptografisch signiert, was bedeutet, dass es keine falsch-positiven Ergebnisse gibt.

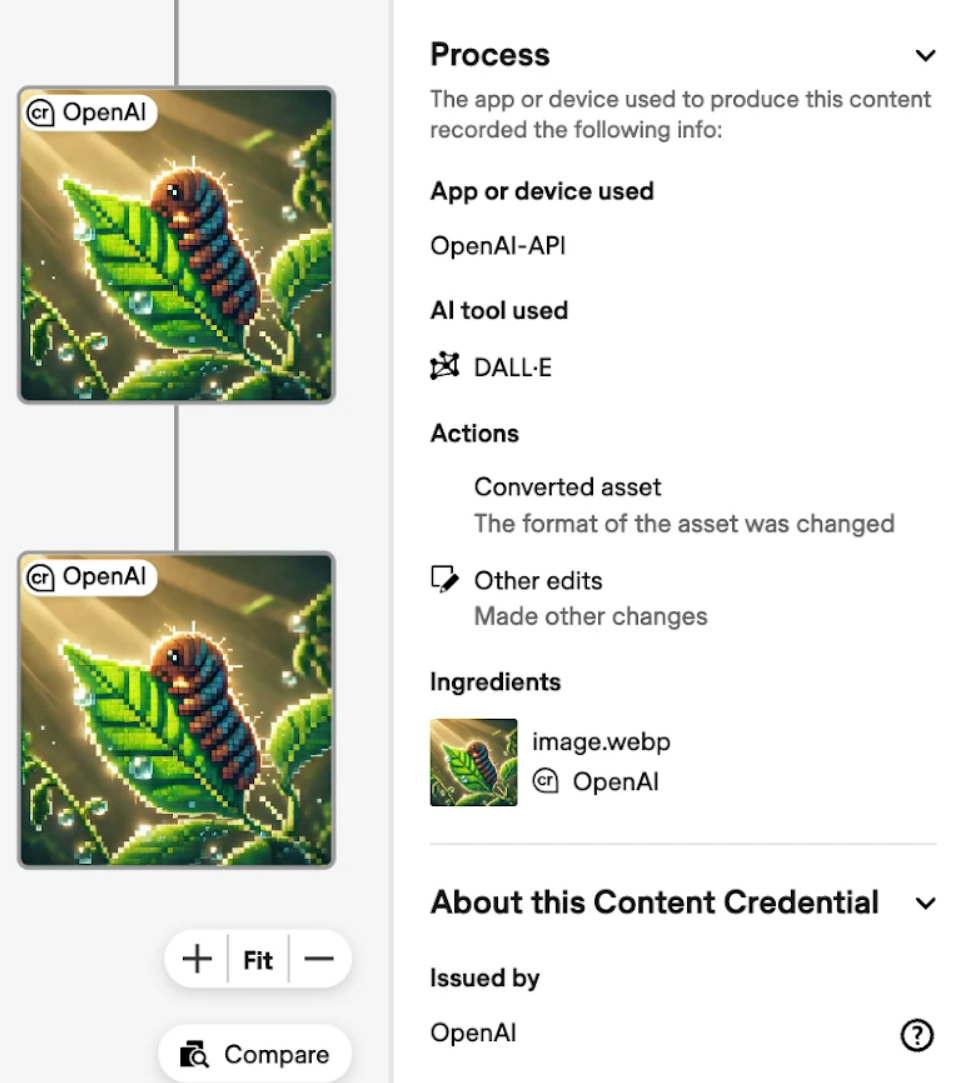

OpenAI gibt audiovisuellen Inhalten Priorität, da diese derzeit als risikoreicher eingestuft werden. In DALL-E 3 gibt es ein Update für die Herkunftsbestimmung von Bildern: Die C2PA-Herkunftsinformationen können aktualisiert werden und zeigen, ob und wie das KI-Bild nach der ersten Erstellung weiter bearbeitet wurde.

Ursprünglicher Artikel vom 4. August 2024:

OpenAI verfügt Insidern zufolge über eine Technologie, um KI-generierte Texte zuverlässig zu erkennen. Doch das Unternehmen scheut eine Veröffentlichung, wohl auch aus Sorge um das eigene Geschäftsmodell.

OpenAI hat laut eines Berichts des Wall Street Journals unter Berufung auf interne Quellen und Dokumente einen verlässlichen KI-Text-Detektor entwickelt, zögert aber mit der Veröffentlichung. Das Projekt werde seit etwa zwei Jahren intern diskutiert und sei seit rund einem Jahr einsatzbereit.

Eine Veröffentlichung sei "nur eine Frage eines Knopfdrucks", heißt es. Doch OpenAI soll zwischen dem Wunsch nach Transparenz und den Ansprüchen der eigenen Nutzer schwanken.

Eine interne Umfrage unter ChatGPT-Nutzern ergab, dass fast ein Drittel von einem Text-Detektor abgeschreckt würden. In einer weltweiten, ebenfalls von OpenAI beauftragten Umfrage unterstützten Menschen KI-Erkennung und -Transparenz allerdings im Verhältnis 4:1.

Wasserzeichen sollen KI-Texte erkennbar machen

Eine OpenAI-Sprecherin erklärte, dass die auf einem Wasserzeichen basierende Methode nicht Englisch-Muttersprachler besonders treffen könne. Die Wasserzeichen wäre für das menschliche Auge nicht wahrnehmbar, könnten aber mit der Erkennungstechnologie von OpenAI gefunden werden. Die Textqualität soll dadurch nicht beeinträchtigt werden.

Der Detektor liefert eine Bewertung, wie wahrscheinlich es ist, dass das gesamte Dokument oder ein Teil davon von ChatGPT geschrieben wurde. Mit einer ausreichenden Menge an Text soll die Methode zu 99,9 Prozent effektiv sein.

Allerdings ist unklar, wie zuverlässig der Detektor nach umfangreichen Eingriffen in den Text, nach Übersetzungen oder dem Einfügen und Löschen von Emoticons noch funktioniert. Zudem könnten Anbieter anderer Sprachmodelle auf ein solches Wasserzeichen verzichten. Die Lösung von OpenAI wäre dann nur für ChatGPT exklusiv und könnte dazu führen, dass Interessierte auf alternative LLMs ausweichen, die qualitativ stark auf ChatGPT-4 aufgeholt haben.

OpenAI-Mitarbeitende haben auch darüber diskutiert, den Detektor direkt an Pädagogen oder an externe Unternehmen zu liefern, die Schulen oder Unternehmen dabei helfen, von KI geschriebene Arbeiten und plagiierte Werke zu identifizieren.

Das Tool soll der Arbeit von Scott Aaronson entspringen, einem Informatikprofessor, der in den vergangenen zwei Jahren während seiner Beurlaubung von der University of Texas an der Sicherheit bei OpenAI gearbeitet hat. Ende 2022 sagte Aaronson, OpenAI wolle die Arbeit in den kommenden Monaten genauer vorstellen, bisher ist nichts passiert.

Zuletzt soll OpenAI Anfang Juni über die Wasserzeichen-Methode diskutiert haben, mit dem Beschluss, alternative Methoden, die weniger kontrovers sind, zu bewerten. Bis zum Herbst müsse intern ein Plan vorliegen, um die öffentliche Meinung und Gesetze zu diesem Thema zu beeinflussen. Ohne diesen Plan riskiere man die "Glaubwürdigkeit als verantwortungsbewusste Akteure".

KI-Texterkennung könnte OpenAIs Geschäftsmodell gefährden

Interessant ist diese Nachricht auch vor dem Hintergrund, dass OpenAI bereits einen Text-Detektor veröffentlicht hatte, diesen aber im Sommer 2023 wegen zu geringer Genauigkeit zurückzog. Nun zeigt sich, dass die damals noch geringe Genauigkeit wohl nicht der einzige Grund war. Zum Zeitpunkt des Rückzugs dieses Detektors war der neue laut WSJ zumindest schon in Arbeit.

Ein gut funktionierender Text-Detektor könnte OpenAI ins Geschäftsmodell funken. Wenn Menschen Texte auf der Grundlage bewerten, ob KI ihn verfasst oder daran mitgewirkt hat, könnten sämtliche KI-Texte entwertet werden.

Eine Studie legt nahe, dass das mindestens bei privaten Nachrichten der Fall ist, da die Menschen hier die menschliche Leistung, das "Selbermachen", besonders schätzen. In diesem Fall würde ein Großteil der mit OpenAIs-Werkzeugen erzeugten Ergebnisse an Wert verlieren.

Andererseits: Auch bei KI-Suchmaschinen wie SearchGPT oder Perplexity müssen sich Menschen letztlich mit KI-generiertem Text begnügen, auch wenn dieser direkt aus von Menschen geschriebenem Text generiert wird. Manche glauben, dass diese Art der KI-Textgenerierung eine große kommerzielle Zukunft hat.

Bildungseinrichtungen, die jetzt unter KI-Aufsätzen und Hausaufgaben leiden, könnten mit OpenAIs Tool den ChatGPT-Einsatz nachweisen und müssten sich nicht oder weniger auf KI als Teil des Bildungsprozesses einlassen. Die Disruption des Bildungssystems durch KI würde zunächst ausgebremst.

Ein zuverlässiger KI-Text-Detektor könnte jedoch auch dazu beitragen, Missbrauch einzudämmen, etwa um automatisierte KI-Desinformationskampagnen schneller als solche zu entlarven.

Möglicherweise wird sich im Laufe der Zeit, wenn LLMs alltäglich in die Arbeitsprozesse integriert sind, ein kultureller Wandel vollziehen, bei dem es weniger darum geht, wie ein Text entstanden ist, sondern vielmehr darum, was darin steht und was die Person, die ihn veröffentlicht, damit sagen will.

Wenn "mit KI erstellt" kein Malus, sondern nur eine Zustandsbeschreibung wäre, könnte ein zuverlässiges Werkzeug primär dazu dienen, schädliche Anwendungsszenarien zu verhindern.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.