Die Programmier-KI "Copilot" von OpenAI, Github und Microsoft setzt auf OpenAIs KI-Modell Codex. Das soll bald über OpenAIs API direkt verfügbar sein. Noch vor der Veröffentlichung von Codex kündigt OpenAI jetzt die "nächste Generation" des KI-Modells an.

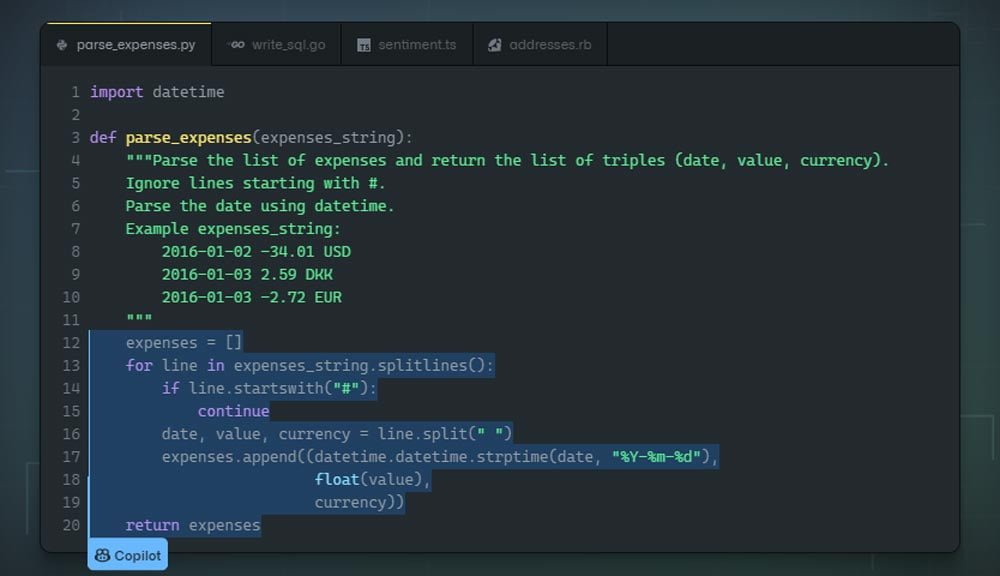

Githubs Copilot entstand im Rahmen einer Partnerschaft von Microsoft und OpenAI: Die Software bietet Programmierern KI-gestützte Code-Vorschläge und -Feedback in Echtzeit. Sie unterstützt dutzende Programmiersprachen wie JavaScript, Python, TypeScript oder Ruby. Copilot basiert auf OpenAIs Codex, einer Art GPT-3 für Code.

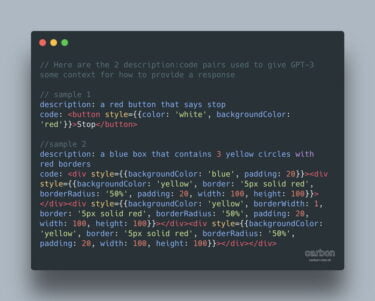

Laut OpenAI wurde Codex mit Milliarden bei Github und anderen Internetquellen verfügbaren Code-Zeilen und englischen Sprachdaten trainiert. Durch das KI-Training lernt sie mit steigender Genauigkeit, natürliche Sprache direkt in Code zu verwandeln.

Im Rahmen der Vorstellung von Copilot versprach OpenAI, den Zugang zu Codex über die eigene API-Schnittstelle noch im Sommer zu ermöglichen. Durch den API-Zugang sollen alle OpenAI-Kunden die Möglichkeit haben, die KI-Programmiervorschläge direkt zu nutzen oder in eigene Software zu integrieren.

Laut Microsoft sei auch ein Codex-Modell möglich, das Unternehmen spezifisch für ihre eigenen Programmierbedürfnisse anpassen können. OpenAI bietet die Möglichkeit zum Nachtraining bereits für die Text-KI GPT-3 an.

OpenAI Codex: Die zweite Generation könnte ein zentrales Problem von Copilot lösen

Auf Twitter kündigt OpenAI jetzt die "nächste Generation von Codex" an. Im Rahmen der Vorstellung könnte OpenAI auch den Zugang zu Codex über die API ermöglichen.

Welche Verbesserungen die neue Generation von Codex bringen wird, verrät OpenAI bei einem Live-Stream am 10. August. Die neue Version könnte unter anderem eine Antwort bieten auf die Frage nach möglichen Urheberrechtsverletzungen durch Codex.

Live demo of the next generation of OpenAI Codex, our AI that writes code, on Twitch at 10am PT, Tues Aug 10th. ? https://t.co/CRx0goxVrh pic.twitter.com/ETLdBmb0Xc

— OpenAI (@OpenAI) August 4, 2021

Wahrscheinlich wird sich die verbesserte Version jedoch einem zentralen Problem widmen, das die KI-Forscher in ihrem im Juli veröffentlichten Codex-Paper aufdeckten: Da die Code-KI wie GPT-3 darauf trainiert wurde, das nächste Token ausgehend vom bisherigen Kontext vorherzusagen, hat das System gelernt, dass auf fehlerhaften Code häufig mehr fehlerhafter Code folgt.

In der Praxis bedeutet das: Liefert ein Nutzer Beispiel-Code mit Fehlern, generiert das KI-Modell mit höherer Wahrscheinlichkeit weitere Fehler. Dieser Effekt nimmt mit zunehmender Modellgröße zu, sodass ein eigentlich leistungsstärkeres Modell häufiger Fehler erzeugt, wenn der Input-Code ebenfalls Bugs enthält.

Laut der Autoren zeigt Codex daher noch erheblichen Spielraum für Verbesserungen - schließlich kann das KI-Modell prinzipiell fehlerfreien Code generieren. Eine Live-Demo der neuen Codex-Version gibt es am 10. August um 19 Uhr deutscher Zeit auf OpenAIs Twitch-Channel.

Titelbild: Github