OpenAI veröffentlicht ein Paper über die neue Bild-KI DALL-E 3, das erklärt, warum die neue Bild-KI Prompts viel genauer befolgt als vergleichbare Systeme.

Im Zuge des vollständigen Rollouts von DALL-E 3 veröffentlicht OpenAI ein Paper über DALL-E 3: Es beschäftigt sich mit der Frage, warum DALL-E 3 den Prompts im Vergleich zu bestehenden Systemen so genau folgen kann. Die Antwort ist bereits im Titel des Papers enthalten: "Optimierung der Bilderzeugung durch bessere Bildbeschriftung".

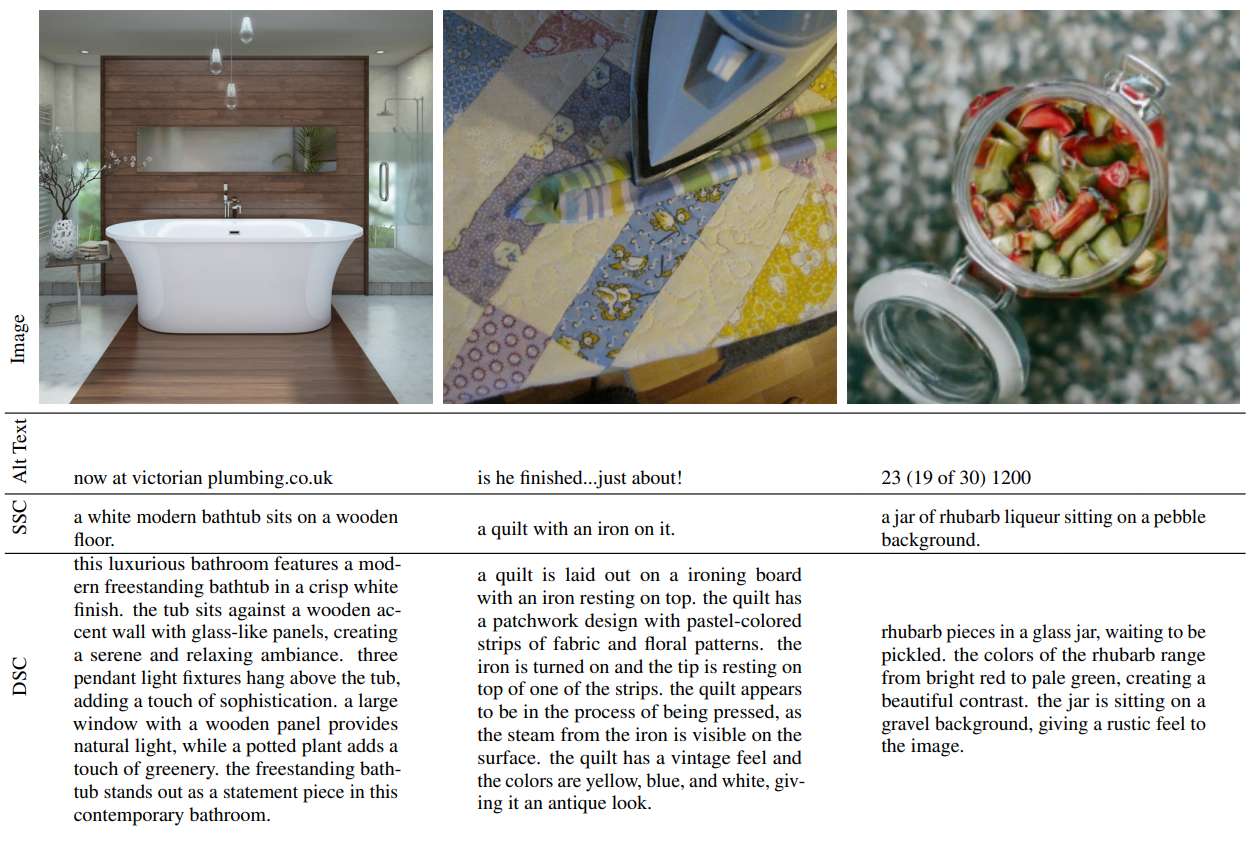

Vor dem eigentlichen Training von DALL-E 3 hat OpenAI einen eigenen KI-Bildbeschrifter trainiert, mit dem dann der Bilddatensatz für das Training des eigentlichen Bildsystems DALL-E 3 neu beschriftet wurde. Bei der Neubeschriftung legte OpenAI Wert auf besonders detaillierte Beschreibungen.

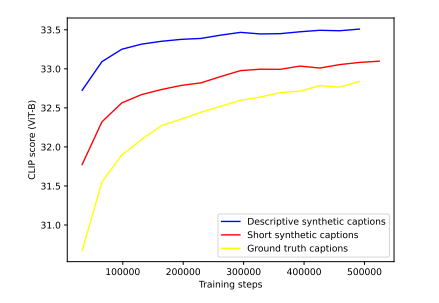

Vor dem Training von DALL-E 3 trainierte OpenAI probeweise drei Bildmodelle mit drei Annotationstypen: menschlich, kurz synthetisch und detailliert synthetisch.

Bereits die kurzen synthetischen Annotationen übertrafen in Benchmarks die menschlichen Annotationen deutlich. Die langen deskriptiven Annotationen erreichten noch höhere Werte.

OpenAI experimentierte auch mit einer Mischung aus verschiedenen synthetischen und menschlichen Annotationsstilen. Je höher jedoch der Anteil der maschinellen Annotation war, desto besser war auch die Bildgenerierung. So enthält DALL-E 3 95 Prozent maschinelle Annotationen und 5 Prozent menschliche Annotationen.

Prompt-Genauigkeit: DALL-E 3 im Vergleich mit Midjourney 5.2 und Stable Diffusion XL

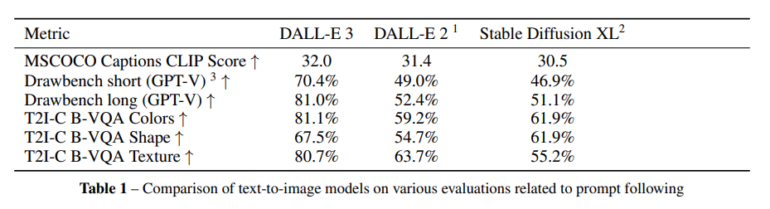

OpenAI testete die Prompt-Genauigkeit von DALL-E 3 in synthetischen Benchmarks und in Tests mit Menschen. In allen synthetischen Benchmarks liegt DALL-E 3 vor seinem Vorgänger DALL-E 2 und Stable Diffusion XL, meist mit deutlichem Abstand.

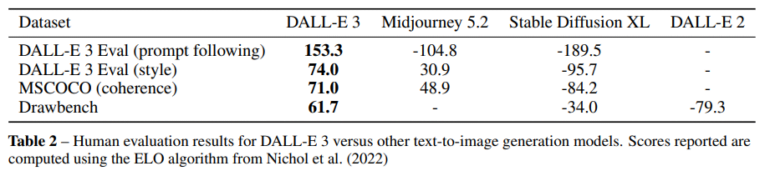

Relevanter ist die menschliche Einschätzung in den Dimensionen Promptgenauigkeit, Stil und Glaubwürdigkeit. Insbesondere beim Prompt-Following fällt das Ergebnis deutlich zugunsten von DALL-E 3 im Vergleich zu Midjourney aus.

Aber auch bei Stil und Kohärenz schneidet die neue Bild-KI von OpenAI signifikant besser ab als Midjourney 5.2. Noch deutlicher fällt die Open-Source-KI Stable Diffusion XL ab. DALL-E 3 hat laut OpenAI noch Probleme bei der Lokalisierung von Objekten im Raum (links neben, rechts neben, hinter etc.).

In einer Fußnote weist OpenAI darauf hin, dass die Neuerung bei der Bildbeschriftung nur ein Teil der Neuerungen von DALL-E 3 sei, das "viele Verbesserungen" gegenüber DALL-E 2 aufweise. Der deutliche Vorsprung von DALL-E 3 gegenüber konkurrierenden Systemen sei daher nicht allein auf die synthetische Bildbeschriftung zurückzuführen. Auf weitere Verbesserungen von DALL-E 3 geht OpenAI in dem Papier nicht ein.

Midjourney und Co. sollte man noch nicht abschreiben

Als intensiver Nutzer von Midjourney bin ich begeistert von der Fähigkeit von DALL-E 3, meine Bildbefehle relativ genau zu befolgen. Für THE DECODER verwenden wir viele KI-generierte Illustrationen. Je genauer sie den Inhalt des Artikels wiedergeben, desto besser. Deshalb bin ich derzeit weitgehend auf DALL-E 3 umgestiegen.

Hinsichtlich der Bildqualität sehe ich jedoch Midjourney immer noch vorne. DALL-E 3 neigt gelegentlich zu einem generischen Stockfoto-Look. Vor allem bei fotorealistischen Szenen hat DALL-E 3 das Nachsehen, so sehen zum Beispiel Menschen künstlich aus. Außerdem bietet mir Midjourney inhaltlich und technisch viel mehr kreativen Spielraum beim Prompting.

Midjourney will mit v6 auch die Promptgenauigkeit verbessern und könnte damit wieder Boden auf DALL-E 3 gut machen. Auch DALL-E 2 von OpenAI setzte zunächst neue Maßstäbe, wurde dann aber schnell vom Markt überholt.

![Black Forest Labs bringt KI-Bildmodell FLUX.1 Kontext [dev] für private Nutzung heraus](https://the-decoder.de/wp-content/uploads/2025/07/blackforestlabs_examples-375x207.png)