OpenAI: KI-Mikroskop blickt ins neuronale Netz

OpenAIs KI-Mikroskop "Microscope" soll die Analyse neuronaler Netze erleichtern und somit für transparentere Künstliche Intelligenz sorgen.

Ein echtes Mikroskop, so richtig mit Stativ, Revolverkopf, Objektträger und Lichtquelle, hat OpenAI natürlich nicht gebaut. Das Innenleben Künstlicher Intelligenz wird per Software erforscht.

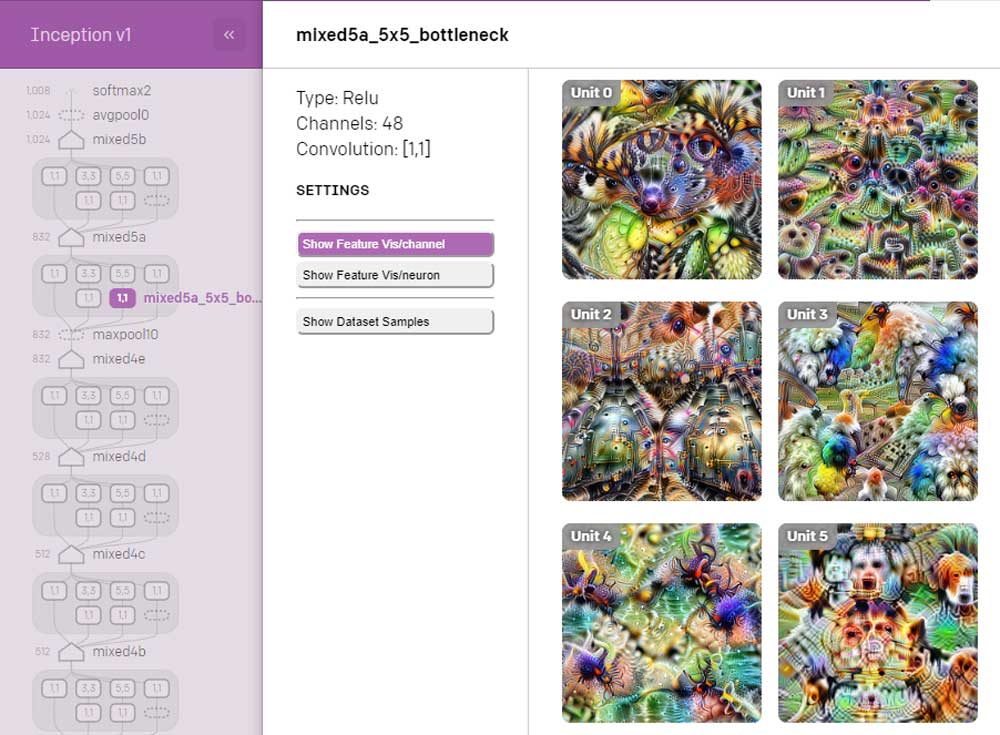

Diese Software folgt zumindest dem Gedanken eines echten Mikroskops: Sie zoomt auf die Inhalte und Entscheidungen einzelner Neuronen in künstlichen neuronalen Netzen für Bildverarbeitung ein. Derzeit werden neun gängige Modelle unterstützt.

Microscope soll so die komplexen Interaktionen Tausender oder Zehntausender Neuronen nachvollziehbar und insbesondere wissenschaftlich besser diskutierbar machen.

Ein Wissenschaftler könnte laut OpenAI beispielsweise die Behauptung aufstellen, dass Googles KI-Modell InceptionV1 für die Auto-Erkennung auf Reifen- und Fenster-Detektoren basiert. Mit direkten Links auf die Neuronen, die ihn zu seiner These motivierten, soll dann die Argumentation einfacher und schneller von der Hand gehen.

Effzientere Neuronenanalyse für KI-Forscher

Neu ist die Visualisierungstechnik für Neuronen nicht, sie ist bereits als Open Source verfügbar. Allerdings soll die Analyse nun in Sekunden möglich sein statt in Minuten. Die Möglichkeit zur Verlinkung einzelner Neuronen soll die Kollaboration zwischen Forschern erleichtern.

"Microscope erleichtert die Feature-Analyse im Inneren der neuronalen Netze und wir hoffen, dass das der Wissenschaft dabei hilft, diese komplizierten Systeme zu verstehen", schreibt OpenAI zur Veröffentlichung. In Zukunft soll Microscope mehr Modelle und neue Visualisierungstechniken unterstützen.

Dämmerlicht in der Blackbox-KI

Die Nachvollziehbarkeit von KI-Entscheidungen könnte für die Zukunft der Technologie grundlegend relevant sein, einerseits für die Fehleranalyse, andererseits, um für mehr Technik-Akzeptanz bei Menschen zu sorgen, beispielsweise im Kontext medizinischer Diagnosen durch Künstliche Intelligenz.

Entsprechend viele Projekte laufen schon für mehr KI-Transparenz: Im letzten November stellte Facebook "Captum" vor, eine Software, die zeigt, welche Signale in einem neuronalen Netz welchen Einfluss auf dessen Entscheidungsfindung hatten. Auch Google, IBM und Microsoft bieten Werkzeuge an, die einen Blick in die "Blackbox KI" ermöglichen sollen.

Der KI-Investor, Biomediziner und Computerwissenschaftler Vijay Pande hat eine andere Perspektive auf das Blackbox-Risiko: Der undurchsichtige Denkprozess einer Maschine sei letztlich ebenso wenig exakt nachvollziehbar wie der eines Menschen.

Quelle: OpenAI

Weiterlesen über KI verstehen:

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.