Künstliche Intelligenz spielt komplexe Strategiespiele wie Dota 2 und Starcraft 2 auf Weltklasse-Niveau. Aber flexibel zwischen Spielen wechseln, das kann eine KI noch immer nicht. OpenAI will das mit einer neuen Spielesammlung fürs KI-Training ändern.

Bestärkendes Lernen (Erklärung) gilt als eine vielversprechende Methode auf dem Weg zur Super-KI. Dank der Lernmethode spielt KI Atari-Klassiker, moderne Videospiele wie Starcraft 2, Brettspiele wie Go oder Poker-Varianten meist

Der KI-Agent lernt mit der Versuch-und-Irrtum-Methode, das Spiel zu gewinnen: Verhält er sich so, dass er seinem Ziel näherkommt, wird er belohnt – führt in sein Verhalten ab vom Weg, wird er bestraft. So findet er Stück für Stück den Weg zum Ziel und wird dabei immer effizienter.

KI ist ein Gaming-Nerd spezialisiert auf ausgewählte Level

Nach dieser Methode trainierte Künstliche Intelligenz kann selbst anspruchsvolle Spiele auf übermenschlichem Niveau beherrschen. Doch da sie immer nur ein Spiel mit immer den gleichen Spielabschnitten lernt, kommt sie mit Veränderungen nicht klar.

Schon eine andere Reihenfolge der Spielabschnitte kann zu einer deutlich schlechteren Leistung der KI führen. Für neue Spielabschnitte muss die KI wieder neu trainiert werden.

Dieses Überanpassung genannte Phänomen gibt es auch in anderen KI-Bereichen, etwa bei Bildanalyse-KIs. Schon leichte Modifikationen der Umgebungsbedingungen führen zu einem massiven Leistungsabfall: Diagnose-KIs erkennen nur noch MRT-Bilder eines bestimmten Anbieters, autonome Autos verwechseln LKWs mit Wolken. Das ist gefährlich.

Spielerisch zum KI-Fortschritt

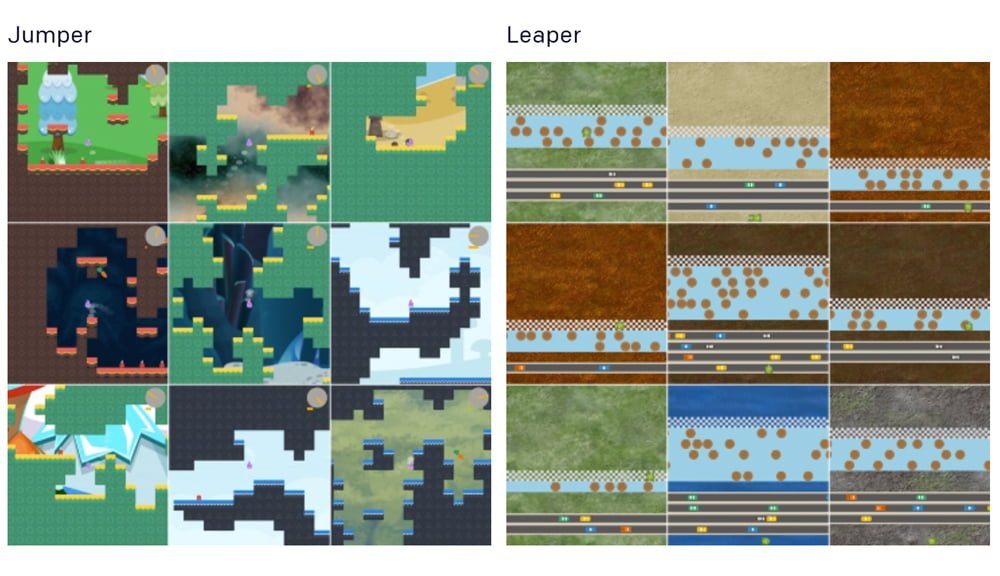

Das KI-Unternehmen OpenAI veröffentlicht jetzt eine Videospiel-Testumgebung für bestärkendes Lernen, in der in 16 Minispielen fortlaufend prozedural neue Spielabschnitte für das KI-Training generiert werden.

Die Idee dahinter: Durch die vielen unterschiedlichen Spiele und die permanente Veränderung soll sich die KI unterschiedliche Fähigkeiten aneignen und laufend nach neuen Lösungswegen suchen.

So wird die KI gezwungen, generalisierte Strategien zu entwickeln - und scheitert in der Folge nicht mehr so schnell an neuen Umgebungen. Das jedenfalls ist die Theorie.

Die 16 Spiele sind exemplarisch für einfache Videospielinteraktionen: Die KI hüpft, navigiert durch Labyrinthe, weicht Gegnern aus oder schießt Raumschiffe ab.

Damit ist OpenAIs Procgen Benchmark etwas vielfältiger als Unitys Trainingsumgebung Obstacle Tower, die ebenfalls auf prozedural generierte Umgebungen setzt. Der einfach gehaltene Aufbau der Spiele soll zudem schnelle Iterationen in der Entwicklung ermöglichen.

[one_third]

[/one_third][one_third]

[/one_third][one_third_last]

[/one_third_last]

Trügerische Erfolge und echte Ergebnisse

In ersten Tests benötigte eine KI im Schnitt 500 bis 1.000 Trainingsdurchläufe, bevor sie sich in neuen Leveln ohne vorheriges Training zurechtfand. In einigen Fällen waren bis zu 10.000 Trainingslevel notwendig, bis die KI so generalisierte, dass sie einen neuen Abschnitt beherrschte, schreibt OpenAI.

Dieses notwendigerweise intensive Training zeige, dass Benchmarks für bestärkendes Lernen Abwechslung prüfen müssten – andernfalls würde eine Überanpassung nicht entdeckt. Eine KI, die in Space Invaders 50 Level nacheinander meistert, könnte in einem unbekannten Level 51 scheitern.

Dieser Überanpassung sei nicht sofort offensichtlich: Schon nach einigen Trainingsleveln zeige sich häufig eine Verbesserung des KI-Agenten. Dies führe dann zum Trugschluss, dass die KI das Spiel tatsächlich beherrscht. Dabei beherrscht sie eigentlich nur die trainierten Level.

Dennoch lohnt sich intensives und umfangreiches Training: Anders als beim überwachten Lernen (Erklärung), bei dem die KI-Leistung bei zu großen Datensätzen oder zu langem Training abnimmt, wird die KI beim bestärkenden Lernen stetig besser. Weshalb dieses Phänomen bei der einen Lernmethode auftritt, bei der anderen jedoch nicht, und ob sich daraus eine Regel ableiten lässt, ist noch nicht geklärt.

OpenAI nutzt Procgen bereits als Benchmark für die eigenen KI-Tests. Die gewonnenen Erkenntnisse wolle man in komplexeren KI-Experimenten einsetzen, so die Forscher. Procgen gibt’s kostenlos bei Github.

Quelle: OpenAI