Mensch macht's möglich: OpenAIs Text-KI GPT-2 wird besser

Menschen bringen OpenAIs Text-KI GPT-2 bei, bessere Texte zu erstellen.

Der KI-Forscher Yann LeCun hat einmal gesagt: "Wenn Intelligenz ein Kuchen ist, ist der Großteil des Kuchens unüberwachtes Lernen, das Sahnehäubchen ist überwachtes Lernen und die Kirsche ist bestärkendes Lernen."

OpenAIs Text-KI GPT-2 schickt sich an, das beste Beispiel für LeCuns Metapher zu werden. Ich erkläre euch, weshalb.

Das KI-Unternehmen stellte die Text-KI GPT-2 im Februar vor und veröffentlichte im August die bis dato größte und leistungsstärkste Version. GPT-2 wurde unüberwacht mit 40 Gigabyte Internet-Text der Online-Plattform Reddit trainiert. Unüberwacht bedeutet, dass die KI anhand der Textbasis eigenständig ein Sprachmodell - Rechtschreibung, Satzbau etc. - entwickelte. Auf Basis dieses Modells kann die KI dann neue Texte generieren.

Nach dem Training gelang GPT-2 die Textgenerierung so gut, dass OpenAI sich entschloss, die leistungsstärkste Version der KI bis heute zurückzuhalten. Das Unternehmen befürchtet eine Überflutung des Internets mit Fake-News und anderen KI-generierten Texten.

Mit menschlichem Feedback zu besserer Performance

Doch GPT-2 und vergleichbare Text- und Sprach-KIs sollen keine Fake-News-Produzenten werden - sie sollen etwa intelligente Sprachassistenten antreiben und sinnvolle, faktenbasierte Artikel schreiben oder umfassende Studienarbeiten schnell und kompakt zusammenfassen.

Nun hat OpenAI eine Spezialform des bestärkenden Lernens eingesetzt, um die Fähigkeiten von GPT-2 weiter zu verbessern. Beim bestärkenden Lernen wird eine KI für jeden Schritt belohnt, der näher an das von Menschen gesetzte Ziel führt. So soll sie einen effektiven Lösungsweg finden.

Doch wie soll so ein Belohnungssystem bei einer Künstlichen Intelligenz für Sprache funktionieren? OpenAI hat eine mögliche Antwort gefunden: Der Mensch belohnt die Maschine durch sein Feedback.

Menschliches Urteil als Qualitätssignal

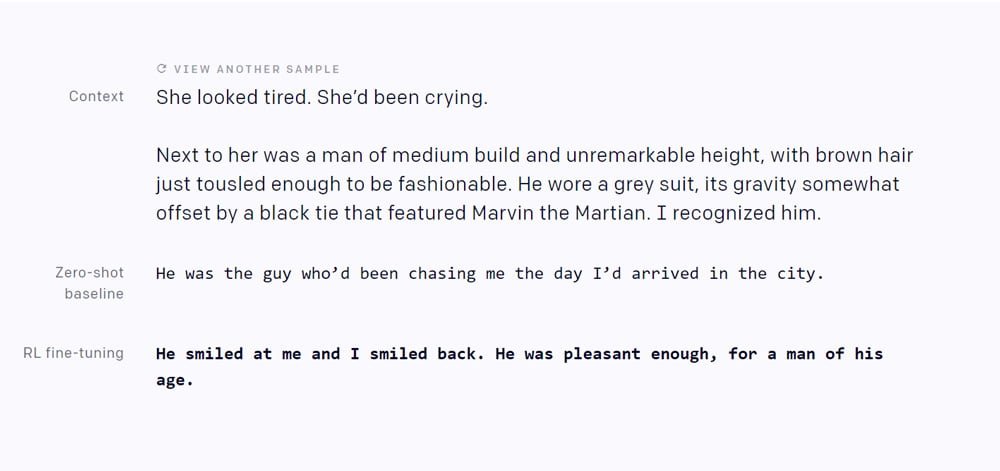

Konkret musste GPT-2 zwei Aufgaben erledigen: Bei der ersten Aufgabe musste die KI Texte nach einem vorgegebenen Stil vervollständigen – entweder mit einer Geschichte voller positiver Emotionen oder durch Beschreibungen physikalischer Eigenschaften. Bei der zweiten Aufgabe musste die KI Zusammenfassungen von Texten schreiben.

In beiden Fällen bekamen Menschen die generierten Texte zu sehen und wählten die ihrer Ansicht nach besten aus. Die menschliche Auswahl wiederum diente der KI als Signal, zukünftige Texte ähnlich aufzuschreiben. Nach 5.000 menschlichen Bewertungen fiel die Leistung der KI bei eigenen Geschichten - emotional und sachlich - deutlich besser aus, schreibt OpenAI.

Als komplexer stellte sich die Aufgabe heraus, Zusammenfassungen zu schreiben: Dort trainierte die KI mit insgesamt 60.000 menschlichen Rückmeldungen. So lernte sie, ganze Sätze aus dem Ursprungstext zu kopieren und dabei irrelevante Vorbemerkungen zu überspringen.

Die Leistung der Maschine richtet sich nach dem Anspruch des Menschen

OpenAI ist mit den Ergebnissen des Mensch-Trainings noch nicht zufrieden. Die maschinellen Zusammenfassungen seien weit unter dem Niveau von menschlichen. Das läge womöglich an den niedrigen Ansprüchen, die die gemieteten Klickarbeiter an die KI stellten: Nach kopierten Sätzen zu suchen, ist für einen Arbeiter schneller erledigt, als einen neu strukturierten Text vollständig zu lesen.

Durch das Training sei eine KI entstanden, die hauptsächlich kopiere, statt zusammenzufassen, die aber immerhin keine Inhalte erfinde. Für OpenAI ist genau das ein Vorteil des bestärkenden Lernens für Sprach-KIs: Die Methode erlaube, nach wichtigen Kriterien wie "Lüge nicht" zu trainieren und sei daher ein Schritt hin zu sicheren KIs.

Die Ergebnisse zeigten auch, dass die nachträgliche Feinjustierung einer unüberwacht trainierten KI durch bestärkendes Lernen sinnvoll sein kann - und LeCun mit seiner Kirsche-auf-dem-Kuchen-Metapher wohl auf der richtigen Spur ist.

Quelle: OpenAI

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.