OpenAI kündigt GPT-4 Turbo, Assistants und neue API-Funktionen an

Auf der eigenen Entwicklerkonferenz kündigt OpenAI ein günstigeres, schnelleres und smarteres GPT-4-Modell an.

Das neue GPT-4 Turbo Modell ist ab sofort als Vorschau über die OpenAI API und direkt in ChatGPT verfügbar. Laut OpenAI CEO Sam Altman ist GPT-4 Turbo "viel schneller" und "smarter".

Mit der Veröffentlichung von Turbo erklären sich auch die Gerüchte um ein aktualisiertes ChatGPT-Trainingsdatum, denn GPT-4 Turbo ist bis April 2023 aktuell. Das ursprüngliche ChatGPT hatte nur Wissen bis September 2021.

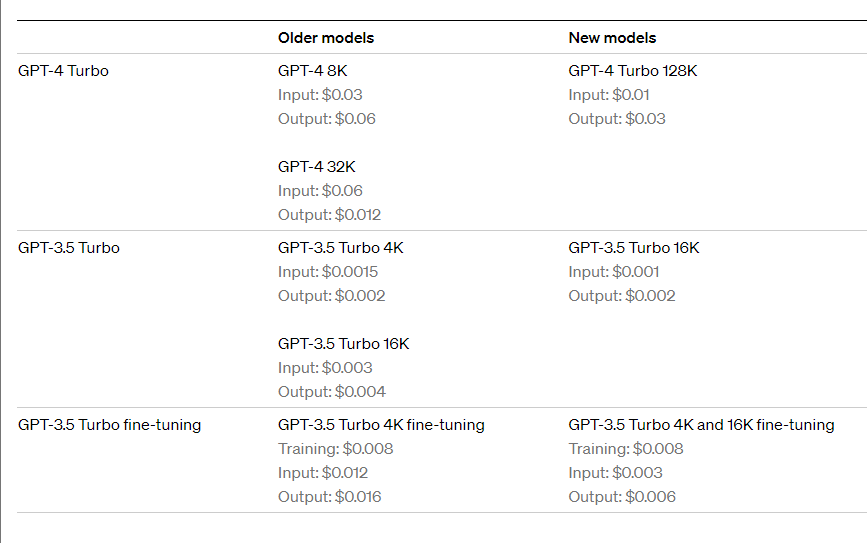

Das wohl größte Highlight für Entwickler ist eine kräftige Preissenkung: Input-Tokens für Turbo sind um den Faktor drei günstiger, Output-Tokens um den Faktor zwei. Das neue Turbo-Modell kostet 0,01 US-Dollar pro 1.000 Token gegenüber 0,03 US-Dollar bei GPT-4. Es ist auch viel günstiger als GPT-4 32K, obwohl es ein viermal so großes Kontextfenster hat (siehe unten).

Zweites Highlight für Entwickler: OpenAI erweitert die GPT-4 Turbo API um Bildanalyse, DALL-E 3 Integration und Text-to-Speech. Das Modell "gpt-4-vision-preview" kann Bilder analysieren, generieren und aus Texten menschenähnliche Sprache erzeugen.

OpenAI arbeitet auch an einem experimentellen GPT-4 Feintuning Programm und einem Custom Models Programm für Organisationen mit großen proprietären Datensätzen.

Viel größeres Aufmerksamkeitsfenster für GPT-4 Turbo

Die wohl wichtigste technische Neuerung ist die Vergrößerung des Aufmerksamkeitsfensters, also der Menge an Informationen, die GPT-4 auf einmal verarbeiten und bei der Generierung der Ausgabe berücksichtigen kann. Bisher lag dieses Aufmerksamkeitsfenster bei maximal 32.000 Token. GPT-4 Turbo hat 128.000 Token.

Das entspricht bis zu 100.000 Wörtern oder 300 Seiten in einem Standardbuch, wie Altman beschreibt. Laut Altman ist das 128K-GPT-4 Turbo-Modell zudem "viel genauer" in Bezug auf den Gesamtzusammenhang.

OpenAI bestätigt auch das GPT-4 All-Modell, das ebenfalls ab sofort ausgerollt wird und bereits zuvor gesichtet wurde. Das All-Modell wechselt automatisch zwischen den verschiedenen GPT-Modellen für Programmcode (Advanced Data Analysis) oder Bildgenerierung (DALL-E 3), je nach Anforderung des Benutzers. Bisher musste das richtige Modell vor der Eingabe manuell ausgewählt werden.

Die Tatsache, dass GPT-4 Turbo nun offiziell ist, ist auch deshalb interessant, weil es zuvor ein Gerücht gab, dass OpenAI ein GPT-4-Modell namens "Arrakis", das effizienter sein sollte, aber nicht funktionierte, zugunsten von Turbo aufgegeben hat.

Assistants API und ein Copyright-Schutz

OpenAI hat auch die Assistants API vorgestellt, die Entwicklern helfen soll, KI-basierte Funktionen in ihre Anwendungen zu integrieren. Die API ermöglicht persistente und endlose Threads, wodurch Entwickler die Einschränkungen des Kontextfensters umgehen können.

Assistenten haben Zugang zu neuen Werkzeugen wie dem Code Interpreter, der Python-Code in einer abgeschotteten Umgebung schreibt und ausführt, Retrieval, das den Assistenten mit externem Wissen anreichert, und Function Call, das es Assistenten ermöglicht, benutzerdefinierte Funktionen aufzurufen.

Video: OpenAI

Die Assistants API basiert auf denselben Funktionen wie die GPT-Produkte von OpenAI. Entwickler können die Assistants API Beta im Assistants Playground ausprobieren, ohne Code schreiben zu müssen. Die Betaversion ist ab sofort verfügbar.

Der Funktionsumfang der Assistants API soll kontinuierlich erweitert werden. Laut Altman sind die Assistants ein erster Schritt in Richtung vollwertiger KI-Agenten.

Neu ist auch das "Copyright Shield", das Kunden bei rechtlichen Ansprüchen im Zusammenhang mit Urheberrechtsverletzungen von Inhalten, die mit OpenAI-Modellen generiert wurden, verteidigt und die Kosten übernimmt. Dieser Schutz gilt für allgemein verfügbare Funktionen von ChatGPT Enterprise und der Entwicklerplattform.

Microsoft und Google haben ebenfalls solche Schutzmodelle angekündigt. Sie sind ein Zeichen dafür, dass Big AI zuversichtlich ist, die bevorstehenden Rechtsstreitigkeiten zu gewinnen.

Die gesamte Entwicklerkonferenz kann man im folgenden Video ansehen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.