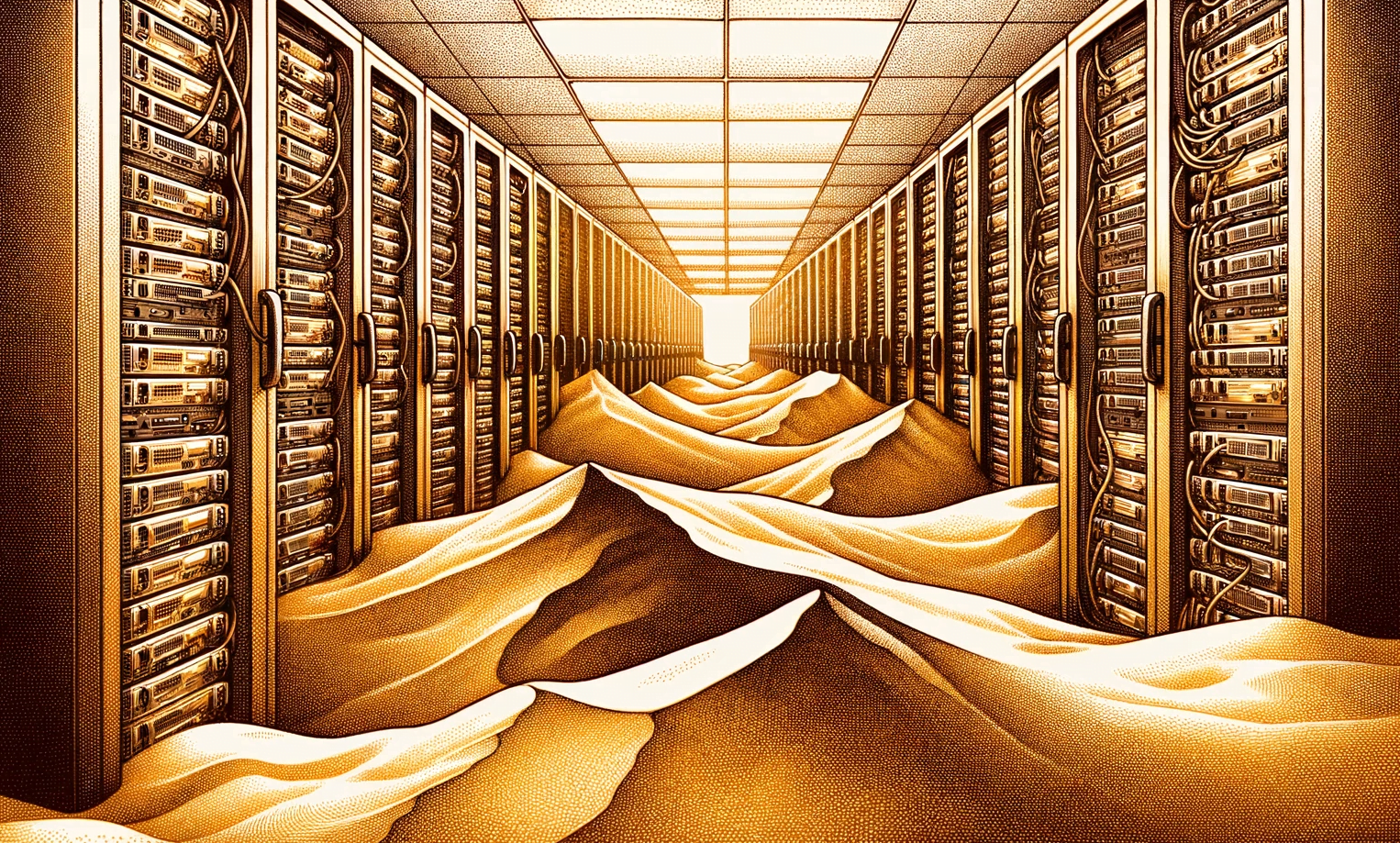

OpenAIs KI-Modell mit dem Codenamen Arrakis sollte KI-Anwendungen effizienter machen. Das Unternehmen stellte die Entwicklung jedoch ein, weil die Qualität nicht stimmte.

Arrakis sollte die Leistung von GPT-4 erreichen, aber billiger laufen, weil das Modell teilweise nach dem sogenannten Sparse-Prinzip aufgebaut war. Dabei werden nur Teile des neuronalen Netzes für die Verarbeitung einer Eingabe genutzt, während bei klassischen "Dense-Modellen" immer das gesamte neuronale Netz aktiviert wird. Auf das Sparse-Prinzip setzt beispielsweise auch Google im Projekt Pathways.

Die Entwicklung von Arrakis begann im vergangenen Herbst, das Training im Frühjahr. Doch das OpenAI-Entwicklungsteam habe schnell festgestellt, dass die Leistung nicht ausreiche, berichtet The Information unter Berufung auf zwei mit dem Projekt vertraute Personen.

Umschwenken auf "GPT-4-Turbo"

Einen Monat lang habe das Team an der Optimierung gearbeitet, dann habe das Führungsteam das Projekt beendet. Warum das Sparse-Prinzip bei den ersten Tests gut funktionierte, aber beim großen Modell versagte, ist unklar.

Trotz dieses Rückschlags könnte OpenAI seine Arbeit an Arrakis in andere Modelle einfließen lassen, beispielsweise in das geplante multimodale Modell Gobi, das in der Lage sein wird, Texte und Bilder zu generieren oder zu analysieren.

Nach dem Scheitern von Arrakis haben sich die OpenAI-Forscher auf die Entwicklung einer GPT-4-Version konzentriert, die schnellere Antworten generiert. Dies könnte die im Sommer eingeführte GPT-4 Version "0613" sein, die deutlich schneller schreibt als die Version "0314", mit der OpenAI im März gestartet ist. Einige Nutzerinnen und Nutzer haben sich jedoch über Qualitätseinbußen in bestimmten Bereichen beschwert.

OpenAI schickt KI in die Wüste

Gobi, Sahara und Arrakis: Die neuen KI-Modell-Prototypen sind nach Wüsten benannt, in Anlehnung an das Sparse-Prinzip und in der Hoffnung, dass die Modelle effizienter arbeiten und Kosten sparen.

Insbesondere OpenAI-Partner Microsoft soll auf Arrakis gehofft haben, um den Einsatz der KI-Modelle in eigenen Produkten kostengünstiger skalieren zu können.

Einem Bericht des Wall Street Journals zufolge hat Microsoft inzwischen selbst Ressourcen in die Entwicklung kostengünstigerer Sprachmodelle verlagert, da die hohen Kosten der generativen KI aufkommende Geschäftsmodelle gefährden.

Frühere Leaks über Arrakis

Der OpenAI-Leaker FeltSteam hatte bereits früher über Arrakis berichtet. Das Modell soll neben Text auch Bilder und Videos generieren, weniger Halluzinationen als GPT-4 haben und als autonomer Agent geeignet sein. Außerdem sollte Arrakis teilweise mit synthetischen Daten trainiert werden. Die Veröffentlichung war für das kommende Jahr geplant.

Laut FeltSteam handelt es sich bei Arrakis möglicherweise weniger um ein einzelnes Modell als vielmehr um ein System zur Generierung effizienterer Modelle. So könnte Arrakis bei der Entwicklung von GPT-3.5 Turbo geholfen haben.

Womöglich erklärt die Existenz des multimodalen Arrakis rückblickend eine Aussage des CTO von Microsoft Deutschland, Andreas Braun. Er sprach Anfang März 2023, eine Woche vor der offiziellen Enthüllung von GPT-4, von "multimodalen Modellen", die auch Videos generieren könnten. Zu diesem Zeitpunkt dürfte OpenAI noch an Arrakis gearbeitet haben.