Kann OpenAIs GPT-4 helfen, KI sicherer zu machen? Das Unternehmen lässt das große Sprachmodell GPT-2-Neuronen erklären.

In einer kürzlich veröffentlichten Arbeit zeigt OpenAI, wie KI helfen kann, die interne Funktionsweise großer Sprachmodelle zu interpretieren. Das Team verwendete GPT-4, um Erklärungen für Neuronen des älteren Vorgängers GPT-2 zu generieren und zu bewerten. Die Arbeit ist Teil der Alignment-Forschung von OpenAI, die dazu beitragen soll, das Verhalten von KI-Systemen besser zu verstehen und zu steuern.

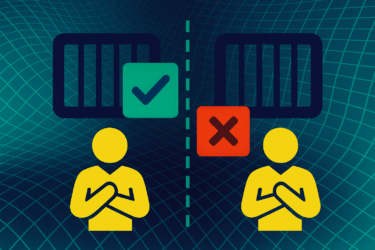

OpenAIs Methodik umfasst drei Schritte:

- Generierung einer Erklärung mit GPT-4: Ausgehend von einem GPT-2 Neuron generiert GPT-4 eine Erklärung für dessen Verhalten, indem es relevante Textsequenzen und Aktivierungen anzeigt.

- Simulieren mit GPT-4: GPT-4 simuliert, was ein Neuron, das für die generierte Erklärung feuert, tun würde.

- Vergleichen: Die generierte Erklärung wird danach bewertet, wie gut die simulierten Aktivierungen mit den tatsächlichen Aktivierungen des GPT-2 Neurons übereinstimmen.

Am Ende des Prozesses steht eine Erklärung der Funktion eines GPT-2-Neurons in natürlicher Sprache, z.B. "Feuert bei Bezug auf Filme, Charaktere und Unterhaltungsmedien".

OpenAIs GPT-4 erklärt GPT-2 schlechter als Menschen

Das Team stellte fest, dass diese Methode umso schlechter funktioniert, je größer das zu erklärende Sprachmodell ist. Ein Grund dafür könnte sein, dass Neuronen in späteren Schichten schwieriger zu erklären sind. Das Team konnte die generierten Erklärungen jedoch durch einige Ansätze, wie beispielsweise iterative Erklärungen, etwas verbessern. Außerdem liefert GPT-4 bessere Erklärungen als kleinere Modelle - aber immer noch schlechter als Menschen.

Das Team generierte mit GPT-4 Erklärungen für alle 307.200 Neuronen von GPT-2. Darunter fanden sie 1.000 Neuronenerklärungen mit einer Erklärungsrate von mindestens 0,8, was bedeutet, dass sie den größten Teil des Aktivierungsverhaltens des Neurons nach GPT-4 erklären, so OpenAI.

Laut OpenAI hat die Methodik viele Probleme, so kann sie z.B. komplexes Verhalten von Neuronen oder nachgeschaltete Effekte von Aktivierungen nicht erklären. Zudem sei fraglich, ob eine natürlichsprachliche Erklärung für alle Neuronen möglich sei, und der Ansatz liefere keine mechanistische Erklärung für das Verhalten von GPT-2-Neuronen, "was dazu führen könnte, dass wir unser Verständnis in falscher Weise verallgemeinern".

OpenAIs Alignment-Forschung setzt auf KI-Assistenten

Das Ziel der Forschung sind Methoden der automatischen Interpretierbarkeit, die das Unternehmen einsetzen will, um zu prüfen, ob Sprachmodelle falsch ausgerichtet sind. Besonders wichtig ist die Erkennung von falscher Zielgeneralisierung oder irreführender Ausrichtung, bei der das Modell bei der Evaluierung ausgerichtet erscheint, während der Verwendung aber andere Ziele verfolgt. Dies aufzudecken erfordere ein tiefes Verständnis der internen Verhaltensweisen.

In ihrer Arbeit verwendete OpenAI ein leistungsfähigeres Modell, um ein schwächeres zu erklären - was zu Problemen führen könne, wenn nicht klar ist, ob der Assistent selbst vertrauenswürdig ist. "Wir hoffen, dass die Verwendung kleinerer vertrauenswürdiger Modelle für die Unterstützung entweder zu einem vollständigen Test der Interpretierbarkeit führt oder dass wir durch die Anwendung auf die Interpretierbarkeit genug über die Funktionsweise der Modelle lernen, um robustere Testmethoden zu entwickeln.

OpenAI hat den Datensatz und Code sowie ein Visualisierungstool für alle GPT-2-Neuronen veröffentlicht. Das Unternehmen möchte so die Entwicklung besserer Methodiken in der Alignment-Forschung fördedrn.