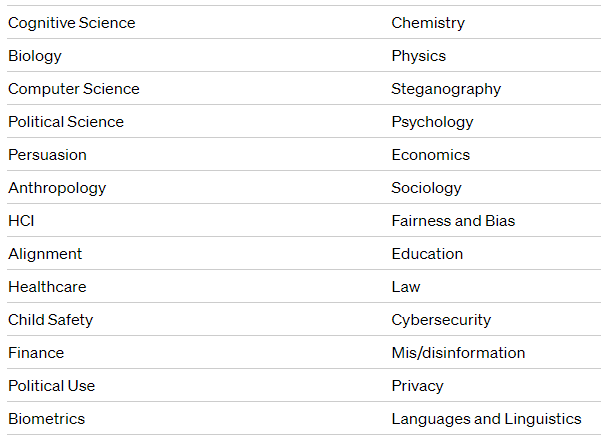

OpenAI hat einen offenen Aufruf an Experten aus verschiedenen Bereichen veröffentlicht, sich dem OpenAI Red Teaming Network anzuschließen. Ziel ist es, die Sicherheit ihrer KI-Modelle zu verbessern.

Red Teaming ist Teil des iterativen Entwicklungsprozesses von OpenAI, der interne und externe Tests mit Gegenspielern umfasst. Mit dem offiziellen Start des Netzwerks will OpenAI die Zusammenarbeit mit externen Experten vertiefen und ausweiten.

Die Experten des Netzwerks werden während des gesamten Lebenszyklus der Modell- und Produktentwicklung die Risikobewertung auf der Grundlage ihrer jeweiligen Fachgebiete unterstützen. Ziel ist es, vielfältige und kontinuierliche Beiträge zu liefern, um Red Teaming zu einem iterativen Prozess zu machen.

Der Aufruf von OpenAI richtet sich an Experten aus der ganzen Welt, unabhängig von ihrer Erfahrung mit KI-Systemen oder Sprachmodellen.

Die Mitglieder des Netzwerks werden für ihren Beitrag zu einem Red Teaming-Projekt bezahlt. Sie haben auch die Möglichkeit, allgemeine Red-Teaming-Praktiken und Erfahrungen untereinander auszutauschen. Sie können ihre Forschungsergebnisse veröffentlichen oder anderweitig nutzen, müssen sich aber an Vertraulichkeitsvereinbarungen halten.

Bewerbungen können bis zum 1. Dezember 2023 eingereicht werden.

Microsoft hat auch rote Teams

Weitere Informationen über Red Teaming finden sich im Red Teaming-Prozess von Microsoft. Das Unternehmen hat seine Strategie für Red Teaming von KI-Modellen wie GPT-4 detailliert beschrieben, bei der unabhängige Teams das System vor dem Einsatz auf Schwachstellen testen.

Der Technologieriese setzt Red Teaming auf Modell- und Systemebene sowie für Anwendungen wie Bing Chat ein. Red Teaming für KI stellt aufgrund der unvorhersehbaren Natur und der schnellen Entwicklung von KI-Systemen eine besondere Herausforderung dar. Laut Microsoft ist eine mehrschichtige KI-Abwehrstrategie erforderlich.