OpenAI stellt o3 und o4-mini vor: KI-Modelle sollen mit Werkzeugen und Bildern denken

OpenAI erweitert seine o-Serie um zwei neue Sprachmodelle mit verbesserter Tool-Nutzung und starker Leistung bei komplexen Aufgaben. Die Modelle zielen auf eine agentenartige Problemlösungsfähigkeit.

OpenAI hat mit o3 und o4-mini neue Modelle seiner o-Serie vorgestellt, die laut Unternehmensangaben die bisher intelligentesten Modelle des Unternehmens darstellen sollen.

Eine Kernneuerung sei die Fähigkeit, agentisch alle in ChatGPT verfügbaren Werkzeuge wie Websuche, Datenanalyse mit Python, Bildanalyse und Bildgenerierung zu nutzen und zu kombinieren, so OpenAI.

Die Modelle sollen gelernt haben, selbstständig zu entscheiden, wann und wie Werkzeuge eingesetzt werden müssen, um komplexe Probleme typischerweise unter einer Minute zu lösen.

Als Beispiel nennt OpenAI einen Prompt zum Thema Energieverbrauch, bei der das Modell Websuche, Python-Analyse, Diagrammerstellung und Erklärung kombiniert und das Endergebnis als Lösung präsentiert.

Video: OpenAI

Denken mit Bildern

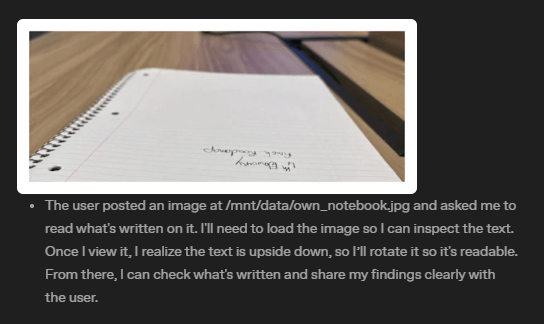

Ein weiterer zentraler Fortschritt sei die Fähigkeit der Modelle, Bilder direkt in ihre interne Gedankenkette zu integrieren und mit ihnen zu "denken", anstatt sie nur zu "sehen".

Dabei helfen soll die native Nutzung von Werkzeugen zur Bildmanipulation wie Zoomen, Zuschneiden oder Drehen direkt im Reasoning-Prozess, wie OpenAI in einem Blogbeitrag zur visuellen Denkfähigkeit erläutert.

In einem Beispiel zeigt OpenAI, wie das KI-Modell eine auf der Kopf stehende unleserliche Handschrift einzoomt, das Bild umdreht und dann korrekt transkribiert.

Laut OpenAI führt die Kombination aus verbessertem Reasoning und vollem Werkzeugzugriff zu signifikant stärkerer Leistung bei akademischen Benchmarks und realen Aufgaben. Ziel sei ein agentischeres ChatGPT, das Aufgaben unabhängiger ausführen könne.

Video: OpenAI

Neue Bestwerte in Benchmarks

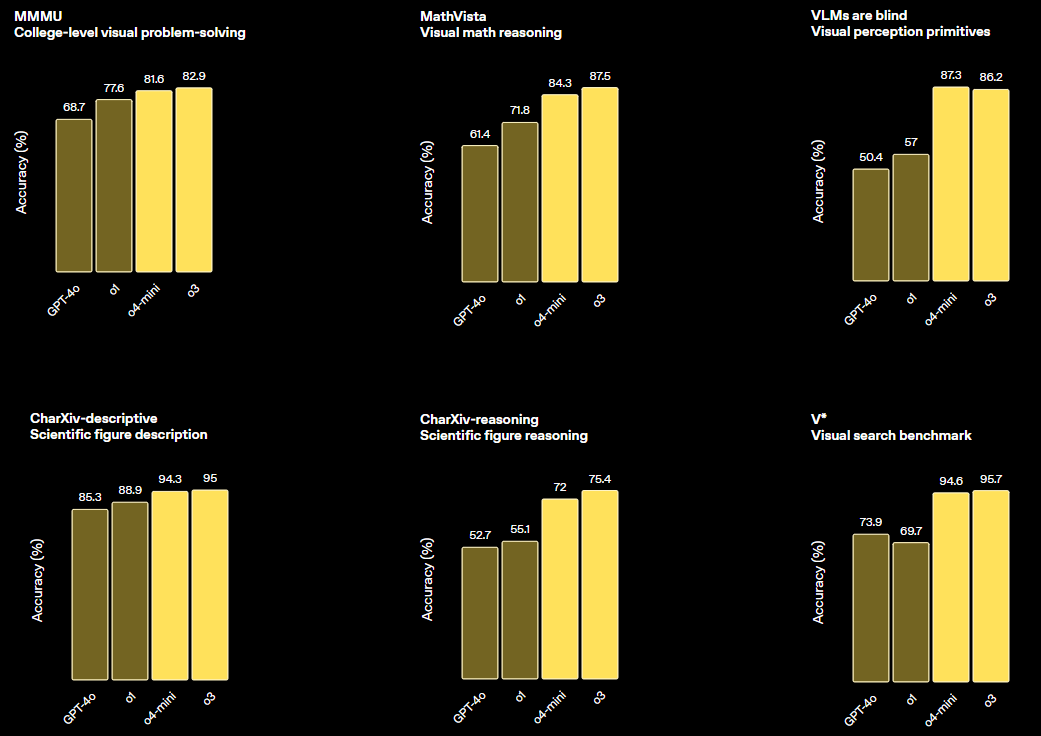

OpenAI o3, das erstmals im Dezember 2024 vorgestellt und seitdem weiter optimiert wurde, ist laut OpenAI das leistungsstärkste Reasoning-Modell des Unternehmens.

Es soll in Bereichen wie Coding, Mathematik, Wissenschaft und visueller Wahrnehmung Fortschritte und neue Spitzenwerte (State-of-the-Art, SOTA) in Benchmarks wie Codeforces, SWE-bench und MMMU erreichen.

Zudem soll es dabei 20 Prozent weniger schwerwiegende Fehler als das Vorgängermodell o1 bei schwierigen realen Aufgaben machen, insbesondere in Programmierung, Business/Consulting und kreativer Ideenfindung. Frühe Tester hätten die analytische Strenge und die Fähigkeit zur Hypothesengenerierung hervorgehoben, so OpenAI.

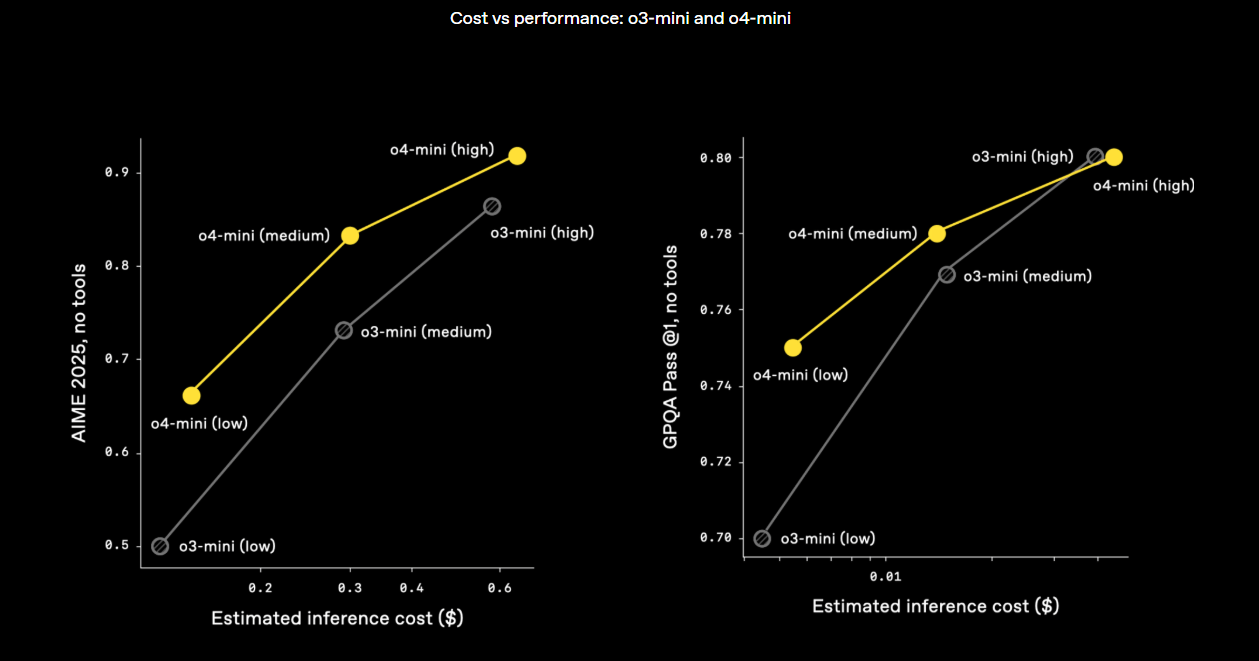

o4-mini ist eine kleinere, auf Geschwindigkeit und Kosteneffizienz optimierte Variante, die laut OpenAI für ihre Größe und ihren Preis bemerkenswerte Leistungen insbesondere bei Mathematik-, Coding- und visuellen Aufgaben erzielt.

Bei der AIME 2025 erreicht o4-mini mit Python-Zugang 99,5 Prozent, was laut OpenAI einer Sättigung dieses Benchmarks entspricht. Im Vergleich zu o3-mini verbessert sich o4-mini auch bei nicht-technischen Aufgaben und im Bereich Data Science deutlich.

Beide Modelle sollen laut OpenAI Prompts besser folgen und nützlichere, und dank Web-Quellen verifizierbarere Antworten liefern. Sie sollen sich zudem natürlicher in der Konversation verhalten, indem sie auf frühere Interaktionen zurückgreifen.

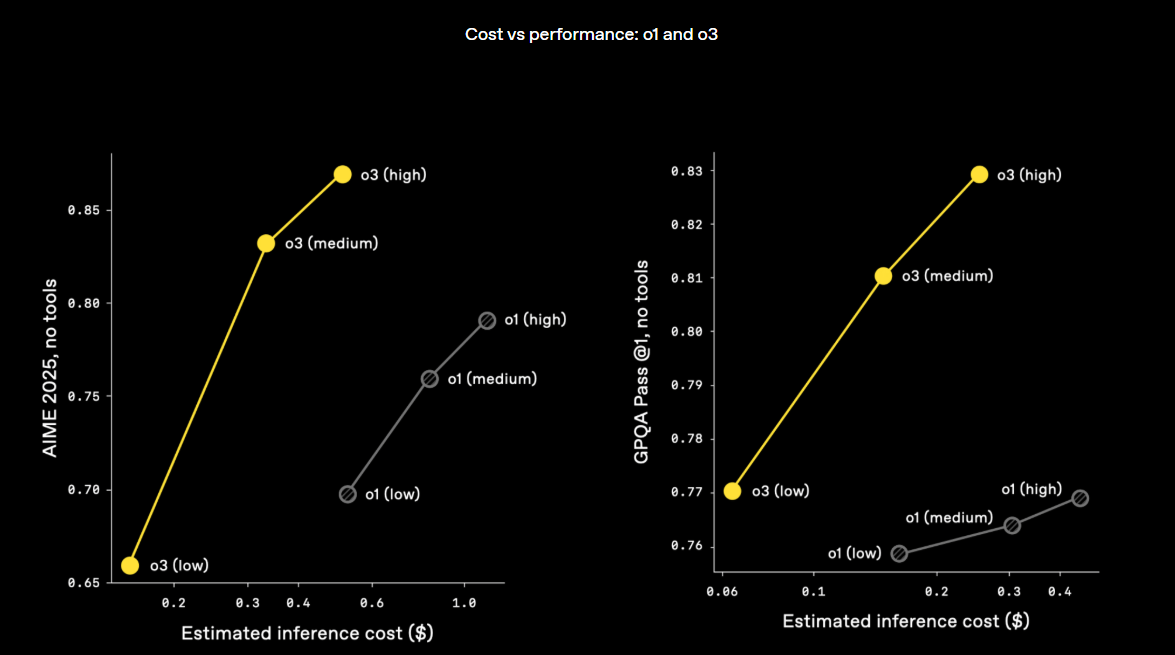

Mehr Rechenleistung = bessere Leistung

Für das Reinforcement Learning und Schlussfolgerungen während des "Denkvorgangs" hat OpenAI laut eigenen Angaben die Rechenleistung um eine Größenordnung gesteigert und sehe weiterhin Leistungssteigerungen. Dennoch sollen o3 und o4-mini oft nicht nur intelligenter, sondern auch kosteneffizienter als ihre Vorgänger o1 und o3-mini sein.

OpenAI sieht sich in der Annahme bestätigt, dass die Kombination aus Reinforcement Learning und dem längeren "Nachdenken" die Leistung der KI-Modelle verbessere.

Mittels RL sei den Modellen auch beigebracht worden, wann und wie sie Werkzeuge zielgerichtet einsetzen sollen, was ihre Fähigkeiten in offenen Situationen, besonders bei visuellem Reasoning und mehrstufigen Abläufen, verbessere.

Codex CLI und Verfügbarkeit

Ab sofort können zahlende ChatGPT-Nutzer (Plus, Pro, Team) o3, o4-mini und o4-mini-high nutzen; in Kürze folgt der Zugang für Enterprise- und Edu-Konten. Frei-Nutzer können o4-mini in der Auswahl „Think“ ausprobieren. Entwickler erhalten Zugriff via Chat Completions API und die neue Responses API. Sie müssen möglicherweise ihre Organisationen verifizieren, um Zugriff zu erhalten.

Ein Modell namens o3-pro mit vollem Tool-Support soll in einigen Wochen erscheinen. Zukünftige Modelle sollen Reasoning-Fähigkeiten der o-Serie mit Konversations- und Werkzeugfähigkeiten der GPT-Serie vereinen. Gemeint sein dürfte GPT-5, das im Sommer starten soll.

Als Experiment stellt OpenAI zudem Codex CLI vor, einen leichtgewichtigen Coding-Agenten für das Terminal, der lokal läuft und das Reasoning von o3/o4-mini nutzen soll. Er ermögliche multimodales Arbeiten über die Kommandozeile (Screenshots, Skizzen) mit Zugriff auf lokalen Code und ist Open Source auf GitHub verfügbar. Eine Förderinitiative von 1 Million US-Dollar in API-Credits soll Projekte unterstützen.

Grenzen bei Faktenwissen und Halluzinationen

Trotz der Fortschritte bei Tool-Nutzung und Reasoning zeigen die neuen Modelle auch Schwächen. In der PersonQA-Bewertung, bei der Modelle auf Fragen zu bekannten Persönlichkeiten getestet werden, schneidet o4-mini schlechter ab als o1 und o3. OpenAI führt das auf die geringere Modellgröße zurück: Kleinere Modelle verfügen über weniger Weltwissen und neigen stärker zur Halluzination.

Auffällig ist aber ein Unterschied zwischen o1 und o3: o3 macht insgesamt mehr Aussagen – was sowohl die Zahl korrekter als auch inkorrekter Behauptungen erhöht. OpenAI vermutet, dass o3 durch seine stärkeren Schlussfolgerungsfähigkeiten eher dazu neigt, auch bei unklarer Informationslage Aussagen zu generieren. Ob dies auf Trainingsdaten, Belohnungsfunktionen oder andere Faktoren zurückzuführen ist, soll in künftigen Studien geklärt werden.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.