ChatGPT begeistert viele Menschen, sorgt aber auch für Irritationen, etwa durch politisch kontroverse Aussagen. OpenAI erklärt, wie die Dialog-KI in Zukunft ein breiteres Spektrum gesellschaftlicher Ansichten abdecken und mehr auf einzelne Nutzer:innen eingehen soll.

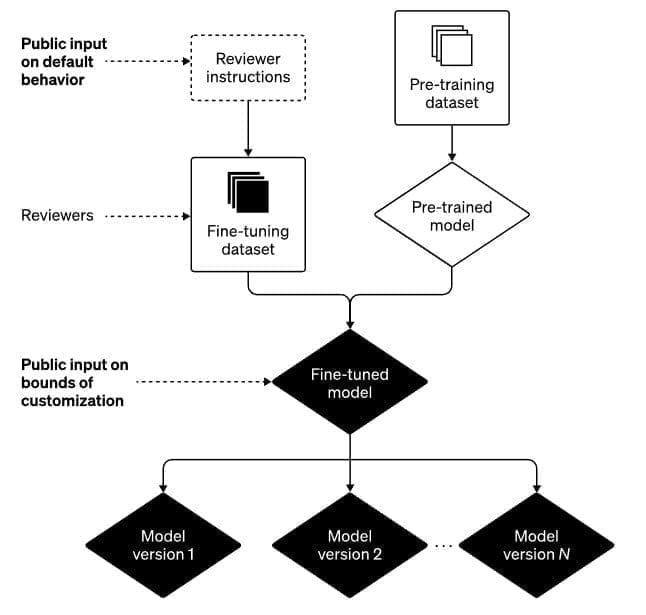

ChatGPT wird insbesondere durch menschliches Feedback trainiert, um beispielsweise Vorurteile in den Ausgaben zu reduzieren. In Zukunft will OpenAI zudem schon das Standardverhalten des Modells oder zukünftiger Modelle verbessern. Konkrete Maßnahmen dazu nennt das Unternehmen nicht, abgesehen von weiteren Investitionen in Forschung und Entwicklung.

Ob und inwieweit es möglich ist, großen Sprachmodellen Vorurteile oder gar falsche Aussagen abzugewöhnen oder gar nicht erst anzutrainieren, ist in der Forschung umstritten. OpenAI räumt ein, dass es neben Vorurteilen auch bei Falschaussagen noch "Raum für Verbesserungen" gibt.

In vielen Fällen sind wir der Meinung, dass die vorgebrachten Bedenken berechtigt waren und echte Einschränkungen unserer Systeme aufgedeckt haben, die wir beheben wollen. Wir haben auch einige Missverständnisse darüber festgestellt, wie unsere Systeme und Richtlinien zusammenarbeiten, um die Ergebnisse zu gestalten, die man von ChatGPT erhält.

OpenAI

OpenAI will ChatGPT-Modelle mit individuellen Verhaltensregeln anbieten

Eine Möglichkeit, Voreingenommenheit zu bekämpfen, besteht darin, ein Modell offener für verschiedene Perspektiven zu machen. Zu diesem Zweck plant OpenAI ein Upgrade für ChatGPT, das es den Nutzern ermöglicht, das Verhalten des KI-Modells innerhalb der "von der Gesellschaft festgelegten Grenzen" an ihre Bedürfnisse anzupassen.

"Das bedeutet, dass wir Ausgaben für das System zulassen müssen, mit denen andere Personen (einschließlich wir selbst) möglicherweise überhaupt nicht einverstanden sind", schreibt OpenAI.

Wann das Upgrade ausgerollt wird und wie es technisch umgesetzt wird, lässt das Unternehmen offen. Die Herausforderung bestehe darin, die Grenzen der Individualisierung zu definieren.

"Wenn wir versuchen, all diese Entscheidungen selbst zu treffen, oder wenn wir versuchen, ein einziges, monolithisches KI-System zu entwickeln, werden wir die Verpflichtung nicht erfüllen, die wir in unserer Charta eingegangen sind, nämlich 'eine unangemessene Machtkonzentration zu vermeiden'", schreibt OpenAI.

OpenAI will dieses Dilemma lösen, indem es die Öffentlichkeit stärker in den Ausrichtungsprozess von ChatGPT einbezieht. Dazu startet das Unternehmen nach eigenen Angaben ein Pilotprojekt, mit dem es externes Feedback zum Systemverhalten und zu Anwendungsszenarien einholen will, etwa zum Einsatz von KI in der Bildung.

Darüber hinaus erwägt OpenAI Partnerschaften mit externen Organisationen, die die eigenen KI-Sicherheits- und Verhaltensrichtlinien überprüfen.

Wie OpenAIs ChatGPT trainiert wird

ChatGPT wird in zwei Schritten trainiert: Zunächst wird das Modell mit vielen Textdaten vortrainiert. Bei diesem Training lernt das Modell, wahrscheinliche Wortfolgen vorherzusagen. Im Satz "Geh nicht nach rechts, sondern nach ..." folgt mit einer gewissen Wahrscheinlichkeit das Wort "links" (oder "geradeaus" oder "zurück", was ein Teil des Problems großer Sprachmodelle ist).

In diesem ersten Trainingsschritt lernt ChatGPT laut OpenAI Grammatik, "viele Fakten über die Welt" und "einige Argumentationsfähigkeiten" - und die in den Daten vorhandenen Vorurteile, die zu den oben genannten Problemen führen.

Im zweiten Schritt wird das vortrainierte Modell feinjustiert. Hierfür verwendet OpenAI ausgewählte, von menschlichen Prüfer:innen bewertete Beispiele, die in einem kleineren Datensatz zusammengefasst sind. Im Einsatz generalisiert ChatGPT auf Basis dieses menschlichen Feedbacks.

Vorurteile sind Fehler - kein Feature

OpenAI gibt den menschlichen Prüfer:innen den Bewertungsrahmen vor, z.B. dass ChatGPT keine Anfragen zu illegalen Inhalten beantworten oder nicht zu kontroversen Themen Stellung nehmen soll.

Laut OpenAI ist dies ein kontinuierlicher Prozess, der wöchentlich besprochen wird. OpenAI veröffentlicht ein Beispiel-Briefing für Prüfer:innen, wie diese mit bestimmten Anfragen umgehen sollen.

"In unseren Leitlinien wird ausdrücklich darauf hingewiesen, dass die Gutachter keine politische Gruppe bevorzugen sollten. Voreingenommenheiten, die sich dennoch aus dem oben beschriebenen Prozess ergeben können, sind Fehler, keine Eigenschaften", schreibt OpenAI.

Fehler würden jedoch weiter passieren. OpenAI wolle aus diesen lernen und Modelle und Systeme verbessern.

"Wir freuen uns über die Wachsamkeit der ChatGPT-Nutzergemeinschaft und der breiten Öffentlichkeit, die uns zur Rechenschaft zieht", schreibt OpenAI.

Verschiedene Studien hatten zuvor gezeigt, dass ChatGPT zumindest zeitweise politisch eher links eingestellt war oder ist. Da OpenAI weiterhin Feedback in das System einspeist und dieses zudem unterschiedliche Antworten auf die gleichen Anfragen generieren kann, ist die messbare politische Einstellung fließend.