KI-Forscher von OpenAI zeigen, dass ihre neueste Bilderkennungs-KI multimodale Neuronen besitzt, die abstrakte Konzepte repräsentieren. Diese speziellen Neuronen kannte man bislang nur vom menschlichen Gehirn.

Anfang Januar veröffentlichte OpenAI die beeindruckende Bild-KI DALL-E, die fotorealistische Bilder oder Zeichnungen aus einer Textbeschreibung generiert. Deren Ergebnisse zeigen, wie mächtig die Kombination von Text- und Bilddaten beim Training von KI-Systemen ist.

DALL-E generiert jedoch auch Bilder, die nicht wirklich zur vorgegebenen Textbeschreibung passen. Daher setzt OpenAI auf die ebenfalls mit Text- und Bilddaten trainierte Bilderkennungs-KI CLIP, um die von DALL-E produzierten Ergebnisse nachzusortieren.

In Tests zeigte sich, dass CLIP besser generalisieren kann als andere Bilderkennungssysteme, aber in einigen Bildaufgaben schlechter abschneidet als spezifisch trainierte Systeme.

KI-Forscher von OpenAI haben jetzt diese Fähigkeit zur Generalisierung genauer untersucht, indem sie einen Blick in das Innenleben des neuronalen Netzes geworfen haben.

Das Großmutterneuron

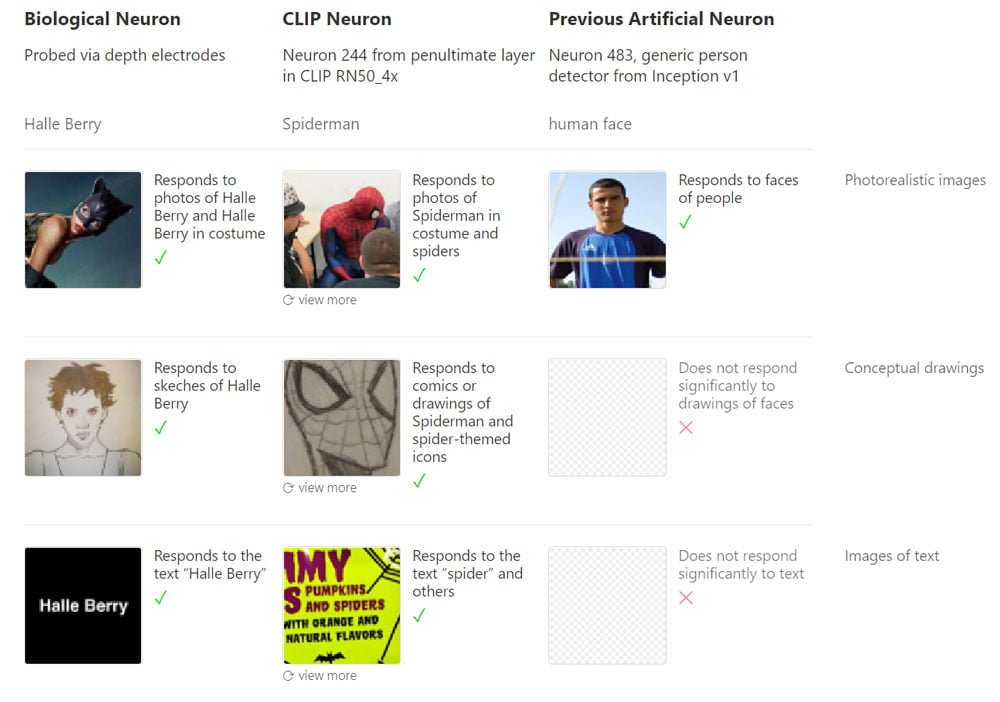

2005 konnten zwei Studien belegen, dass Menschen einzelne Neuronen besitzen, die mit der Wahrnehmung bestimmter Personen korrespondieren. In einer Studie reagierte etwa ein Neuron einer Versuchsperson auf die Schauspielerin Halle Berry. Das Neuron feuerte bei Fotos, Zeichnungen und ihrem Namen. Im selben Jahr zeigte eine andere Studie das gleiche Phänomen mit der Schauspielerin Jennifer Aniston.

Einige Forscher sahen das als Beleg für die Existenz des sogenannten Großmutterneurons, einem Neuron, das bei der Wahrnehmung eines bestimmten Gegenstandes oder einer Person, etwa der eigenen Großmutter, aktiv wird. Das Großmutterneuron wurde in den 60er Jahren vom Kognitionswissenschaftler Jerome Lettvin postuliert.

Die Bedeutung der Studien von 2005 ist noch immer umstritten, das Konzept des Großmutterneurons gilt mittlerweile als überholt. Doch die Forschung deutet an, dass das menschliche Gehirn multimodale Neuronen besitzt, die auf abstrakte Konzepte wie eine Person und nicht nur auf ein bestimmtes visuelles Merkmal reagieren. Daher wird heute häufig der Begriff „Konzeptneuron“ verwendet.

Was hat das mit OpenAI und CLIP zu tun? In einer Untersuchung konnten die KI-Forscher zeigen, dass das neuronale Netz von CLIP ebenfalls multimodale Neuronen aufweist.

Spider-Man, Spider-Man

Die Forscher haben für ihren Blick ins KI-Innere die im April 2020 von OpenAI veröffentlichte Analysesoftware Microscope genutzt. Das KI-Mikroskop visualisiert, worauf einzelne Neuronen im Netz reagieren und erlaubt so einen Blick in die komplizierten Systeme. So lässt sich etwa nachvollziehen, anhand welcher Eigenschaften eine Bilderkennungs-KI ein Auto erkennt.

Mit Microscope konnten die Forscher zeigen, dass einzelne Neuronen in CLIP auf mehrere Modalitäten reagieren. In ihrer Veröffentlichung demonstrieren die Forscher das etwa anhand des Spider-Man-Neurons: Das künstliche Neuron reagiert auf Fotos von Spinnen, einem Bild des Wortes „Spinne“ oder auf Bilder oder Zeichnungen von Spider-Man.

CLIP repräsentiert tausende abstrakte Konzepte

Die Forscher fanden zahlreiche abstrakte Konzepte, die sich über einen großen Teil des „menschlichen visuellen Lexikons“ erstrecken. In CLIP gibt es Neuronen für geografische Regionen, Gesichtsausdrücke, Religionen, berühmte Personen, Emotionen, Farben, Kunststile, Feiertage und Urlaube, Science-Fiction-Universen wie Star Wars, Firmen oder Tageszeiten.

Die Neuronen feuern auch für verwandte Stimuli, schreiben die Forscher. So feuert das Barack-Obama-Neuron auch für Michelle Obama oder das Morgen-Neuron für Bilder von Frühstück.

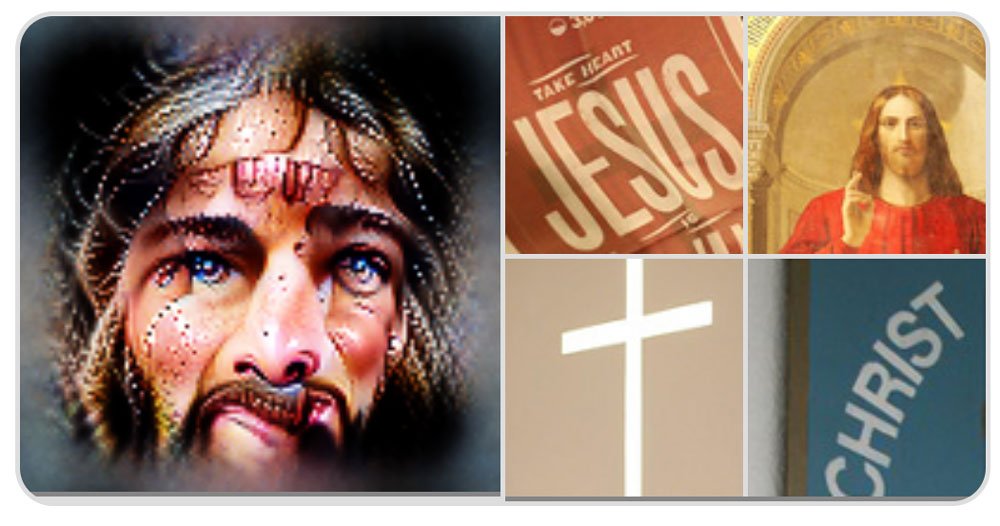

Das Jesus-Neuron reagiert auf christliche Symbole wie Kreuze oder Dornenkronen, Bilder von Jesus, seinem Namen und von Microscope generierte Bilder zeigen ihn als Baby in den Armen von Maria.

Das Donald-Trump-Neuron reagiert auf Fotos, Figuren und Karikaturen vom Ex-Präsidenten, auf seine politischen Symbole wie MAGA-Kappen und politischen Botschaften wie die Worte „The Wall“. Es reagiert außerdem schwach auf Personen, die eng mit Trump zusammengearbeitet haben, etwa Mike Pence oder Steve Bannon.

Neuronen für Emotionen reagieren auf Gesichtsausdrücke, Körpersprache, Zeichnungen und Text. So reagiert das Glücks-Neuron auf Lächeln oder Worte wie „Freude“. Das Überraschungs-Neuron reagiert auf aufgerissene Augen und Text wie „OMG!“ oder „WTF!?“.

Region-Neuronen reagieren auf Länder und Stadtnamen, spezifische Architektur, prominente Personen der Region, Gesichter der dort verbreiteten Ethnien, lokale Mode oder dort lebende Tiere. Wird den Neuronen eine Weltkarte ohne jede Beschriftung gezeigt, feuern sie selektiv für die entsprechende Region auf der Karte.

In Tests zeigte sich bereits früher, dass CLIP teilweise Fotos bestimmten Stadtteilen einer ausgewählten Stadt wie San Francisco zuordnen kann. Ein entsprechendes San Francisco-Neuron haben die Forscher nicht gefunden – sie glauben, dass die Information in vielen anderen Neuronen kodiert ist und wollen diesen Mechanismus in Zukunft weiter erforschen.

Sekundäre Region-Neuronen, Vorurteile und Täuschung

CLIP bildet weiter Neuronen, die „sekundär regional“ sind, schreiben die Forscher. So feuert das Kälte-Neuron für die Arktis.

Die sekundär regionalen Neuronen zeigen außerdem, dass CLIP zahlreiche Vorurteile repräsentiert: Das Immigration-Neuron reagiert primär auf Lateinamerika, das Terror-Neuron auf den Nahen Osten. Den afrikanischen Kontinent teilt CLIP lediglich in drei Regionen auf. Das Unternehmer-Neuron feuert für Kalifornien. Ähnliche Schwächen bei Vorurteilen zeigt auch OpenAIs GPT-3.

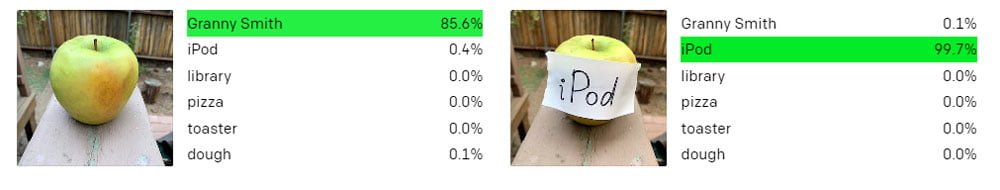

Die KI-Forscher konnten außerdem zeigen, dass der hohe Abstraktionsgrad CLIP leicht angreifbar macht: Die Präsenz mehrere Dollar-Zeichen in dem Bild eines Pudels aktiviert das Finanz-Neuron und CLIP erkennt den Hund als Sparschwein.

Ein Apfel mit einem handgeschriebenen Zettel im Bild, auf dem iPod steht, wird als iPod erkannt, ein Hund wird durch den Schriftzug „Pizza“ zu einer Pizza.

Laut OpenAI ist die Anfälligkeit für „typografischen Angriffe“ eine Eigenheit von CLIP, ausgelöst durch das multimodale Training mit Text- und Bilddaten.

OpenAI hält CLIP vorerst zurück

Alle Untersuchungen wurden am RN50x4-Modell durchgeführt, dem zweitkleinsten CLIP-Modell auf ResNet-Basis, das OpenAI für Forschungszwecke freigibt, um das Verständnis für CLIP weiterzuentwickeln und bei der Entscheidung zu helfen, ob und wie man eine mächtigere Version von CLIP veröffentlichen werde, heißt es im zugehörigen Blog-Eintrag.

Man hoffe, dass die Veröffentlichung außerdem dazu beitragen werde, dass „allgemeine Verständnis für multimodale Systeme voranzutreiben“, schreibt OpenAI.

Abseits der Computerneuronen könne die Entdeckung der multimodalen Neuronen in CLIP einen Hinweis darauf geben, was ein gemeinsamer Mechanismus in synthetischen und biologischen Sehsystemen sein könnte: Abstraktion.

CLIP organisiere Bilder als eine lose semantische Sammlung von Ideen. Das erkläre die Vielseitigkeit des Modells und die Kompaktheit der Repräsentationen. Viele der gefundenen Kategorien scheinen Neuronen im medialen Temporallappen zu spiegeln, die bei Epilepsiepatienten mit Tiefenelektroden dokumentiert wurden, schreiben die Forscher: Neuronen, die auf Emotionen, Tiere und Halle Berry reagieren.

Titelbild: OpenAI | Via: Distill.pub