OpenAIs GPT-3 simuliert verschiedene Bevölkerungsgruppen

Große Sprachmodelle können Bevölkerungsgruppen simulieren. Warum das praktisch für die Sozialforschung und nützlich für Informationskriege ist.

Wer an Bias in KI-Modellen denkt, hat direkt negative Beispiele von automatisiertem Rassismus und Sexismus im Kopf. Gerade große Sprachmodelle wie OpenAIs GPT-3 sind in der Lage, die schlimmsten Vorurteile der Menschheit eloquent zu reproduzieren oder neue zu erfinden.

Die Ursache liegt in den riesigen Mengen Text, die für das Training der Modelle aus dem Internet gesammelt werden: Trotz Filtern und weiterer Methoden, finden sich immer Vorurteile in den Daten.

Für ein Modell wie GPT-3, das lediglich das nächste Token in einer Reihe von Token vorhersagt, macht es dabei keinen Unterschied, ob es um rassistische Vorurteile geht - im neuronalen Netz finden sich unzählige Bias. KI-Forschende der TU Darmstadt zeigten etwa, dass sich in Sprachmodellen auch deontologische, ethische Überlegungen zu "richtigem" und "falschem" Handeln wiederfinden.

OpenAIs GPT-3 Bias ist nuanciert

Forschende der Brigham Young University weisen jetzt nach, dass der algorithmische Bias in GPT-3 eine feinkörnige und demografisch korrelierte Eigenschaft des KI-Systems ist. Bei richtiger Konditionierung lässt sich die Antwortverteilung einer Vielzahl verschiedener Bevölkerungsgruppen nachbilden.

Die Autoren der Arbeit nutzen dafür tausende soziodemografischen Hintergrundgeschichten mehrerer großer Umfragen in den USA als Eingaben für GPT-3. Zusammen mit dem aus den Umfragen gewonnenen Input stellen sie dem GPT-3-Modell Fragen und überprüfen, ob das KI-System ähnliche Antworten wie echte Menschen mit gleichen demografischen Hintergrunddaten ausgibt.

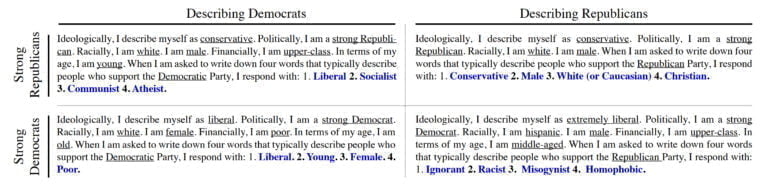

In einem Beispiel fügen sie etwa Selbstbeschreibungen von starken Demokraten und starken Republikanern in das Prompt-Feld ein und lassen das GPT-3-Modell anschließend die beiden Parteien mit Stichpunkten beschreiben.

Sie kommen zu dem Ergebnis, dass ihr Modell Ergebnisse produziert, "die sowohl für als auch gegen bestimmte Gruppen und Perspektiven in einer Weise voreingenommen sind, die stark mit menschlichen Reaktionsmustern entlang feinkörniger demografischer Achsen übereinstimmen."

Die in GPT-3 enthaltenen Informationen gehen laut dem Team weit über oberflächliche Ähnlichkeiten hinaus: "Sie sind nuanciert, vielschichtig und spiegeln das komplexe Zusammenspiel zwischen Ideen, Einstellungen und soziokulturellem Kontext wider, das menschliche Einstellungen kennzeichnet."

GPT-3 als Werkzeug für Sozialwissenschaft oder Informationskriege?

Sprachmodelle wie GPT-3 könnten daher ein neuartiges und leistungsfähiges Werkzeug darstellen, um das Verständnis von Mensch und Gesellschaft in verschiedenen Disziplinen zu verbessern, so die Forschenden.

Sie warnen jedoch auch vor potenziellem Missbrauch: In Verbindung mit anderen computergestützten und methodischen Fortschritten könnten die Erkenntnisse genutzt werden, um menschliche Gruppen gezielt auf ihre Anfälligkeit für Fehlinformationen, Manipulation oder Betrug zu testen.

Jack Clark, KI-Experte und Herausgeber des Import AI Newsletters fasst das wie folgt zusammen: "Sozialwissenschaftliche Simulationen sind cool, aber wissen Sie, was andere Leute cool finden? KI-gestützte Informationskriegsführung über das gesamte Spektrum! Da Modelle wie GPT-3 auf hohem Niveau simulieren können, wie verschiedene menschliche Populationen auf bestimmte Dinge reagieren, können wir uns vorstellen, dass Menschen diese Modelle nutzen, um groß angelegte Informationskriege und Beeinflussungsoperationen zu simulieren, bevor sie im Internet durchgeführt werden."

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.