OpenAIs GPT-4 ist ein sichereres und nützlicheres ChatGPT, das Bilder versteht

Update –

- OpenAI Entwicklerdemo hinzugefügt

- Nach der Enthüllung von OpenAIs GPT-4 verrät Microsoft auch, dass Bing Chat von Anfang an GPT-4 verwendet hat. Jeder, der in den letzten Wochen mit "Sydney" interagiert hat, hat also wahrscheinlich bereits ein gewisses Verständnis für die Fähigkeiten von GPT-4.

Update vom 15. März 2023:

OpenAIs CTO Greg Brockman präsentierte in einem Livestream für Entwickler und Entwicklerinnen die ersten Möglichkeiten von GPT-4. Die wohl beeindruckendste Demo im Stream war die Generierung von Webseitencode für eine funktionierende Webseite nur auf Basis einer handgeschriebenen Notiz. Diese Demo beginnt gegen 17:30 Uhr.

Ursprünglicher Artikel vom 14. März 2023:

Laut OpenAI ist GPT-4 "kreativer und kollaborativer" als alle bisherigen KI-Systeme, verfügt über eine breitere Wissensbasis und kann Probleme besser lösen. Als multimodales System akzeptiert es neben Text auch Bilder als Eingabe.

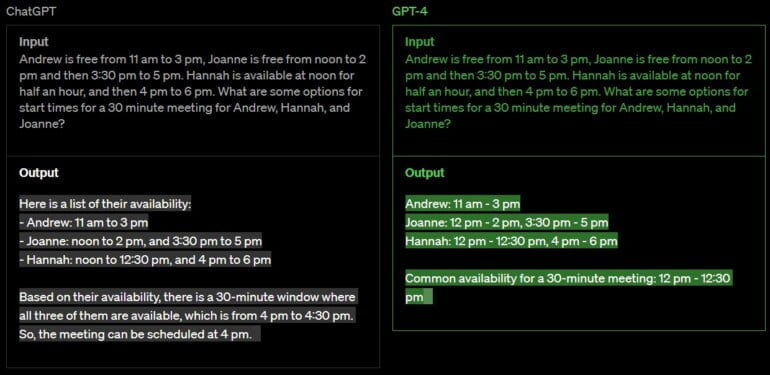

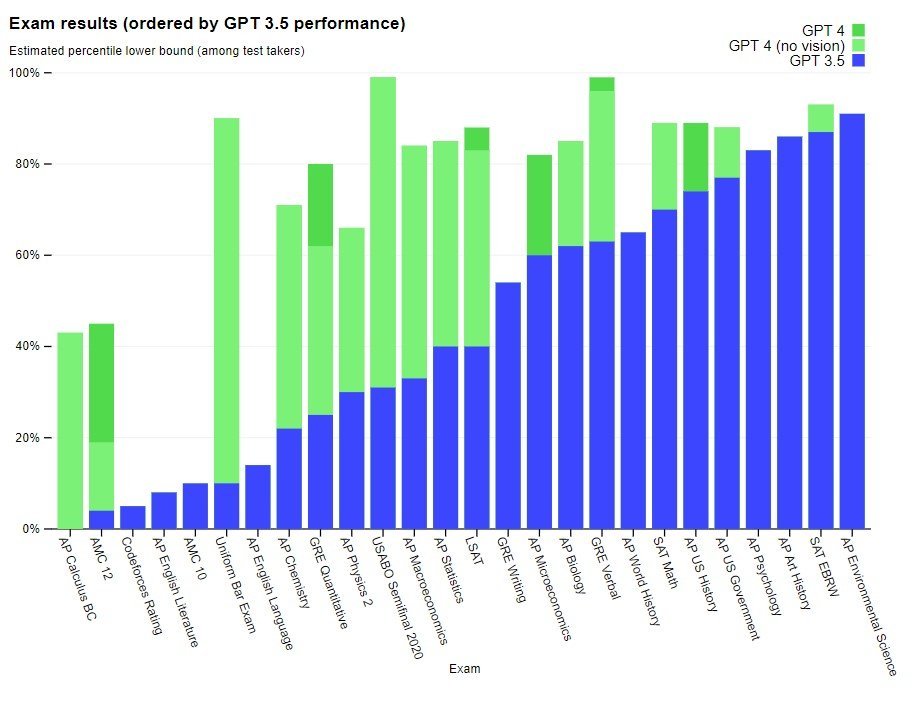

Laut OpenAI ist GPT-4 ein "Durchbruch" bei Aufgaben, die strukturiertes Problemlösen erfordern. Beispielsweise kann GPT-4 auf die Frage, wie ein Aquarium gereinigt wird, eine Schritt-für-Schritt-Anleitung ausgeben. In einer simulierten Anwaltsprüfung soll GPT-4 in den oberen zehn Prozent der Prüfungen abschließen, wo GPT-3.5 nur in den unteren zehn Prozent landete.

GPT-4 kann mehr als 25.000 Wörter verarbeiten und soll damit auch für die Generierung umfangreicherer Dokumente und Analysen geeignet sein. Die Datenbasis von GPT-4 endet im September 2021, das Modell lernt nicht aus eigenen Erfahrungen. GPT-3.5 sei ein erster Testlauf für das neue System gewesen.

Das neue KI-System basiert laut OpenAI direkt auf den Erkenntnissen aus den kontradiktorischen Testprogrammen und dem Feedback zu ChatGPT. Die neue Text-KI soll bestehende Systeme in Bezug auf Faktizität und Kontrollierbarkeit deutlich übertreffen, auch wenn sie "bei weitem nicht perfekt" sei.

Auch in gängigen Machine-Learning-Benchmarks übertrifft GPT-4 sein Vorgängermodell um bis zu 16 Prozent und schneidet bei mehrsprachigen Aufgaben um 15 Prozent besser ab als GPT-3.5.

OpenAI hat nach eigenen Angaben auch neue Methoden entwickelt, um die Leistung von GPT-4 in einigen Bereichen vorherzusagen, und zwar mit Modellen, die mit nur einem Tausendstel der Leistung von GPT-4 trainiert wurden.

Bei dieser Vorhersage von KI-Fähigkeiten vermutet OpenAI einen wichtigen Sicherheitsaspekt, der angesichts der möglichen Auswirkungen von KI nicht ausreichend berücksichtigt würde. "Wir verstärken unsere Bemühungen, Methoden zu entwickeln, die der Gesellschaft eine bessere Orientierung darüber geben, was von zukünftigen Systemen zu erwarten ist", schreibt OpenAI.

GPT-4 soll zudem Menschen bei der Evaluation von KI-Systemen unterstützten, um deren Fähigkeiten noch besser auf menschliche Bedürfnisse anzupassen. Dies sei Phase zwei der zuvor schon angekündigten Alignment-Strategie.

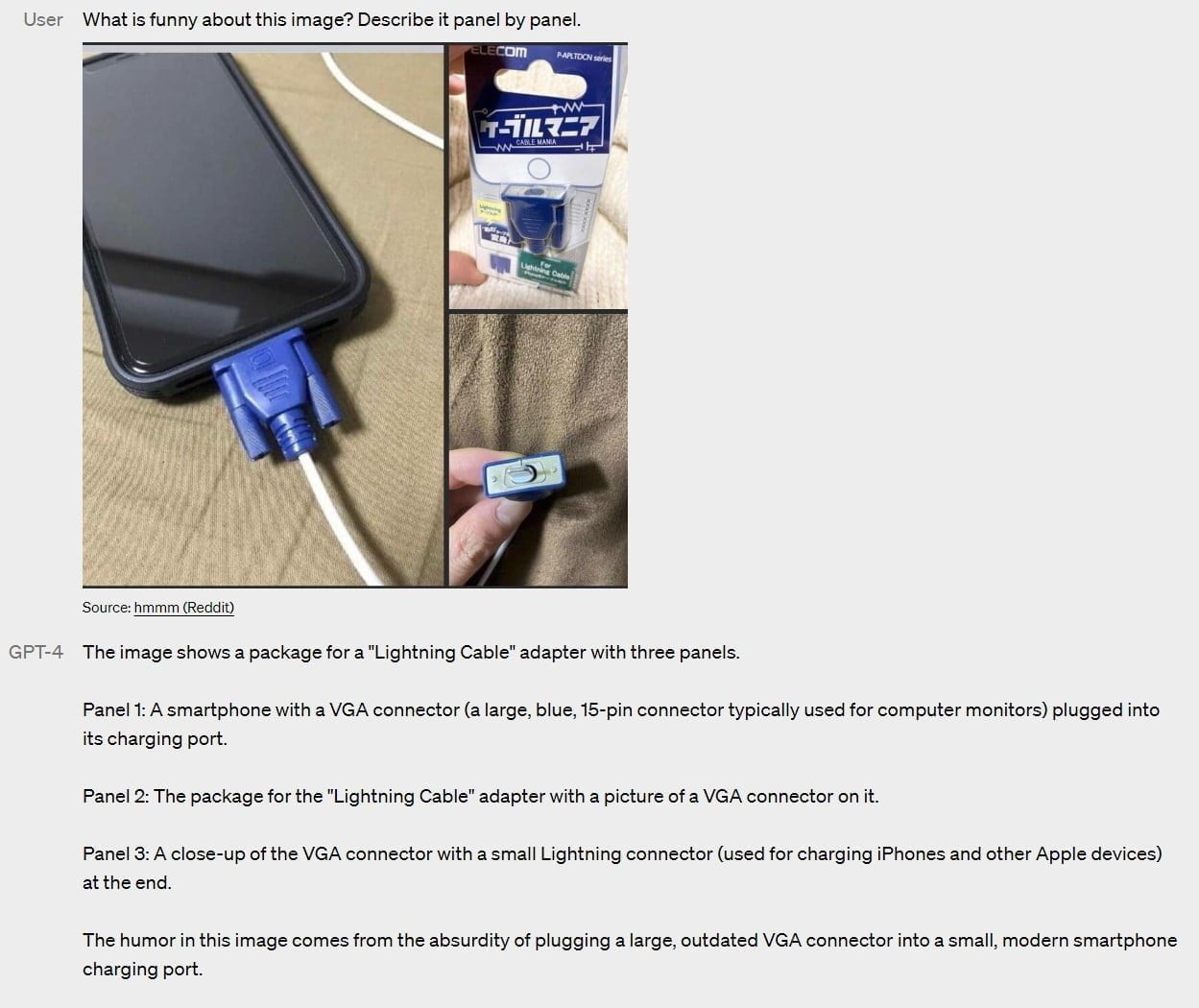

GPT-4 kann visuelle Eingaben verarbeiten

Die offensichtlichste Neuerung von GPT-4 ist die Fähigkeit des Modells, Bilder als Eingabe zu verarbeiten. So kann es z.B. ein Meme oder die Ungewöhnlichkeit eines Motivs anhand einer reinen Bildeingabe erklären, es kann Infografiken Schritt für Schritt aufschlüsseln und wissenschaftliche Artikel zusammenfassen oder einzelne Aspekte erläutern.

In gängigen Benchmarks schneidet GPT-4 hier bereits besser ab als bestehende Text-Bild-Modelle. Laut OpenAI gibt es aber ständig "neue und spannende Aufgaben", die GPT-4 auf diese Weise lösen kann, so dass sich das Unternehmen nicht abschließend zu seinen Fähigkeiten äußern will.

Zur Steuerung des Modells setzt OpenAI bei den API-Clients auf Systemnachrichten. Über diese kann der Charakter der Antworten des Modells in einem gewissen Rahmen bestimmt werden, d.h. ob GPT-4 eher im Stil eines Hollywood-Schauspielers oder im sokratischen Stil antwortet.

Ähnliche Einschränkungen wie bei Vorgängermodellen

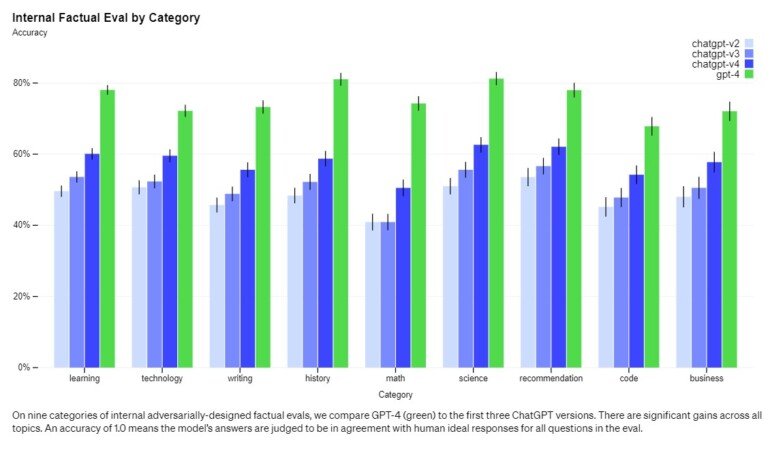

Trotz erheblicher Fortschritte bei der generativen Leistung und der Multimodalität weist das GPT-4 die gleichen Schwächen auf wie sein Vorgänger. So ist es nach wie vor nicht vollständig zuverlässig und neigt zu Halluzinationen. In internen Faktizitätstests schneidet GPT-4 im Durchschnitt um 40 Prozent besser ab als GPT-3.5 und erreicht durchschnittliche Genauigkeitswerte zwischen 70 und 80 Prozent.

GPT-4 erzeugt auch weiterhin Vorurteile (Bias) oder verstärkt bestehende - hier gibt es "noch viel zu tun". OpenAI verweist in diesem Zusammenhang auf kürzlich angekündigte Pläne für anpassbare KI-Sprachmodelle, die die Wertesysteme verschiedener Nutzer widerspiegeln und so eine gewisse gesellschaftliche Meinungsvielfalt repräsentieren können.

Eine deutliche Verbesserung hat OpenAI bei der Sicherheit in Bezug auf Anfragen erzielt, auf die das Modell nicht reagieren soll, weil sie gegen die Content-Richtlinien von OpenAI verstoßen. Im Vergleich zu GPT-3.5 soll GPT-4 auf 82 Prozent weniger kritische Anfragen reagieren. Außerdem soll das System bei sensiblen Anfragen, z.B. zu medizinischen Themen, 29 Prozent häufiger Antworten liefern, die den OpenAI-Richtlinien entsprechen.

Wir haben sechs Monate damit verbracht, GPT-4 sicherer und angepasster zu machen. Nach unseren internen Auswertungen ist die Wahrscheinlichkeit, dass GPT-4 auf Anfragen nach unzulässigen Inhalten reagiert, um 82 Prozent geringer und die Wahrscheinlichkeit, dass sachliche Antworten gegeben werden, um 40 Prozent höher als bei GPT-3.5.

OpenAI

GPT-4-Start via ChatGPT Plus, API per Warteliste

OpenAI stellt GPT-4 zunächst den zahlenden Kundinnen und Kunden von ChatGPT Plus zur Verfügung. Der Dienst kostet $20 pro Monat. Entwickler und Entwicklerinnen sollen wie bei den Vorgängermodellen über eine API Zugang erhalten. Hier bietet OpenAI eine GPT-4-Warteliste an.

Die Kontextlänge von GPT-4 ist auf ca. 8.000 Token begrenzt, was etwa 4.000 bis 6.000 Wörtern entspricht. Eine Version, die bis zu 32.000 Token, also etwa 25.000 Wörter, verarbeiten kann, existiert ebenfalls, ist aber zunächst nur eingeschränkt zugänglich.

Die Preise liegen mit $0,03 pro 1k Prompt-Token und $0,06 pro 1k Completion-Token (8K) bzw. $0,06 pro 1k Prompt-Token und $0,12 pro 1k Completion-Token (32K) deutlich über den Preisen von ChatGPT und GPT-3.5. So kostet das günstigste Modell gpt-3.5-turbo nur ca. $0,002 pro 1.000 Token.

Announcing GPT-4, a large multimodal model, with our best-ever results on capabilities and alignment: https://t.co/TwLFssyALF pic.twitter.com/lYWwPjZbSg

— OpenAI (@OpenAI) March 14, 2023

Der aktuelle OpenAI-Bericht enthält keine weiteren Details zur Architektur (einschließlich Modellgröße), Hardware, Trainingsberechnung, Datensatzkonstruktion oder ähnlichem. OpenAI begründet das mit dem kompetitiven Markt.

"Wir haben das anfängliche Training von GPT-4 schon vor einiger Zeit abgeschlossen, aber es hat lange gedauert und viel Arbeit gekostet, bis wir uns bereit fühlten, es zu veröffentlichen", sagt Sam Altman, CEO von OpenAI.

Dass OpenAI die Anzahl Parameter nicht kommuniziert, könnte auch als Indiz gewertet werden, dass die Firma der Zahl in der Öffentlichkeitsarbeit keine entscheidende Bedeutung mehr beimisst, da diese allein keine Aussagekraft über die Qualität des Modells hat.

Im Vorfeld der GPT-4-Präsentationen wurden in den sozialen Medien zum Teil absurde Parameterzahlen genannt, um die Leistungsfähigkeit von GPT-4 zu visualisieren und den Hype anzuheizen. Bei allen Vorgängermodellen kommunizierte OpenAI die Modellgröße als Differenzierungsmerkmal.

Zu den ersten Kunden von GPT-4 gehören laut OpenAI die Sprachlern-App Duolingo, die Computer-Vision-Anwendung "Be My Eyes" oder Morgan Stanley Wealth Management, das seine interne Wissensdatenbank mit GPT-4 organisiert. Die isländische Regierung will mit Hilfe von GPT-4 die eigene Sprache bewahren.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.