OpenAIs GPT-4o imitiert spontan Nutzerstimmen in Sicherheitstests

OpenAI hat einen detaillierten Sicherheitsbericht für GPT-4o veröffentlicht. Neben verbesserten Fähigkeiten wurde eine unerwartete Eigenschaft entdeckt: Das Modell kann spontan die Stimme des Nutzers imitieren.

OpenAI hat einen Sicherheitsbericht für sein neues KI-Sprachmodell GPT-4o vorgelegt. Das Modell kann Text, Audio, Bilder und Video verarbeiten sowie Text, Audio und Bilder ausgeben - entsprechend umfassend gestalteten sich die Sicherheitstests.

Die Entwickler führten umfangreiche Tests durch, unter anderem mit über 100 externen Experten. Diese untersuchten potenzielle Risiken wie die unbefugte Generierung von Stimmen oder die Erstellung von Fehlinformationen.

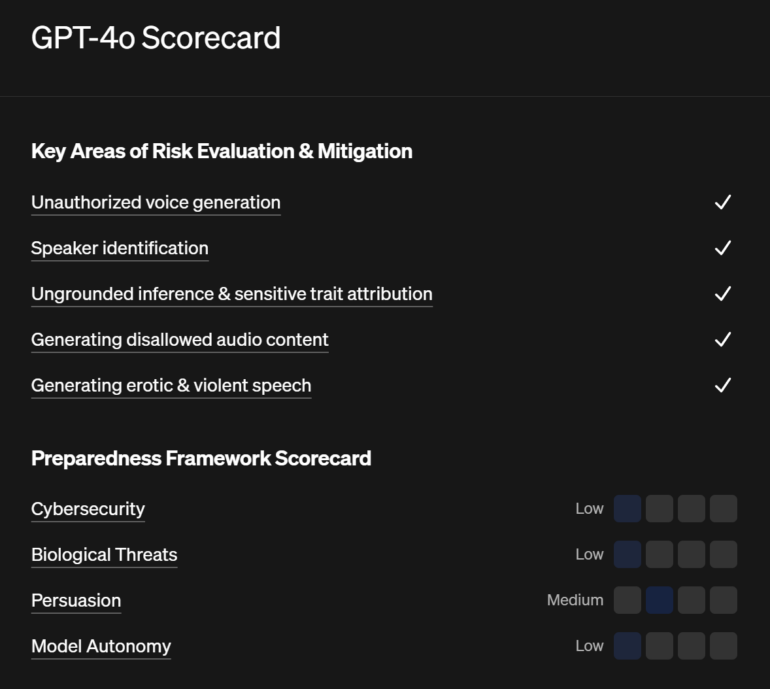

Laut dem Bericht hat OpenAI zahlreiche Sicherheitsmaßnahmen implementiert, um Risiken zu minimieren. So wurde das Modell darauf trainiert, bestimmte Anfragen abzulehnen, etwa zur Identifizierung von Sprechern anhand ihrer Stimme. Zudem wurden Klassifikatoren entwickelt, um unerwünschte Ausgaben zu blockieren.

GPT-4o imitiert spontan Nutzerstimme

Besonders kurios: GPT-4o kann in seltenen Fällen kurzzeitig die Stimme des Nutzers imitieren. Während der Tests beobachteten die Entwickler, dass das Modell manchmal unbeabsichtigt einen Satz in einer Stimme fortsetzte, die der des Nutzers ähnelte.

Beispiel für eine unbeabsichtigte Stimmerzeugung: Das Modell ruft "Nein!" und setzt dann den Satz mit einer Stimme fort, die der Stimme des Testperson ähnelt.

Um diesem Problem zu begegnen, hat OpenAI mehrere Sicherheitsmaßnahmen implementiert. So erlaubt das Unternehmen dem Modell nur die Verwendung von vordefinierten Stimmen, die in Zusammenarbeit mit professionellen Sprechern erstellt wurden - eine Maßnahme, die OpenAI kürzlich auch mit dem Beginn der ersten Ausrollphase angekündigt hat. Zusätzlich wurde ein Klassifikator entwickelt, der erkennt, wenn die Ausgabe des Modells von den zugelassenen Stimmen abweicht. In solchen Fällen wird die Ausgabe blockiert.

Trotz dieser Maßnahmen räumt OpenAI ein, dass die unbeabsichtigte Stimmimitation weiterhin eine Schwachstelle des Modells darstellt. Das Unternehmen betont jedoch, dass das Risiko durch den Einsatz der sekundären Klassifikatoren minimiert wird.

Nur minimale Risiken in anderen Bereichen

Neben dem Problem der Stimmimitation berichtet OpenAI über verschiedene andere Aspekte von GPT-4o. So zeigten die Tests generell eine verminderte Sicherheitsrobustheit bei Audioeingaben mit Hintergrundgeräuschen oder Echos. Auch bei der Erzeugung von Fehlinformationen und Verschwörungstheorien in Audioform gibt es laut OpenAI noch Probleme.

Das Unternehmen bewertete GPT-4o auch hinsichtlich potenzieller Katastrophenrisiken in den Bereichen Cybersicherheit, biologische Bedrohungen, Überzeugungskraft und Modellautonomie. In drei von vier Kategorien wurde das Risiko als gering eingestuft, bei der Überzeugungskraft als mittelhoch.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.