OpenAIs o1-preview erzielt Bestnoten in OpenAIs eigenem KI-Ingenieursbenchmark

OpenAI hat mit MLE-bench einen neuen Benchmark vorgestellt, der die Fähigkeiten von KI-Agenten bei der Entwicklung von Machine-Learning-Lösungen misst. Der Test umfasst 75 Kaggle-Wettbewerbe und soll helfen, die Fortschritte bei autonomen KI-Systemen für ML-Engineering zu bewerten.

Laut OpenAI soll MLE-bench eine robuste Messung der Fortschritte bei autonomen ML-Engineering-Agenten ermöglichen. Der Benchmark konzentriert sich dabei auf zwei Hauptaspekte: Die Auswahl von Aufgaben, die sowohl anspruchsvoll als auch repräsentativ für die aktuelle ML-Entwicklung sind, sowie die Möglichkeit, die Ergebnisse mit menschlichen Leistungen zu vergleichen.

Die 75 Wettbewerbe decken verschiedene Bereiche ab, darunter natürliche Sprachverarbeitung, Computer Vision und Signalverarbeitung. Viele der Aufgaben haben laut OpenAI einen realen Bezug, wie etwa die Vorhersage des Abbaus von COVID-19-mRNA-Impfstoffen oder die Entschlüsselung antiker Schriftrollen.

Erste Ergebnisse zeigen Potenzial und Grenzen

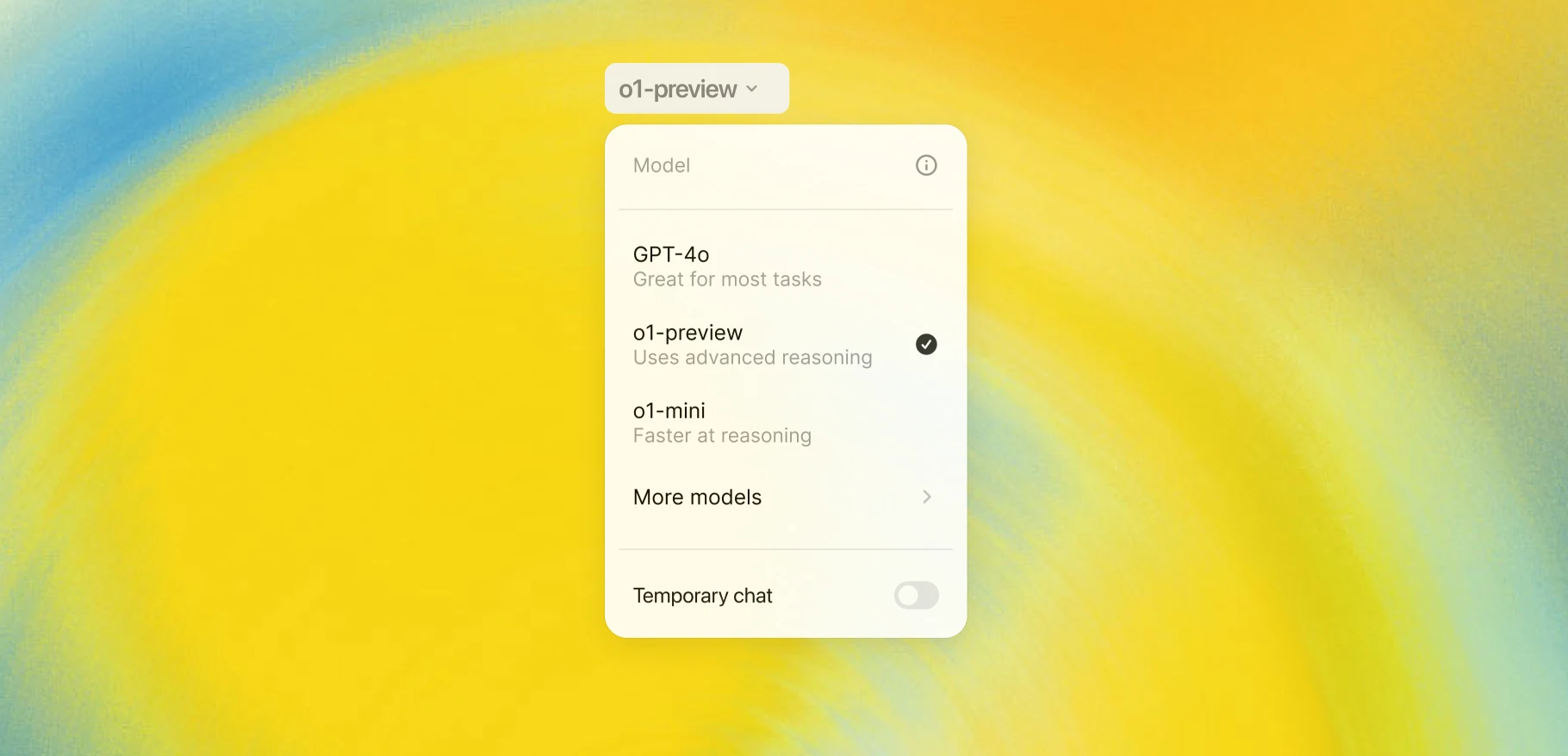

In ersten Experimenten hat OpenAI verschiedene KI-Modelle und Agent-Frameworks auf MLE-bench getestet. Das beste Ergebnis erzielte demnach das Modell o1-preview in Kombination mit dem AIDE-Framework. Es erreichte in 16,9 % der Wettbewerbe mindestens eine Bronze-Medaille und hing Anthropics Claude 3.5 Sonnet ab.

Die Forscher untersuchten auch, wie sich verschiedene Formen des Skalierens auf die Leistung der KI-Agenten auswirken. Dabei zeigte sich, dass mehr Versuche pro Wettbewerb die Erfolgsquote deutlich steigern: Bei 8 Versuchen verdoppelte sich die Medaillenquote von o1-preview auf 34,1%.

Auch eine Verlängerung der Bearbeitungszeit von 24 auf 100 Stunden pro Wettbewerb führte zu besseren Ergebnissen. GPT-4o steigerte sich dabei von 8,7% auf 11,8% Medaillen.

Überraschenderweise hatte die Bereitstellung zusätzlicher Rechenleistung in Form von GPUs keinen signifikanten Einfluss auf die Leistung. Die Forscher vermuten, dass die KI-Agenten die zusätzlichen Ressourcen noch nicht effektiv nutzen können.

MLE-bench soll weiter geführt werden

Bei der Entwicklung von MLE-bench musste OpenAI einige Herausforderungen bewältigen. Da die verwendeten Kaggle-Wettbewerbe öffentlich zugänglich sind, besteht laut dem Unternehmen das Risiko, dass die getesteten Modelle bereits während ihres Trainings mit den Aufgaben oder Lösungen in Berührung gekommen sein könnten.

Um diesem Problem zu begegnen, hat OpenAI verschiedene Maßnahmen ergriffen. So wurde ein Plagiatsdetektor eingesetzt, der die Einreichungen der Agenten mit den Top-Lösungen der jeweiligen Kaggle-Wettbewerbe vergleicht. Einreichungen mit einer Ähnlichkeit von über 60 % werden zur manuellen Überprüfung markiert.

Zusätzlich führte OpenAI Experimente durch, um mögliche Kontaminationseffekte zu untersuchen. Dabei fand das Unternehmen keine Korrelation zwischen der Vertrautheit von GPT-4 mit einem Wettbewerb und seiner Leistung in diesem Wettbewerb.

OpenAI räumt ein, dass MLE-bench nicht alle Aspekte der KI-Forschung und -Entwicklung abdeckt. Der Benchmark konzentriert sich auf Aufgaben mit klaren Problemstellungen, sauberen Datensätzen und eindeutigen Bewertungsmetriken. In der realen Welt seien die Herausforderungen oft weniger klar definiert.

Dennoch sieht OpenAI MLE-bench als wichtiges Werkzeug, um die Kernkompetenzen im Bereich des ML-Engineering zu evaluieren. Dazu gehören laut dem Unternehmen die Vorbereitung großer multimodaler Datensätze, das Management langfristiger Trainingsabläufe und das Debugging schlecht funktionierender Modelle.

Der Benchmark ist über GitHub verfügbar.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.