Die neueste Bild-KI von OpenAI, DALL-E 3, ist ein großer Schritt vorwärts, da das System Prompts besser versteht und gut passende Bilder in vielen Stilen erzeugt. Das verstärkt die Existenzängste einiger Grafiker und Künstlerinnen.

Zwar bietet OpenAI die Möglichkeit, die eigenen Grafiken und Bilder aus dem Trainingsmaterial zu entfernen. Das gilt aber nur für das Training des nächsten Modells.

Zudem würde diese Maßnahme nur dann greifen, wenn sich so viele Künstler und Künstlerinnen den KI-Modellen verweigern, dass die Qualität der Technologie erheblich leidet.

Gegenüber Bloomberg beschweren sich Künstler, dass der Opt-Out-Prozess mühsam sei und einer "Scharade" gleiche. Wie viele Künstler sich beschwert haben, gibt OpenAI nicht bekannt. Dafür sei es noch zu früh, aber OpenAI sammle Feedback und wolle den Prozess verbessern, so ein Sprecher der Firma.

Was den Künstlern bleibt: Urteil oder Sabotage

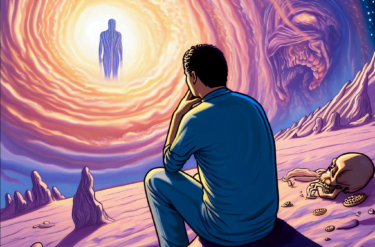

Künstlerinnen, die Bild-KI verhindern wollen, bleiben wohl nur zwei Wege: Sie können darauf hoffen, dass internationale Gerichte den zahlreichen Urheberrechtsklagen stattgeben und die Modellanbieter zur Rechenschaft ziehen. Doch die Prozesse könnten sich über Jahre hinziehen, Ausgang offen. Kurzfristige Lösungen sind nicht in Sicht.

Eine neue Bewegung beschäftigt sich mit der Sabotage von KI-Modellen. Mit Ansätzen wie Glaze können unsichtbare Pixel in Originalbilder implementiert werden, die dafür sorgen, dass das Bild den KI-Systemen falsche Stile vorgaukelt. So wird aus einem handgezeichneten Bild ein 3D-Rendering.

Das Tool Nightshade, benannt nach der hochgiftigen Tollkirsche, arbeitet nach dem gleichen Prinzip. Hier sollen die manipulierten Pixel aber sogar Schaden im Modell anrichten, indem sie es verwirren. Statt eines Zuges sieht das KI-System dann etwa ein Auto.

Giftpille für KI-Modelle

Weniger als 100 dieser "vergifteten" Bilder sollen ausreichen, um ein Bild-KI-Modell zu korrumpieren. Nightshade wird vom selben Team wie Glaze entwickelt und soll in Glaze integriert werden. Das Team bezeichnet Nightshade als "letzte Barriere" gegen Web-Scraper, die Scraping-Verbote nicht akzeptieren.

Nightshade, das derzeit noch nur als Forschungsprojekt existiert, könnte ein wirksames Instrument für Eigentümer von Inhalten sein, um ihr geistiges Eigentum vor Scrapern zu schützen, die Urheberrechtsvermerke, "Do not scrape/crawl"-Anweisungen und "Opt-out"-Listen missachten oder ignorieren, schreiben die Forscher.

Filmstudios, Buchverlage, Spieleproduzenten und einzelne Künstler könnten Systeme wie Nightshade einsetzen, um eine starke Abschreckungswirkung gegen unbefugtes Scraping zu erzielen.

Die Verwendung von Nightshade und ähnlichen Werkzeugen könnte jedoch auch negative Auswirkungen haben, einschließlich der Untergrabung der Zuverlässigkeit generativer Modelle und ihrer Fähigkeit, aussagekräftige Bilder zu erzeugen.

Aber selbst wenn Künstler diese Sabotage von Trainingsdaten kollektiv durchführen würden, wäre ein Wirkungstreffer wahrscheinlich schwierig. Zum einen könnten die Modellanbieter Gegenmaßnahmen ergreifen, indem sie beispielsweise die beschädigten Dateien herausfiltern.

Zum anderen dürfte das Training von KI-Modellen effizienter werden, wenn diese lernen, besser zu generalisieren. Leistungsfähige KI-Systeme benötigen dann zwar besonders hochwertige, aber weniger Daten. Mit zunehmender Qualität der generierten Bilder könnten diese zudem als synthetisches Trainingsmaterial infrage kommen.