Qwen3-Max ist Alibabas neues Spitzenmodell

Alibaba hat mit Qwen3-Max sein bisher größtes und leistungsstärkstes KI-Modell veröffentlicht. Die Verbesserungen machen das Modell für praktische Anwendungen in der Softwareentwicklung und Automatisierung interessanter.

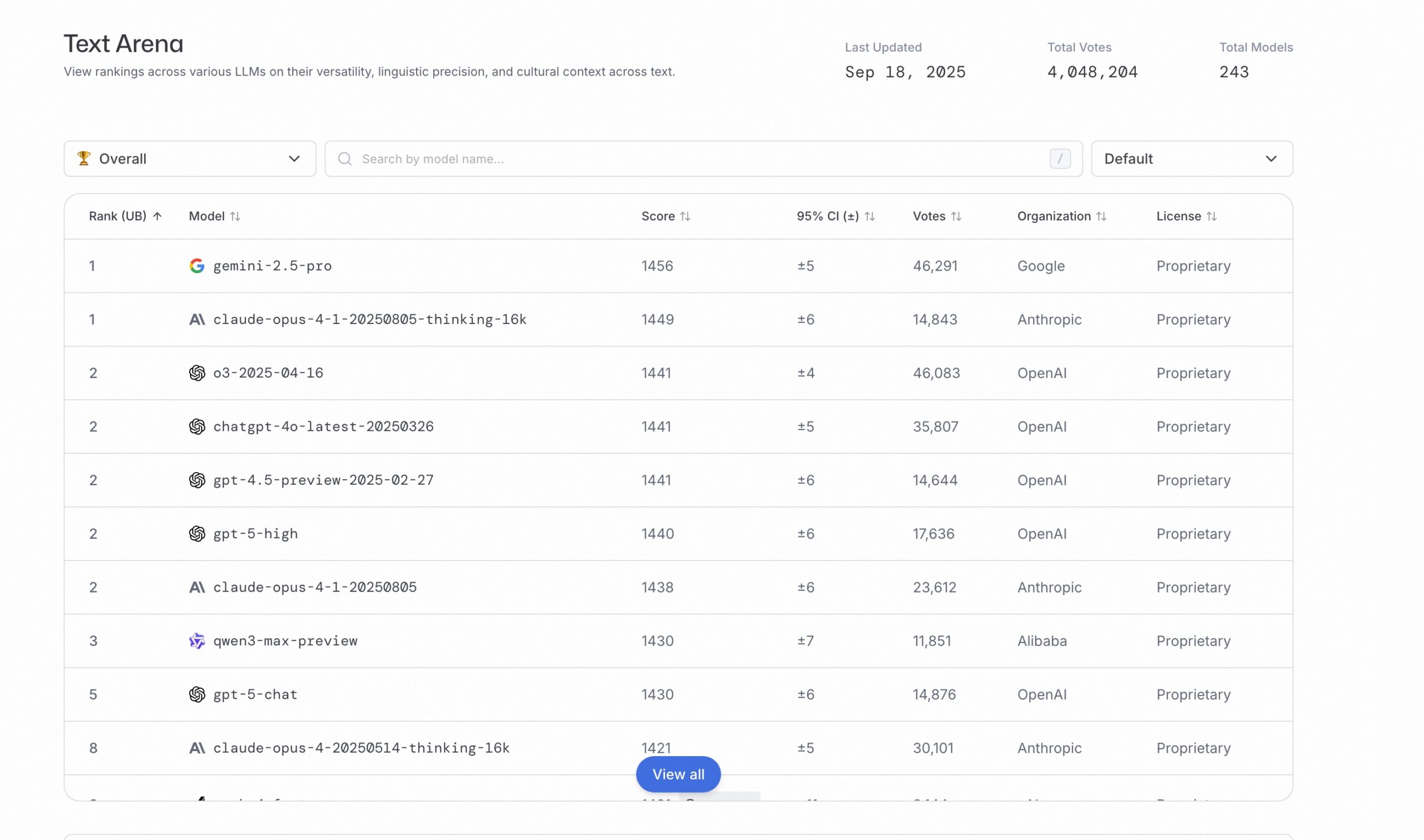

Das System basiert auf über einer Billion Parametern und wurde auf 36 Billionen Token trainiert. Die Anfang des Monats vorgestellte Preview-Version von Qwen3-Max-Instruct erreichte schon Platz drei im Text Arena Leaderboard und übertraf dabei GPT-5-Chat.

Skalierung auf über eine Billion Parameter

Qwen3-Max folgt laut Alibaba dem Design-Paradigma der bereits im April veröffentlichten Qwen3-Serie, skaliert aber auf über eine Billion Parameter. Die Architektur nutzt eine MoE-Struktur (Mixture of Experts), wodurch bei der Inferenz nur ein Teil der Parameter aktiviert wird.

Das Training verlief nach Angaben der Entwickler:innen außergewöhnlich stabil. Die Verlustfunktion blieb während des gesamten Trainings gleichmäßig und stabil, ohne Sprünge oder die Notwendigkeit für Trainings-Rollbacks oder Anpassungen der Datenverteilung.

Trainingseffizienz um 30 Prozent gesteigert

Die Trainingseffizienz von Qwen3-Max-Base wurde durch optimierte Parallelverarbeitung verbessert. Dies führte zu einer 30-prozentigen Steigerung der Rechenleistungsausnutzung gegenüber Qwen2.5-Max-Base.

Für das Training mit langen Kontexten setzten die Entwickler:innen spezielle Techniken ein, die eine dreifache Durchsatzverbesserung ermöglichten. Dadurch wurde Training mit einer Kontextlänge von einer Million Token möglich.

Zusätzlich entwickelten die Entwickler:innen Methoden zur automatischen Überwachung und Wiederherstellung des Trainings. Diese reduzierten die durch Hardware-Ausfälle verursachten Zeitverluste auf ein Fünftel der bei Qwen2.5-Max beobachteten Werte.

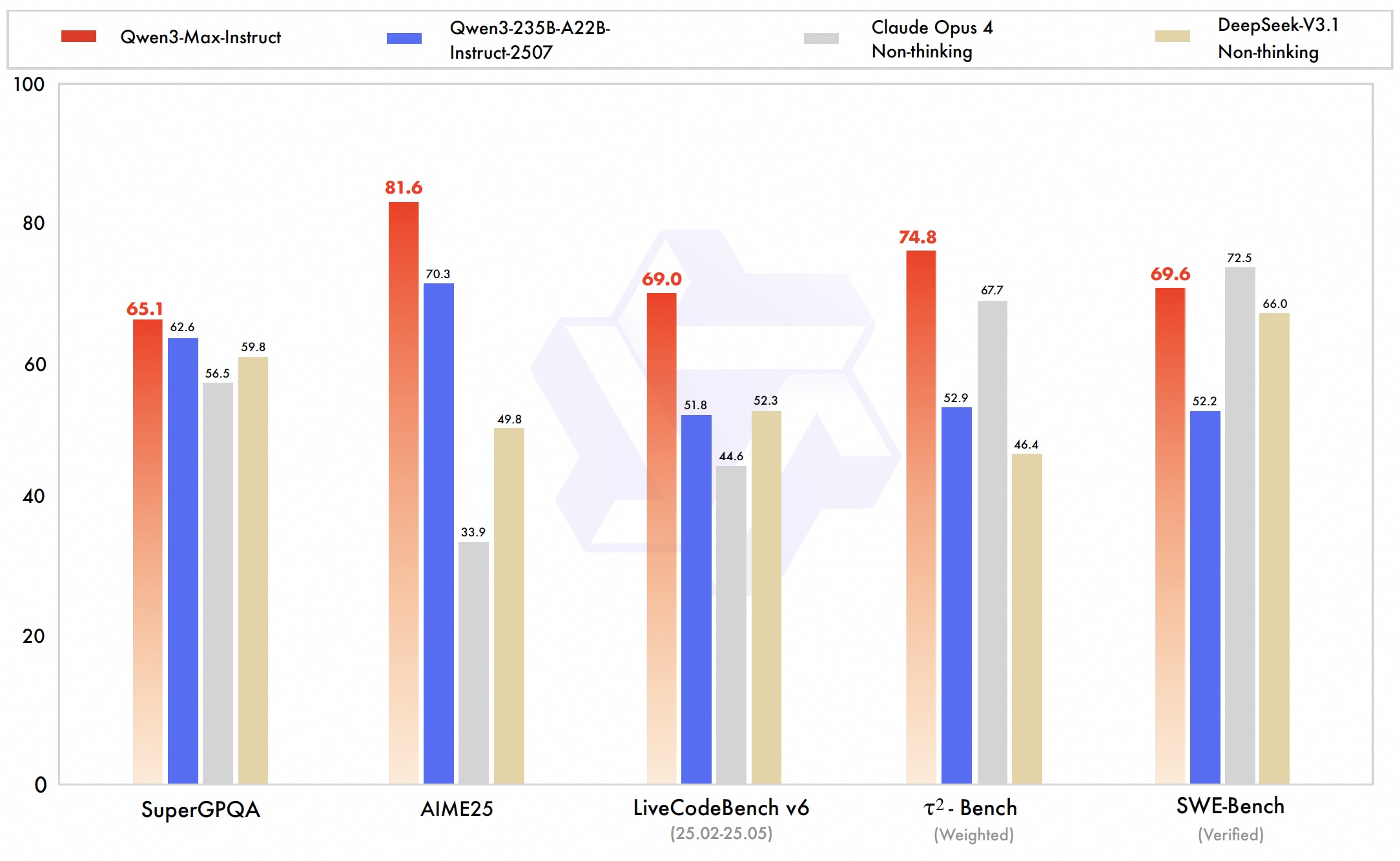

Das Qwen-Team berichtet, dass Qwen3-Max-Instruct Bestwerte in einer umfassenden Benchmark-Suite erreichte. Diese umfasst Wissen, logisches Denken, Programmierung, Instruktionsbefolgung, Ausrichtung nach menschlichen Präferenzen, Agent-Aufgaben und mehrsprachiges Verständnis.

Die Verbesserungen konzentrieren sich besonders auf Programmier- und Agent-Fähigkeiten, wodurch das Modell für praktische Anwendungen in der Softwareentwicklung und Automatisierung relevanter wird.

Qwen3-Max-Instruct erzielte etwa auf SWE-Bench Verified einen Score von 69,6. Dieser Benchmark testet, wie gut KI-Modelle echte Programmierfehler in Software-Projekten beheben können und positioniert das Modell laut Alibaba unter den weltweit leistungsstärksten Systemen.

Auf Tau2-Bench, das Agent-Tool-Calling-Fähigkeiten bewertet, erreichte Qwen3-Max-Instruct einen Score von 74,8 und übertraf damit sowohl Claude 4 Opus als auch Deepseek V3.1. Dieser Benchmark misst, wie präzise Modelle externe Werkzeuge aufrufen und in komplexe Arbeitsabläufe integrieren können.

Qwen3-Max-Thinking mit perfekten Mathematik-Scores

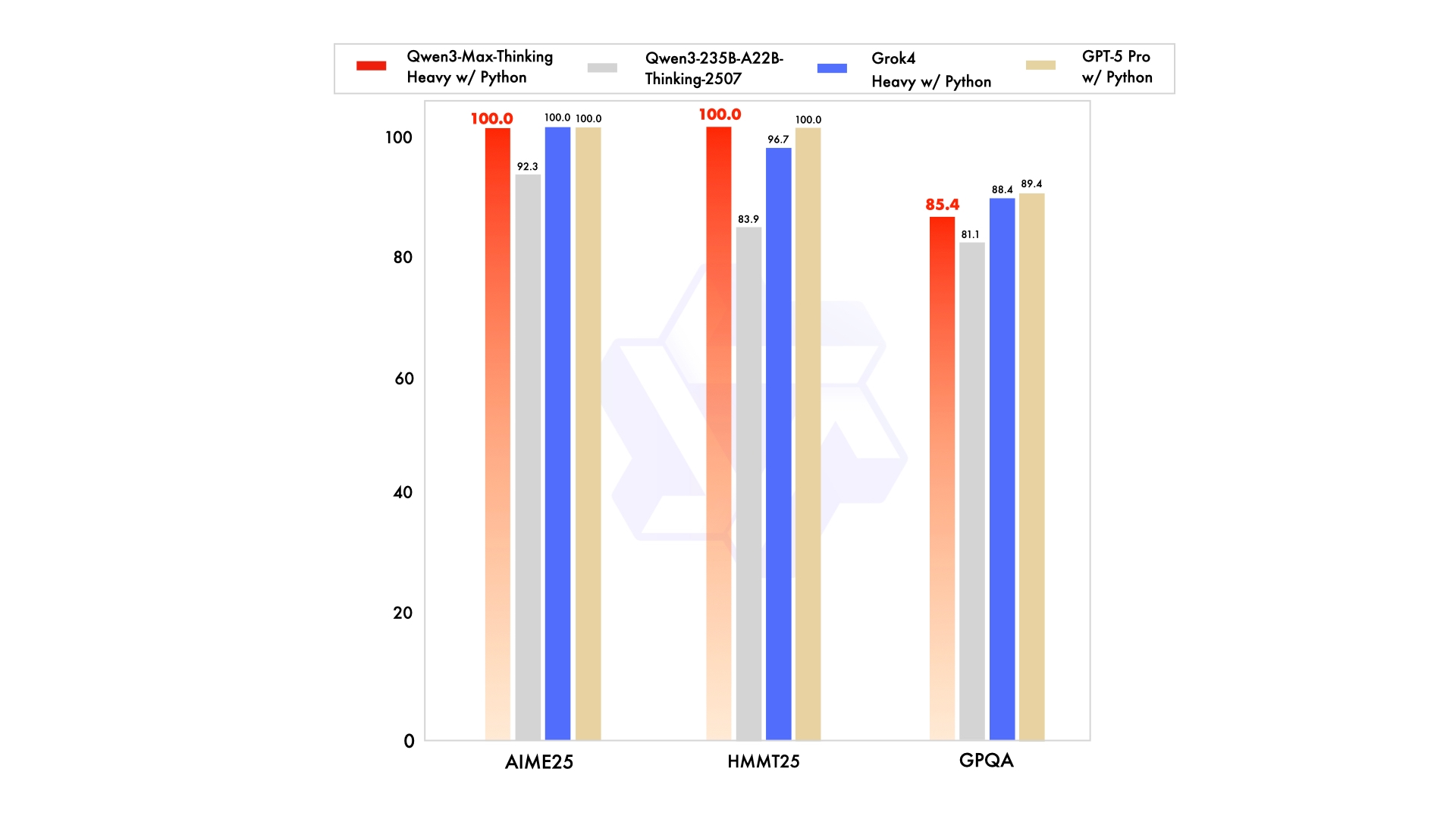

Die Reasoning-Variante Qwen3-Max-Thinking befindet sich noch im Training, zeigt aber bereits außergewöhnliche Leistungen. Durch die Integration eines Code-Interpreters und skalierte Test-Time-Compute erreichte sie perfekte 100-Punkt-Scores auf den anspruchsvollen mathematischen Reasoning-Benchmarks AIME 25 und HMMT wie zuvor auch GPT-5 Pro und Grok 4.

Bei Test-Time-Compute führt das Modell mehrere Lösungsversuche parallel aus und wählt die beste Antwort aus. AIME ist ein mathematischer Wettbewerb für Schüler:innen, dessen Aufgaben als besonders schwierig gelten und als Maßstab für logisches Denken dienen. Alibaba plant, diese Variante in naher Zukunft öffentlich zu veröffentlichen.

Verfügbarkeit und API-Zugang

Qwen3-Max-Instruct ist über Qwen-Chat verfügbar und im Gegensatz zu vielen anderen Modellen nicht Open-Source verfügbar. Entwickler:innen können die API über Alibaba Cloud Model Studio nutzen, wobei die Schnittstelle mit OpenAI-APIs kompatibel ist.

Qwen3-Max ist Teil einer umfassenden Modelloffensive von Alibaba. In den vergangenen Tagen stellte das Unternehmen eine ganze Reihe spezialisierter KI-Systeme vor: Qwen-3-TTS-Flash zur Generierung natürlicher Stimmen, Qwen-Image-Edit zur Bearbeitung von Bildern, Qwen3-Next mit besonders schneller Textverarbeitung und Qwen3-Omni als multimodales Modell zum nativen Verständnis und zur Generierung von Bildern.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.