Roboter-Technologie macht große Fortschritte durch Video-Lernen

Forschende zeigen VideoDex, eine Roboter-Lernmethode, die aus Internet-Videos menschlicher Interaktionen lernen kann.

Ein zentrales Ziel der Robotik sind Roboter, die autonom unterschiedliche Aufgaben in zahlreichen Umgebungen durchführen können. Um dieses Ziel zu erreichen, verwenden viele Entwicklungsmethoden erfolgreiche Roboterinteraktionen als Trainingsdaten.

Solche Daten sind jedoch selten, da der Einsatz von untrainierten Echtwelt-Robotern für die Datensammlung konstante Überwachung benötigen würde.

Für lernende Roboter ist das ein Henne-Ei-Problem: Um verlässlich Erfahrungen zu sammeln, muss der Roboter bereits Erfahrung haben, schreiben Forschende der Carnegie Mellon University (CMU) in einer neuen Arbeit.

Eine Lösung könnte das Training in einer Simulation sein. Doch hier gibt es bei der Übertragung der Simulationserfahrungen in die echte Welt zahlreiche Probleme.

VideoDex lernt von menschlichen Interaktionen

Das Team der CMU schlägt einen alternativen Ansatz vor: Lernen aus Internet-Videos, in denen Menschen in der realen Welt interagieren.

"Diese Daten können potenziell dazu beitragen, das Lernen von Robotern zu unterstützen, indem sie die Datenerhebungs- und Trainingsschleife umgehen", heißt es im Paper.

Videobeispiele aus dem Epic Kitchens Datensatz | Video: Shaw, Bahl et al., Epic Kitchens

Die Idee, Roboter mit Videos zu trainieren, ist nicht neu. Doch die meisten Videotrainings sollen Robotern visuelle Repräsentationen von Objekten beibringen.

Das habe Vorteile, vernachlässige jedoch eine zentrale Herausforderung im Roboter-Training: die zahlreichen möglichen Aktionen in einem Szenario.

Obwohl das Vortraining visueller Darstellungen zur Effizienz beitragen kann, glauben wir, dass ein großer Teil der Ineffizienz auf sehr große Aktionsräume zurückzuführen ist. Bei kontinuierlicher Steuerung ist das Lernen exponentiell zur Anzahl der Aktionen und Zeitschritte, und noch schwieriger bei Robotern mit hohem Freiheitsgrad.

Aus dem Paper

Neben dem visuellen Aspekt nutzt das CMU-Team daher die Trainingsvideos zusätzlich für die Vermittlung von Informationen über menschliche Bewegungsabläufe. So sollen Roboter Bewegungen lernen. Für das Training ihres Systems "Videodex" nutzen sie aus der Ich-Perspektive gefilmte Videos von Kücheninteraktionen.

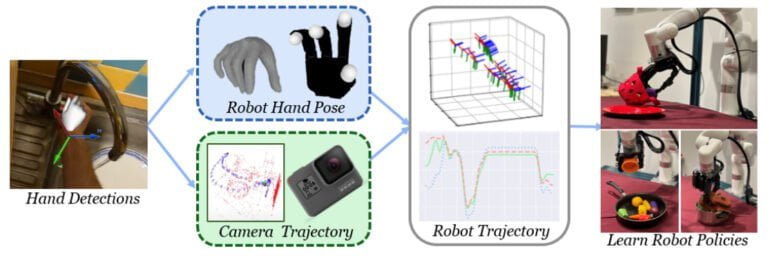

VideoDex zeigt Fingerfertigkeit

Damit VideoDex aus den Videos lernen kann, verwendet das Team Algorithmen, die Hand, Handgelenk und Kameraposition im Raum tracken. Die Handbewegungen werden auf die 16-DOF-Roboterhand und die Handgelenksbewegungen sowie die Kamerapositionen auf die Bewegungen des Roboterarms übertragen.

VideoDex nutzt neben diesen Handlungsinformationen gelernte visuelle Repräsentationen und gelernte Neural Dynamic Policies, die die Robotersteuerung verbessern. So ausgestattet, lernt das KI-System anhand hunderter oder tausender Videos über bestimmte menschliche Interaktionen wie das Aufheben, Öffnen oder Verdecken von Gegenständen.

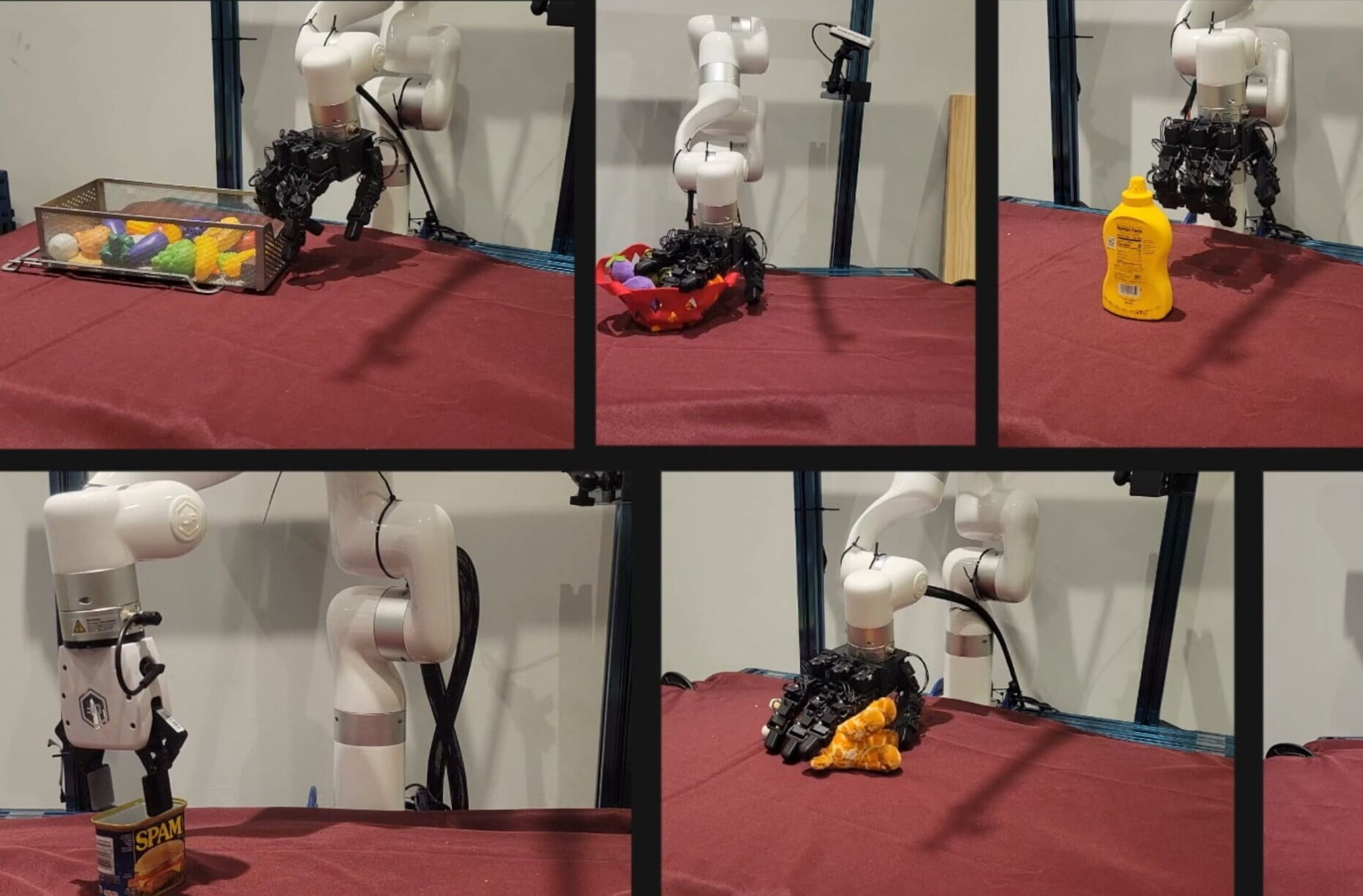

VideoDex benötigt nach dem Training nur einige wenige Beispiele aus der echten Welt, um viele der bisher besten Roboter-Lernmethoden in sieben verschiedenen realen Interaktionen zu übertreffen. Diese Beispiele können dem Roboterarm per menschlicher Fernsteuerung demonstriert werden.

Video: Shaw, Bahl et al.

Weitere Beispiele gibt es auf der Projektseite von VideoDex. Der Code soll dort demnächst veröffentlicht werden.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.