Chinas neuestes Sprach-KI-Modell ist multimodal trainiert und zehnmal größer als OpenAIs GPT-3. Es übertrifft sogar Googles gigantischen Google Switch Transformer.

Im März 2021 stellte die Beijing Academy of Artificial Intelligence (BAAI) Wu Dao 1.0 vor. Das KI-Projekt bestand aus vier verschieden großen KI-Modellen, darunter das 2,6 Milliarden Parameter große Sprachmodell Wua Dao - Wen Yuan, das bis dato größte chinesische Sprachmodell.

Laut den beteiligten Forschern erreicht die Künstliche Intelligenz in 20 Sprachbenchmarks mit OpenAIs GPT-3 vergleichbare Ergebnisse. Im Mai 2021 veröffentlichte Huawei dann PanGu-Alpha, ein 200 Milliarden Parameter großes chinesisches Sprachmodell.

Einen Monat später zeigen die Forscher des BAAI nun Wu Dao 2.0: Die neue Version ist ganze 1,75 Billionen Parameter groß und damit zehnmal größer als OpenAIs GPT-3 und 150 Milliarden Parameter größer als Googles Switch Transformer mit 1,6 Billionen Parametern. An dem Projekt sind neben der BAII 22 Partner beteiligt, darunter Xiaomi, Meituan und Kuaishou.

Wu Dao 2.0 knackt mehrere Benchmarks

Wu Dao 2.0 ist ein multimodales Modell ähnlich etwa OpenAIs DALL-E und CLIP oder Googles LaMDA und MUM. Es wurde mit 1,2 Terabyte chinesischem und 1,2 Terabyte englischem Text und insgesamt 2,5 Terabyte an Bildern trainiert.

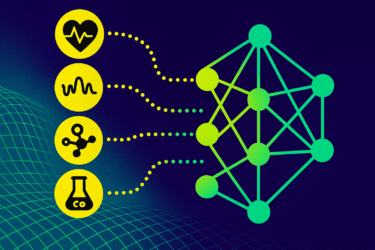

Für das Training des riesigen Modells nutzten die Forscher FastMoE, eine Open-Source-Architektur ähnlich Googles Mixture of Experts (MoE), die schon für Googles Switch Transformer zum Einsatz kam.

Dort werden bestimmte Informationen immer nur an ein Expertennetz innerhalb des großen Modells geleitet. Das reduziert die nötige Rechenleistung, da je nach verarbeiteter Information immer nur bestimmte Abschnitte des Modells aktiv sind.

Die riesige KI kann Gedichte schreiben, Texte zusammenfassen, Fragen beantworten oder Bilder auf Zuruf generieren. WuDao 2.0 hat laut den Forschern des BAAI in neun weit verbreiteten KI-Benchmarks die aktuelle State-of-the-Art (SOTA) erreicht oder überholt:

- ImageNet (zero-shot): SOTA, vor OpenAI CLIP.

- LAMA (factual und commonsense knowledge): Vor AutoPrompt.

- LAMBADA (cloze tasks): Vor Microsoft Turing NLG.

- SuperGLUE (few-shot): SOTA, vor OpenAI GPT-3.

- UC Merced Land Use (zero-shot): SOTA, vor OpenAI CLIP.

- MS COCO (text generation diagram): vor OpenAI DALL·E.

- MS COCO (English graphic retrieval): vor OpenAI CLIP und Google ALIGN.

- MS COCO (multilingual graphic retrieval): vor UC² (bestes multilingual und multimodal pre-trained model).

- Multi 30K (multilingual graphic retrieval): vor UC².

Eine wissenschaftliche Veröffentlichung zu Wu Dao 2.0 steht allerdings noch aus.

KI-Entwicklung: Europa läuft hinterher

Beteiligte Forscher sehen in Wu Dao 2.0 einen wichtigen Schritt auf dem Weg hin zu einer generellen Künstlichen Intelligenz (Erklärung). Ähnliche Ansichten rief bereits die Veröffentlichung von OpenAIs GPT-3 hervor, sie sind allerdings umstritten: KI-Forscher wie Gary Marcus oder jüngst Melanie Mitchell warnen vor zu viel Optimismus, dass eine generelle KI mit aktuellen Methoden der KI-Forschung überhaupt erreicht werden kann.

So oder so: China macht ernst im KI-Wettrennen und investiert Milliarden US-Dollar in den Ausbau von Rechenzentren und in KI-Forschungsprojekte. Ein GPT-Europe, wie es etwa der KI-Bundesverband im Januar 2021 forderte, gibt es bisher nicht.

Es bestehe die Gefahr, dass sich Monopole und Oligopole herausbilden, die zu einer einseitigen technologischen und wirtschaftlichen Abhängigkeit führen könnten, heißt es in der Veröffentlichung. Für den Erhalt der digitalen Souveränität in Europa sei daher der umgehende Start von Maßnahmen zwecks Aufbau eines offenen Services für große KI-Modelle erforderlich.

Via: Towardsdatascience