Google zeigt neue Methode für mehr Bild-Kontrolle mit Stable Diffusion

Generative KI-Modelle wie Stable Diffusion können Bilder generieren - aber nur schwer bearbeiten. Google zeigt eine neue Methode, die mehr Kontrolle ermöglicht.

Mit OpenAIs DALL-E 2, Midjourney oder Stable Diffusion haben Interessierte eine ganze Reihe von generativen Text-zu-Bild-Modellen zur Auswahl. Alle Modelle erzeugen glaubwürdige Bilder und können per Prompt Engineering gesteuert werden. In vielen Fällen ist die Wahl des Angebots daher vor allem eine Frage von persönlicher Präferenz, in einigen Fällen auch eine Frage von konkreten Anforderungen, die ein Modell besser erfüllen kann, als ein anderes.

Abseits des Prompt Engineering gibt es noch weitere Funktionen, die eine bessere Kontrolle über das gewünschte Ergebnis erlauben: Outpainting, Variationen oder das Bearbeiten eines Bildes. Vorreiter war hier OpenAIs DALL-E 2, in der Bearbeitungsfunktion können Bereiche eines Bildes maskiert und anschließend neu generiert werden. Ähnliche Lösungen existieren auch für Stable Diffusion.

Googles Prompt-to-Prompt erlaubt Kontrolle auf Text-Ebene

Doch die Bearbeitung durch Maskierung hat Einschränkungen, da sie im Schnitt nur recht grobe Veränderungen zulässt - oder eine aufwendige Kombination aus extrem genauer Maskierung und verschiedenen Prompt-Veränderungen erfordert.

Forschende von Google zeigen eine Alternative: Prompt-to-Prompt verzichtet auf Maskierungen und erlaubt stattdessen eine Kontrolle durch Veränderungen des ursprünglichen Prompts. Das Team greift dafür auf die Cross-Attention-Maps im generativen KI-Modell zu. Diese stellen das Verbindungsstück zwischen Text-Prompt und den generierten Bildern dar und enthalten so die für die Generierung relevanten Informationen.

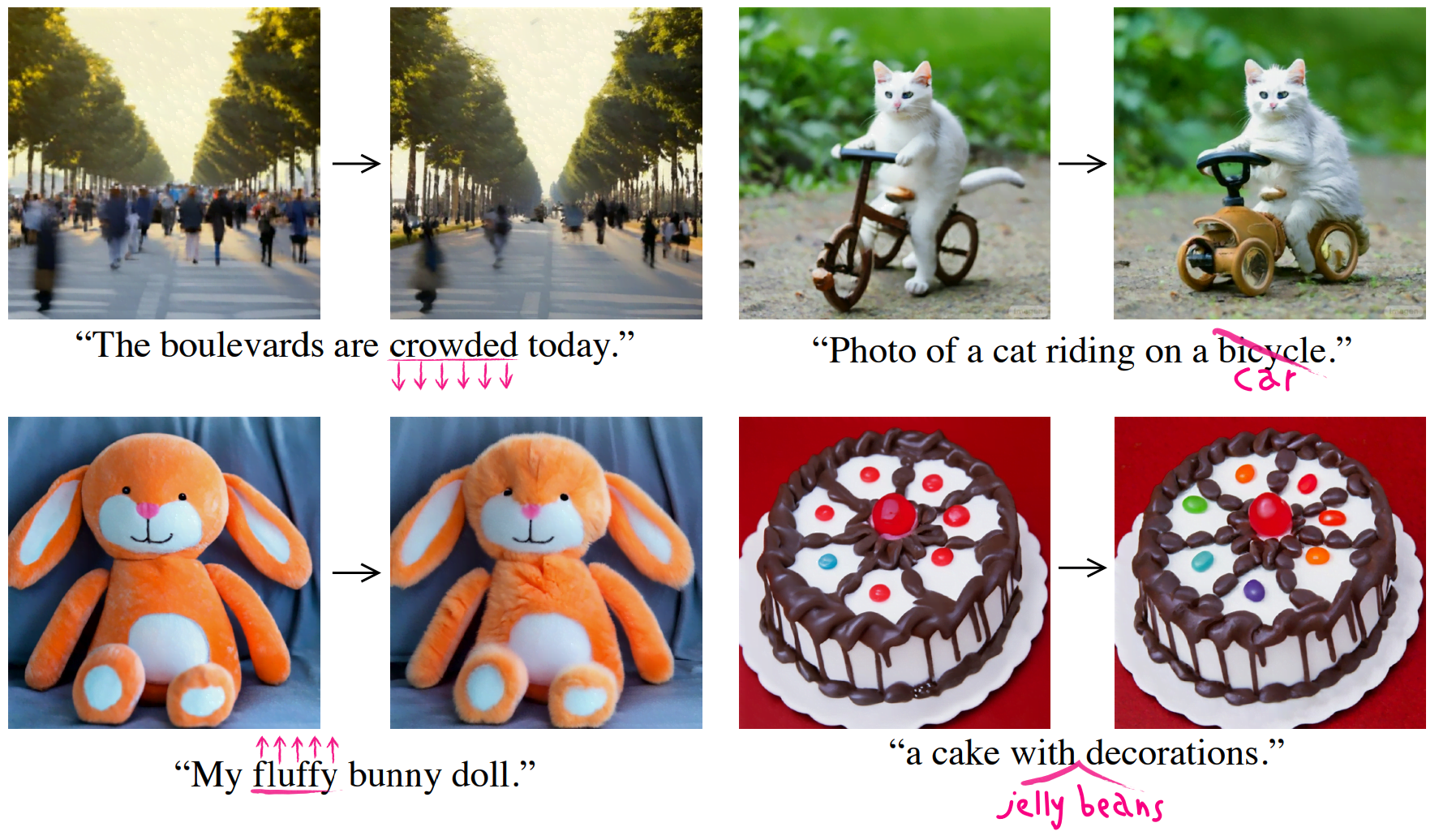

Veränderungen in diesen Cross-Attention-Maps können so den Diffusionsprozess des Modells steuern. Die Autor:innen zeigen davon mehrere Varianten. Eine davon erlaubt etwa die Veränderung eines einzigen Wortes des Text-Prompts, gleichzeitig bleibt dabei der Rest der Szene erhalten. So lässt sich etwa ein Fahrrad durch ein Auto ersetzen.

Mit einer anderen Methode können Wörter hinzugefügt und so einer ansonsten gleichbleibende Szene, Objekte oder andere visuelle Elemente hinzugefügt werden. Mit einer dritten Methode kann die Gewichtung einzelner Wörter angepasst und so ein Merkmal eines Bildes wie die Größe einer Menschengruppe oder die "Flauschigkeit" eines Teddybären verändert werden.

Prompt-to-Prompt lässt sich leicht für Stable Diffusion nutzen

Laut Google benötigt Prompt-to-Prompt keinerlei Nachtraining oder andere Optimierungen und kann direkt auf existierende Modelle für mehr Kontrolle angewandt werden. In ihrer Arbeit testen die Forschenden die Methode etwa mit Latent Diffusion und Stable Diffusion. Prompt-to-Prompt soll laut Google auf Grafikkarten mit mindestens 12 Gigabyte VRAM laufen.

Diese Arbeit ist ein erster Schritt auf dem Weg, den Benutzern einfache und intuitive Mittel zur Verfügung zu stellen, um Bilder zu bearbeiten und durch einen semantischen, textuellen Raum zu navigieren, der nach jedem Schritt inkrementelle Änderungen aufweist, anstatt nach jeder Textmanipulation ein Bild von Grund auf zu erzeugen.

Aus dem Paper.

YouTuber Nerdy Rodent zeigt in seinem Tutorial, wie sich Prompt-to-Prompt für Stable Diffusion nutzen lässt.

Weitere Informationen zu Prompt-to-Prompt und den Code gibt es auf GitHub.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.