Stable Virtual Camera verwandelt ein einzelnes Bild in ein 360-Grad-Video

Stability AI hat ein neues KI-System namens "Stable Virtual Camera" vorgestellt, das 2D-Bilder in immersive 3D-Videos transformieren kann. Laut dem Unternehmen benötigt das System dafür weder komplexe 3D-Rekonstruktionen noch aufwendige Szenenoptimierungen.

Das KI-System kann aus einem einzelnen Foto oder bis zu 32 Eingangsbildern 360-Grad-Videos von bis zu einer halben Minute Länge erzeugen. Dabei lassen sich 14 verschiedene Kamerabewegungen realisieren, darunter 360-Grad-Aufnahmen, Spiralen, Zoom-Effekte und komplexere Bewegungsmuster wie sogenannte Lemniskaten, also Pfade in Schleifenform.

Der Clou des Modells: Wenn alle Kameras eine Trajektorie bilden, sind die erzeugten Ansichten nach Stability AI dreidimensional und zeitlich konsistent und - wie der Name schon sagt - "stabil".

Video: Stability AI

Verschiedene Auflösungen möglich

Das System unterstützt nach Angaben von Stability AI verschiedene Bildformate wie quadratische (1:1), Portrait- (9:16) und Landscape-Aufnahmen (16:9). Überraschend für die Forschenden, denn Stable Virtual Camera wurde nur mit quadratischen Bildern der Größe 576x576 Pixel trainiert. Die Entwickler:innen vermuten, dass das Modell implizit gelernt hat, Bilder unterschiedlicher Größe zu verarbeiten.

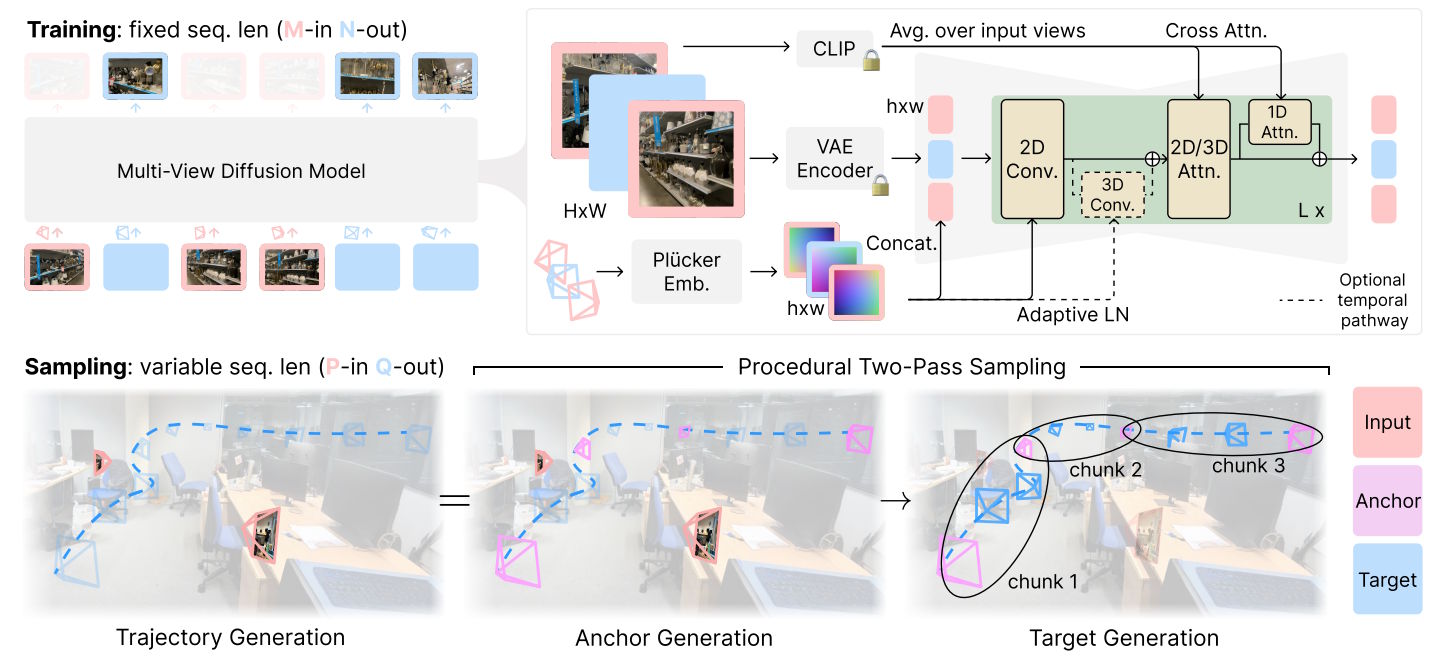

Das System basiert auf einem Diffusionsmodell mit 1,3 Milliarden Parametern, das auf der Stable-Diffusion-2.1-Architektur aufbaut. Laut den Forschenden wurde die 2D-Selbstaufmerksamkeit des Modells in eine 3D-Selbstaufmerksamkeit umgewandelt, um die räumlichen Beziehungen besser zu erfassen.

Die KI verarbeitet die Eingabebilder in zwei Durchgängen: Im ersten Durchgang werden sogenannte "Ankerbilder" aus den Eingabebildern generiert. Im zweiten Durchgang werden dann die gewünschten Zielperspektiven zwischen diesen Ankerpunkten erzeugt. Diese zweistufige Vorgehensweise soll laut den Entwicklern für besonders stabile und konsistente Ergebnisse sorgen.

In Benchmark-Tests übertrifft Stable Virtual Camera laut den Entwickler:innen bestehende Modelle wie ViewCrafter und CAT3D, sowohl bei großen Perspektivwechseln als auch bei der Erzeugung zeitlich flüssiger Übergänge.

Noch Schwächen bei komplexen Motiven

Das Verfahren hat noch Grenzen: Qualitätsprobleme treten bei der Darstellung von Menschen, Tieren oder dynamischen Texturen wie Wasser auf. Auch komplexe Kamerafahrten oder mehrdeutige Szenen können zu Bildfehlern führen, insbesondere wenn sich die Zielperspektive stark vom Ausgangsbild unterscheidet.

Stable Virtual Camera steht der Forschungsgemeinschaft unter einer nicht-kommerziellen Lizenz zur Verfügung. Die Modellgewichte können kostenlos über Hugging Face bezogen werden, der Quellcode ist auf GitHub verfügbar. Auf Hugging Face findet sich auch eine Demo.

Das Start-up Stability AI wurde nach anfänglich überzeugenden Bildgeneratoren sowohl von der wachsenden offenen als auch kommerziellen Konkurrenz technisch überholt. Vor allem mit Flux existiert eine überzeugende Alternative, die in vielen Fällen dessen Platz eingenommen hat.

Indes konzentriert sich das Unternehmen nach einer Restrukturierung einerseits auf Forschungsdurchbrüche in der 3D-Verarbeitung und Novel View Synthesis, andererseits auf den Einsatz von optimierten Modellen auf Geräten wie geringer Rechenleistung wie Smartphones.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.