Start-up Odyssey veröffentlicht Demo für begehbare KI-Videos

Das KI-Labor Odyssey präsentiert ein neuartiges Format: vollständig von KI generierte Videos, die in Echtzeit auf Nutzereingaben reagieren.

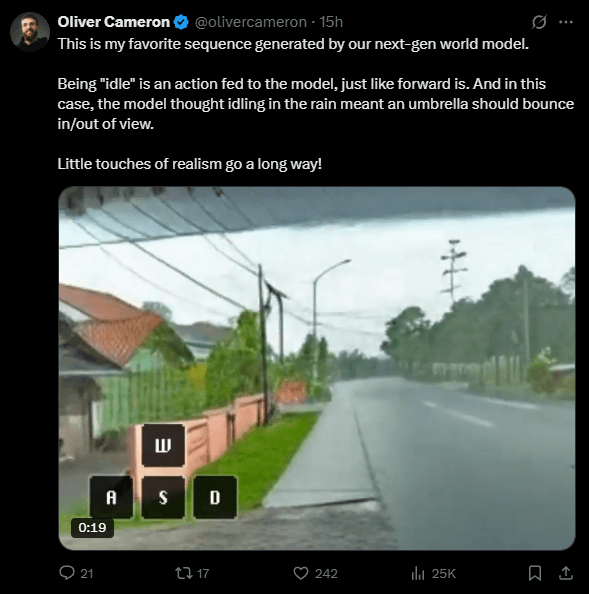

Odyssey zeigt in einer Forschungsvorschau sogenannte interaktive Videos – KI-generierte Bildsequenzen, die in Echtzeit auf Nutzereingaben reagieren. Nutzer können per Tastatur, Controller oder Smartphone mit dem Video interagieren, das sich entsprechend verändert. Möglich wird dies durch ein autoregressives Weltmodell, das den jeweils nächsten Weltzustand basierend auf aktuellem Zustand, Nutzeraktion und Historie berechnet.

Video: via Odyssey

Vom Video- zum Welten-Generator

Im Gegensatz zu klassischen Videomodellen, die ganze Clips auf einmal erzeugen, reagiert das Weltmodell von Odyssey frameweise auf Eingaben. Die Vision des Unternehmens geht dabei über bloße Videointeraktivität hinaus: Langfristig soll ein Modell entstehen, das Bilder und Handlungen so realitätsnah simuliert, dass sie von echtem Video nicht zu unterscheiden sind. Odyssey sieht darin die Grundlage für ein neues Medium – mit Anwendungen in Unterhaltung, Werbung, Bildung und darüber hinaus.

Die Technologie dahinter wird von Odyssey als "Weltmodell" klassifiziert – einem KI-System, das nicht nur Medien erzeugt, sondern dynamische Umgebungen simuliert. Solche Modelle gelten als potenzielle Trainingsumgebungen für agentische KI, die in simulierten Welten eigenständig agieren und lernen kann. Das wiederum soll es KI ermöglichen, aus eigenen Erfahrungen zu lernen.

| Weltmodell | Videomodell |

|---|---|

| Berechnet ein einzelnes Frame basierend auf dem aktuellen Zustand und der Nutzerinteraktion. | Erzeugt ein komplettes Video auf einmal, ohne spätere Eingriffsmöglichkeiten. |

| Jede Zukunft ist offen – das Modell reagiert dynamisch auf neue Eingaben. | Das Modell kennt Anfang und Ende des Clips von Beginn an. |

| Vollständig interaktiv – reagiert unmittelbar auf Nutzereingaben in Echtzeit. | Keine Interaktivität – der Clip läuft immer gleich ab. |

Die aktuelle Demo ist laut des Unternehmens noch instabil und roh, vermittelt aber bereits das Potenzial dieser neuen Form von KI-generierten Inhalten. Statt wie bisher Inhalte aufwendig zu produzieren, könnten zukünftig vollständig interaktive Erlebnisse direkt per KI erzeugt werden.

Stabilität durch eingeschränkte Generalisierung

Für die aktuelle Vorschau setzt Odyssey auf ein sogenanntes "Narrow Distribution Model". Das Modell wurde zunächst auf allgemeines Videomaterial trainiert und anschließend auf Videodaten aus wenigen, stark dokumentierten Umgebungen feinjustiert.

Laut Mitgründer Oliver Cameron sorgt die gezielte Einschränkung des Trainingsmaterials dafür, dass das Modell stabiler bleibt und nicht so leicht in unlogische Bildabfolgen abdriftet. Ein breiter trainiertes Modell würde laut Cameron schon nach 20 bis 30 Sekunden auseinanderfallen – die aktuelle Version soll dagegen etwa 2,5 Minuten lang konsistente Videosequenzen liefern.

Eine weitere Einschränkung der aktuellen Version ist, dass Nutzer sich nicht frei nach oben oder unten umsehen können. Auch das ist ein Ergebnis des fokussierten Trainings, das der Stabilität Vorrang vor maximaler Bewegungsfreiheit gibt.

Jedes einzelne Frame wird laut Cameron dabei durch ein eigens trainiertes Diffusionsmodell erzeugt. Eingaben der Nutzer werden in Echtzeit verarbeitet: Das Modell berechnet alle 40 Millisekunden ein neues Frame und streamt dieses zurück. Möglich wird das durch GPU-Cluster mit H100-Chips in den USA und der EU. Die Latenz liegt bei optimalen Bedingungen bei 40 Millisekunden, die Kosten pro Nutzerstunde derzeit zwischen ein und zwei US-Dollar – mit fallender Tendenz.

Parallel arbeitet Odyssey bereits an einem Modell mit größerer Generalisierung und realistischeren Dynamiken. Erste Rohfassungen zeigen laut des Start-ups eine höhere Vielfalt an Pixelmustern, Bewegungen und Interaktionen bei gleichzeitig besserer zeitlicher Konsistenz.

Ein verwandter Ansatz stammt vom Start-up Decart AI: Das Projekt Oasis ist ein Minecraft-ähnliches Spiel, das ebenfalls in Echtzeit von einer KI erzeugt wird. Ein auf Videos trainiertes Modell generiert Grafik, Physik und Gameplay, während Spieler mit Maus und Tastatur interagieren. Technisch kombiniert Oasis Vision-Transformer mit einem Diffusionsmodell zur Bildstabilisierung.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.