Google zeigt, welche zentrale Rolle große KI-Modelle in der Zukunft des Tech-Konzerns einnehmen werden. Die Vision ist die Überall-Suche, die digitale und echte Welt vernetzt.

Noch bevor Google neue Hardware wie Pixel 7, Pixel 6a oder Google Buds Pro zeigt, sprach CEO Sundar Pichai ausführlich über die jüngsten KI-Errungenschaften des Konzerns: Monolinguale Übersetzungsmodelle ermöglichen 24 neue Sprachen für Google Translate und durch Künstliche Intelligenz erkannte Gebäude machen mittlerweile 20 Prozent aller in Google Maps verzeichneten Gebäude aus.

Seit Juli 2020 habe KI die Anzahl der im afrikanischen Kontinent erkannten Strukturen von 50 auf 300 Millionen verfünffacht. Das von Google entwickelte KI-Modell ist außerdem frei verfügbar und werde etwa von den Vereinten Nationen und der Weltbank genutzt.

Visuell besonders beeindruckend: Immersive View ermöglicht dank der maschinellen Zusammenführung von Luft- und Satellitenaufnahmen sowie Fotos 3D-Kopien großer Städte als Livestream aus der Google Cloud auf jedem Gerät. Für den ebenfalls gezeigten virtuellen Ausflug ins Restaurant setzt Google ebenfalls auf Techniken des Neural Rendering. Google baut Maps so zur Grundlage für die Augmented-Reality-Cloud um.

Deepmind-Technologie für YouTube

Letztes Jahr startete Google automatisch generierte Kapitel für YouTube-Videos, dieses Jahr kündigt Pichai weitere Video-Verbesserungen dank multimodaler KI-Modelle von Deepmind an. Die Technologie analysiere Text, Audio und Bilder von Videos, um noch bessere Kapitel-Vorschläge zu generieren.

Spracherkennung für Autotranskriptionen von YouTube-Videos seien nun zudem für alle Android- und iOS-Nutzer:innen verfügbar. Automatisch generierte Übersetzungen seien ebenfalls für YouTube auf Mobile-Plattformen verfügbar, ein Update für die ukrainische Sprache soll in Kürze erscheinen.

Für Googles Workspace-Produkte zeigt Pichai die kürzlich für Google Docs veröffentlichte Zusammenfassungsfunktion: Ein Sprachmodell generiert auf Knopfdruck Zusammenfassungen für längere Dokumente. Diese Funktion soll bald auch für andere Produkte wie Google Chat und Google Meet erscheinen. Meet profitiere außerdem von neuen KI-Modellen, die die Video- und Beleuchtungsqualität verbessern.

Multimodale Suche: Das STRG+F für die Welt

Senior Vice President Prabhakar Raghavan, unter anderem verantwortlich für die Google Suche, zeigt kommende Updates für das kürzlich veröffentlichte Multisearch-Feature der Suchmaschine. Mit Multisearch können Nutzer:innen Bild- und Textsuche verbinden, etwa eine Trinkflasche fotografieren und nach einer Variante mit Blumenmotiv suchen.

Später im Jahr soll Multisearch eine lokale Suchfunktion erhalten: Wer nach einem Foto einer Pizza mit der "near-me"-Funktion sucht, bekommt Pizzerien in der Nähe angezeigt. Das Gleiche soll für zahlreiche Objekte funktionieren - von Nahrung bis zu Gebrauchsgegenständen.

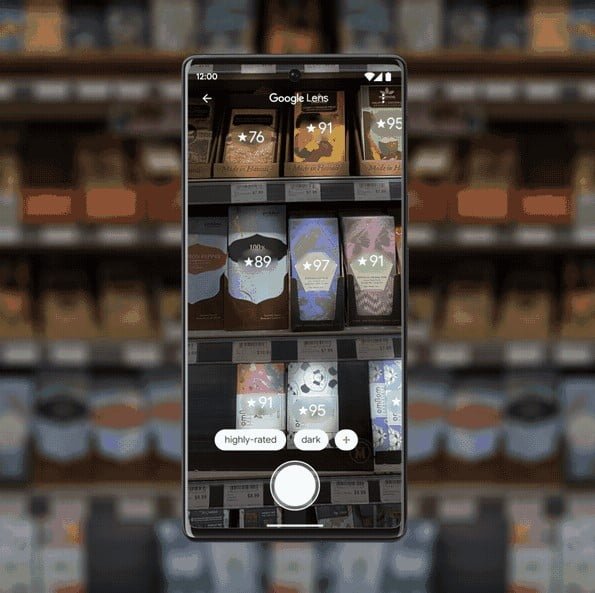

Die nächste Evolution von Multisearch soll Scene Exploration werden: Statt eines einzelnen Bildes sollen Nutzer:innen die Kamera über eine Szene schwenken und zum Bildkontext passende Fragen beantwortet bekommen.

Raghavan zeigt ein Beispiel, bei dem im Supermarkt aus einer ganzen Reihe von Produkten dunkle Schokolade ohne Nüsse mit hoher Qualität gefiltert wird. Die Technologie habe zahlreiche Anwendungen, etwa im Naturschutz, um seltene Pflanzen schnell zu identifizieren oder in der Apotheke, um eine bestimmte Creme zu finden.

Video: Google

Raghavan bezeichnet Scene Exploration als ein "STRG+F für die Welt", eine Idee, die ihre ganze Wirkung wohl besonders mit einer AR-Brille entfalten wird, zu denen sich Google ebenfalls klar bekannte.

LaMDA 2: Beta-Test für Googles Zukunft

Letztes Jahr gab Google bereits einen Einblick in die Entwicklung der großen KI-Modelle LaMDA und MUM. Während MUM als die Grundlage multimodaler Suche dienen soll, gehört LaMDA zu den großen Sprachmodellen. Anfang 2022 gab es bereits ein Update zu LaMDAs Fähigkeiten und Problemen. Seit dem Entwicklungsstart hätten tausende Google-Mitarbeiter:innen das Sprachmodell getestet, so Pichai.

Auf der diesjährigen Entwicklerkonferenz zeigte Google nun LaMDA 2, eine verbesserte Version des großen Sprachmodells. Wie bereits letztes Jahr verkündet, hält sich Google mit der Veröffentlichung vorerst zurück.

Stattdessen soll LaMDA 2 im Laufe des Jahres mehr und mehr ausgewählten Personen über die App "AI Test Kitchen" zur Verfügung gestellt werden. Die App wird in den kommenden Monaten in den USA ausgerollt und wird vorerst über Einladungen verfügbar sein.

In der App sind vorerst drei LaMDA-2-Apps verfügbar, die verschiedene und teilweise besonders herausfordernde Anwendungen darstellen. In "Imagine it" generiert LaMDA interessante Beschreibungen und ist wohl am uneingeschränktesten verfügbar.

Video: Google

In "Talk About It" soll LaMDA ausschließlich über ein bestimmtes Thema sprechen, etwa über Hunde in der "Dogs Edition". Bei Fragen, die vom Thema wegführen, soll LaMDA das Gespräch wieder auf Hunde führen.

Video: Google

In "List It" generiert das Sprachmodell eine Liste nützlicher Ideen oder untergeordneter Aufgaben. In einer Demonstration erstellt LaMDA etwa eine Anleitung zum Anlegen eines Gemüsegartens.

Video: Google

In der App können Nutzer:innen Feedback geben, die das Modell langfristig verbessern sollen. Google will mit Forschenden aus verschiedenen Disziplinen, Menschenrechtler:innen sowie politischen Entscheidungsträger:innen zusammenarbeiten und Feedback sammeln.

In Zukunft könnten in der App weitere KI-Modelle getestet werden. Google kann so die vorhandene mobile Infrastruktur nutzen, um eigene KI-Produkte in einem kontrollierbarem Umfeld zu testen und weiterzuentwickeln.

Gegen Ende der LaMDA-Präsentation spricht Pichai noch über die beeindruckenden Fähigkeiten des großen Sprachmodells PaLM und zeigt ein Beispiel, in dem das Modell eine Frage in bengalischer Sprache korrekt beantwortet und ins Englische übersetzt. Er betont, PaLM habe nie explizit gelernt, Fragen zu beantworten oder zu übersetzen.

Große Sprachmodelle werden in Zukunft wohl eine noch zentralere Rolle in Googles Produkten einnehmen: "Wir sind sehr optimistisch, was das Potenzial von Sprachmodellen angeht. Wir hoffen, dass wir eines Tages Fragen zu mehr Themen in jeder gesprochenen Sprache beantworten können und so den Zugang zu Wissen in der Suche und bei Google insgesamt noch weiter verbessern", schließt Pichai.