Studie: OpenAIs o1 setzt auf "Trial-and-Error" und informelles Schlussfolgern

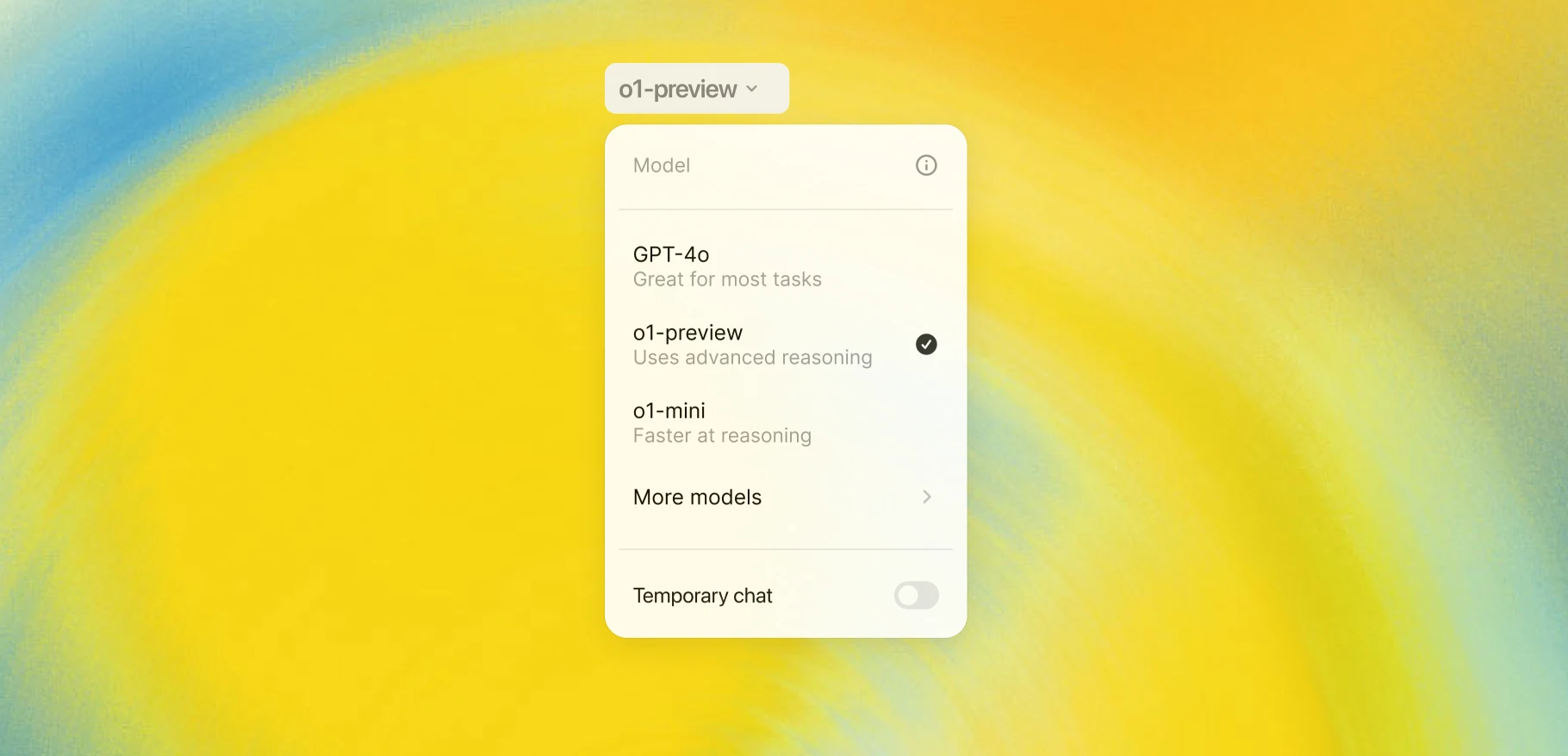

Löst OpenAIs KI-Modell o1 mathematische Probleme durch logisches Denken oder stützt es sich auf auswendig gelernte Lösungen? Eine neue Studie liefert Antworten durch den Vergleich öffentlicher und privater Datensätze.

Laut der Studie "OpenAI-o1 AB Testing" gibt es keine signifikanten Belege dafür, dass das o1-mini-Modell bei der Lösung mathematischer Probleme hauptsächlich auf das Auswendiglernen von Lösungen zurückgreift. Die Forscher verglichen dafür die Leistung des Modells bei öffentlich zugänglichen Mathematik-Olympiade-Aufgaben mit seiner Leistung bei ähnlich schwierigen, aber weniger bekannten Trainingsaufgaben des chinesischen Nationalteams.

Die Ergebnisse zeigen, dass das Modell in beiden Datensätzen ähnlich gut abschneidet. Bei Suchaufgaben erreicht es eine Genauigkeit von rund 70 Prozent, bei reinen Rechenaufgaben etwa 21 Prozent. Diese konstante Leistung über beide Datensätze hinweg deutet darauf hin, dass o1-mini im Kontext der Mathematik tatsächlich logisch schlussfolgert, statt nur memorierte Lösungen zu reproduzieren. Die Arbeit wurde vor der Veröffentlichung der o1-Vollversion und des o1-Pro-Modus verfasst und enthält daher keine Tests zu diesen Varianten.

KI hat Probleme mit detaillierten Beweisen

Die Forscher stellen jedoch fest, dass das getestete o1-mini-Modell Schwächen bei der Formulierung detaillierter mathematischer Beweise hat. Stattdessen verwendet es häufig einen "Trial-and-Error"-Ansatz und findet Lösungen durch informelles Schlussfolgern und heuristisches "Raten".

Bei sogenannten "Suchaufgaben", bei denen bestimmte Zahlenkombinationen oder Ausdrücke gefunden werden müssen, gelingt es dem Modell oft nicht zu beweisen, warum keine weiteren Lösungen existieren. Es beschränkt sich darauf, die gefundenen Lösungen zu verifizieren.

Graustufen statt Schwarz-Weiß

Positiv bewerten die Forscher, dass o1 bei vielen Aufgaben eine ähnliche mathematische Intuition zeigt wie Menschen. Das Modell kann oft den richtigen Lösungsweg erkennen und wichtige Zwischenschritte identifizieren, auch wenn die formale Ausarbeitung unvollständig bleibt.

Die Studie zeigt, dass o1-mini zwar kein perfekter mathematischer Problemlöser ist, aber durchaus über echte Schlussfolgerungsfähigkeiten verfügen könnte. Die konstante Leistung über verschiedene Datensätze hinweg widerlegt laut dem Team die Annahme, dass das Modell hauptsächlich durch Auswendiglernen funktioniert.

Bereits kurz nach Release von o1-mini und o1-preview berichtete ein Mathematiker, wie das System ihn unterstützen konnte. Im Oktober untersuchte eine Studie der Princeton University und der Yale University, welche Faktoren die Leistung von Sprachmodellen bei der Lösung von Aufgaben mit Chain-of-Thought (CoT)-Prompts beeinflussen. CoT ist ein zentraler Bestandteil des o1-Trainings und der Inferenz. Der Studie zufolge nutzen die Modelle Wahrscheinlichkeiten und Auswendiglernen - aber auch eine "probabilistische Version echten Schlussfolgerns". Rein symbolisches Schlussfolgern fanden die Forscher dagegen nicht.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.