Tencent schafft eine Milliarde KI-Persönlichkeiten als Multiplikator für synthetische Daten

Forscher des Tencent AI Lab Seattle haben eine neue Methode zur Generierung synthetischer Daten vorgestellt: synthetische Persönlichkeiten.

Das Tencent AI Lab nennt sie "Personas" und schafft damit Stellvertreter für reale Menschen, um Milliarden synthetischer Datensätze für die Entwicklung von KI-Systemen zu generieren.

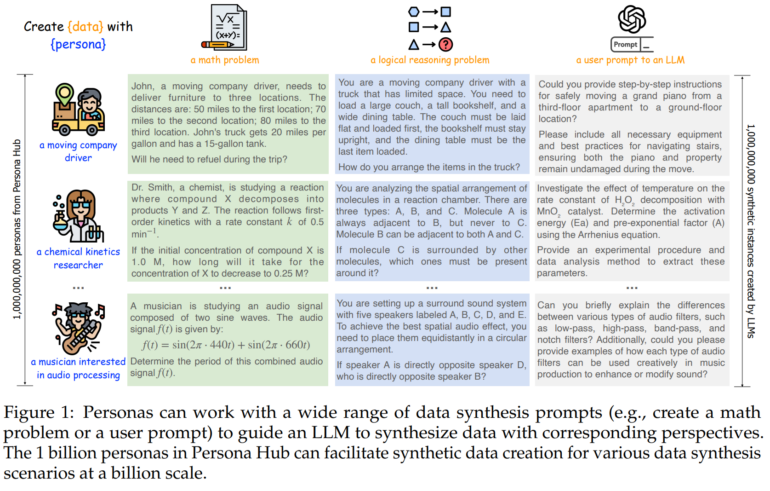

Als Teil der Forschung hat das Team den "Persona Hub" geschaffen, eine Sammlung von 1 Milliarde virtueller Charaktere. Die Forscher verwenden zwei Ansätze: Bei "Text-to-Persona" werden Persönlichkeiten aus Webtexten abgeleitet. "Persona-to-Persona" hingegen generiert neue Personas auf Basis von Beziehungen zu bereits erstellten Persönlichkeiten. Im Prinzip dienen die Personas als eine Art Multiplikator für synthetische Daten, da die unterschiedlichen Hintergründe jeweils eigene Datenvarianten erzeugen können, ähnlich wie beim Prompting eine zugewiesene Rolle die Ausgabe von Sprachmodellen beeinflusst.

Synthetische Personas können dazu verwendet werden, eine Vielzahl von Daten für das Training von KI-Modellen zu generieren. Als Beispiele nennen sie mathematische Probleme, logische Denkaufgaben und Anweisungen für Sprachmodelle.

Personas können Wissen großer Sprachmodelle "auslesen"

In einem Experiment generierten die Forscher mit Hilfe von Persona Hub 1,07 Millionen mathematische Aufgaben. Ein damit trainiertes Modell mit 7 Milliarden Parametern erreichte im MATH-Benchmark eine Genauigkeit von 64,9 Prozent. Das entspricht der Leistung von OpenAIs gpt-4-turbo-preview bei einem Bruchteil der Modellgröße.

Die Wissenschaftler sehen in ihrer Methode das Potenzial für einen Paradigmenwechsel in der Datengenerierung für KI. Statt auf von Menschen erzeugte Daten angewiesen zu sein, könnten große Sprachmodelle künftig selbst vielfältige synthetische Daten erzeugen. Weitere Anwendungsmöglichkeiten sieht das Team für NPCs in Videospielen oder in der Entwicklung von berufsspezifischen Tools.

Die Publikation weist aber auch auf mögliche Risiken und ethische Bedenken hin. So könnte die Methode es ermöglichen, die gesamte in einem Sprachmodell gespeicherte Wissensbasis quasi "auszulesen" und zu replizieren.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.