Tencent stellt Open-Source-Videogenerator HunyuanVideo vor und fordert Sora heraus

Der chinesische Technologiekonzern Tencent präsentiert mit HunyuanVideo ein Open-Source-Modell für KI-Videogenerierung, das mit proprietären Lösungen konkurrieren soll.

Tencent hat mit HunyuanVideo ein neues Open-Source-Modell für KI-gestützte Videogenerierung vorgestellt. Mit über 13 Milliarden Parametern ist es nach Angaben des Unternehmens das größte öffentlich verfügbare Modell seiner Art.

Laut der technischen Dokumentation übertrifft HunyuanVideo bestehende Systeme wie Runway Gen-3 und Luma 1.6 sowie drei führende chinesische Videogenerierungsmodelle. Besonders bei der Bewegungsqualität erzielt das System die besten Gesamtergebnisse.

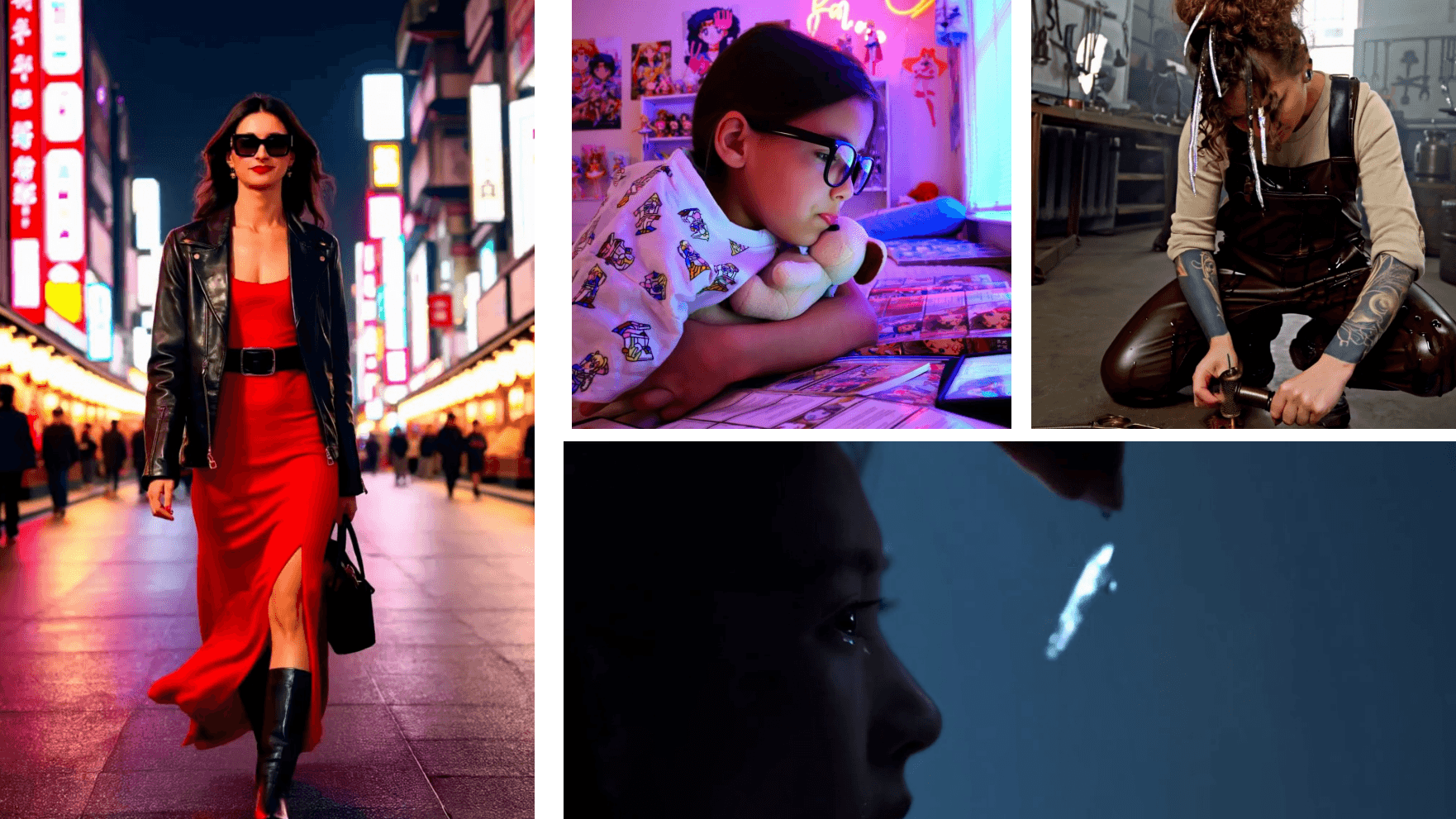

Video: Tencent

HunyuanVideo setzt auf stufenweises Training

Das Modell beherrscht nach Angaben von Tencent ein breites Spektrum an Aufgaben: Es kann Videos aus Text generieren, Bilder in Videos umwandeln und Avatar-Animationen erstellen. Auch die Generierung von Audio zu Videos gehört zum Funktionsumfang.

Das Training des Modells erfolgt nach Angaben der Entwickler in mehreren Stufen. Zunächst wird es mit Bildern in niedriger Auflösung (256 Pixel) trainiert, gefolgt von einem Mix-Scale-Training mit höheren Auflösungen.

Anschließend durchläuft das System ein progressives Video- und Bild-Training bei dem die Auflösung und Videolänge schrittweise erhöht werden. Diese Methode verbessere die Konvergenz und Qualität der generierten Videos, so das Team.

Tencent sieht breites Spektrum an Anwendungen

Die Veröffentlichung als Open Source soll nach Angaben von Tencent dazu beitragen, die Lücke zwischen geschlossenen und offenen Systemen zu schließen. Der Code ist auf GitHub verfügbar, und das Unternehmen plant eine kontinuierliche Weiterentwicklung des Systems mit neuen Funktionen.

Konkurrenz macht Tencent damit nicht nur Anbietern wie Runway oder OpenAI, das weiter an Sora arbeitet. Insbesondere von chinesischen Herstellern gibt es einige leistungsfähige Videomodelle, darunter KLING.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.