Tensorflow: Neues 3D-Bodytracking läuft im Browser - probiert es selbst

Das neueste Tensorflow-Modell für 3D-Körpertracking zeigt eindrucksvoll den Fortschritt bei KI-gestützten Trackingverfahren.

Vor einigen Jahren schien es unvorstellbar, dass präzises Raum- oder Körpertracking ohne enorme Rechenleistung und nur mit einzelnen Kameras möglich ist. Dann folgten große Fortschritte beim visuellen Training neuronaler Netze sowie bei der Architektur von KI-Modellen. Heute laufen Tracking-Algorithmen - salopp formuliert - auf jedem Toaster.

Tensorflow-Update bringt 3D-Körpertracking

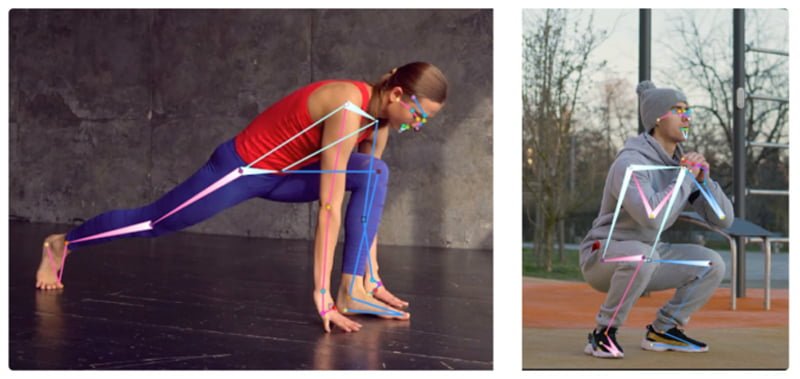

Die neuste Tensorflow-Version bietet 3D-Körpertracking jetzt direkt im Browser mit einer einzelnen Kamera. Frühere Versionen unterstützten bereits 2D-Körpertracking, jetzt werden erstmals Bewegungen in die Tiefe korrekt erfasst.

Die von Google erdachte Open Source KI-Softwarebibliothek nutzt für das 3D-Tracking MediaPipe und TensorFlow.js mit FaceMesh, BlazePose und Hand Pose. All das läuft ohne Installation auf einer Webseite und mit Webcams, wie sie mittlerweile so ziemlich alle im oder am Rechner haben dürften.

KI-Modell-Entwicklung mit künstlichen Daten

Eine besondere Herausforderung bei der Entwicklung des Tracking-Modells war laut des Tensorflow-Teams die Zusammenstellung der Daten für das KI-Training: Beschriftete 3D-Daten echter menschlicher Bewegungen bräuchten entweder ein Labor oder zumindest spezielle Tiefensensoren für 3D-Scans. Zusätzlicher Aufwand sei es, in diesem Szenario die Vielfalt an Umgebungen und Menschen sicherzustellen.

Stattdessen entschied sich das Team für synthetische Daten, die es mit dem digitalen 3D-Mensch-Modell GHUM generierte. Dafür erweiterte es den schon vorhandenen 2D-Körpertrackingdatensatz mit 3D-Schlüsselpunkten im metrischen Raum und legte die Daten übereinander.

Datensatzbeschrifter zeichneten dann über dickere und dünnere Linien die Tiefenverhältnisse einzelner Gliedmaßen bei bestimmten Posen ein, was die Fehlerquote bei den 3D-GHUM-Rekonstruktionen von 25 auf 3 Prozent reduzierte. Dieses Vorgehen ist laut des Tensorflow-Teams leichter als der Umgang mit realen 3D-Daten.

Eine detaillierte Beschreibung der Tracking-Entwicklung steht im Tensorflow-Blog. Auf der folgenden Webseite könnt ihr eine Tensorflow Tracking-Demo über eure Webcam testen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.