Transfusion: Meta vereint Sprachmodelle und Bildgenerierung in einem KI-System

Mit "Transfusion" stellt Meta AI einen neuen Ansatz vor, der Sprachmodelle und Bildgenerierung in einem einheitlichen KI-System kombiniert. Das Modell erreicht bei der Bildgenerierung ähnliche Ergebnisse wie spezialisierte Systeme und verbessert gleichzeitig die Textverarbeitung.

Forscher von Meta AI haben mit "Transfusion" eine Methode entwickelt, die Sprachmodelle und Bildgenerierung in einem einzigen KI-System vereint. Laut dem Forschungsteam kombiniert Transfusion die Stärken von Sprachmodellen bei der Verarbeitung diskreter Daten wie Text mit den Fähigkeiten von Diffusionsmodellen bei der Erzeugung kontinuierlicher Daten wie Bilder.

Aktuelle Systeme zur Bildgenerierung verwenden oft vortrainierte Textencoder zur Verarbeitung von Eingabeprompts, die dann mit separaten Diffusionsmodellen zur Bilderzeugung kombiniert werden, erklärt Meta. Ähnlich funktionieren viele multimodale Sprachmodelle, die vortrainierte Textmodelle mit spezialisierten Encodern für andere Modalitäten verbinden.

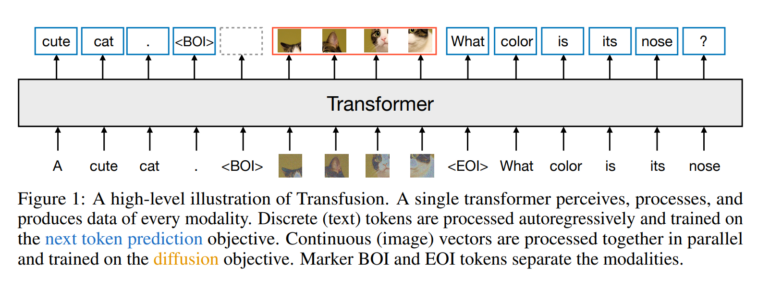

Transfusion hingegen nutzt eine einzige, einheitliche Transformer-Architektur für alle Modalitäten, die end-to-end auf Text- und Bilddaten trainiert wird. Dabei kommen für Text und Bilder unterschiedliche Verlustfunktionen zum Einsatz: die Vorhersage des nächsten Tokens für Text und Diffusion für Bilder.

Um Text und Bilder gemeinsam zu verarbeiten, werden Bilder in Sequenzen von Bildausschnitten (Patches) umgewandelt. Das ermöglicht es dem Modell, sowohl Text-Tokens als auch Bild-Patches in einer einzigen Sequenz zu verarbeiten. Eine spezielle Aufmerksamkeitsmaske erlaubt es dem Modell zudem, Zusammenhänge innerhalb von Bildern zu erfassen.

Dieser integrierte Ansatz unterscheidet sich auch von Methoden wie Metas Chameleon, die Bilder in diskrete Tokens umwandeln und dann wie Text behandeln. Laut dem Forschungsteam behält Transfusion die kontinuierliche Repräsentation von Bildern bei und vermeidet so Informationsverluste durch Quantisierung.

Transfusion erreicht hohe Bild- und Textqualität in ersten Tests

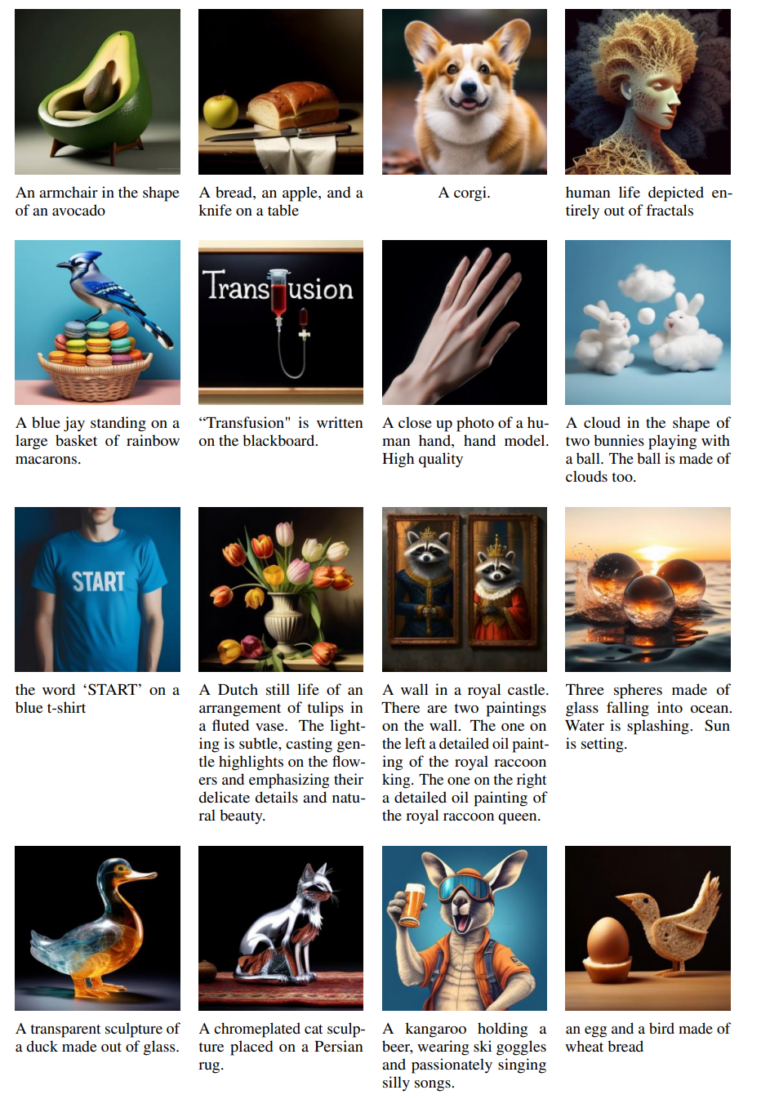

Die Experimente zeigen auch, dass Transfusion effizienter skaliert als vergleichbare Ansätze. Bei der Bildgenerierung erreichte es mit deutlich weniger Rechenaufwand ähnliche Ergebnisse wie spezialisierte Modelle. Überraschenderweise verbesserte die Integration von Bilddaten auch die Textverarbeitungsfähigkeiten.

Die Forschenden trainierten ein 7-Milliarden-Parameter-Modell auf 2 Billionen Text- und Bild-Tokens. Dieses Modell erzielte bei der Bildgenerierung ähnliche Ergebnisse wie etablierte Systeme wie DALL-E 2, konnte aber zusätzlich auch Text verarbeiten.

Die Forscher sehen Potenzial für weitere Verbesserungen, etwa durch die Integration zusätzlicher Modalitäten oder alternative Trainingsmethoden.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.