TransNAR: Deepminds Hybrid-KI schlägt reine Sprachmodelle bei Schlussfolgerungen

Forschende von Google DeepMind haben eine hybride KI-Architektur entwickelt, die Transformer mit Netzwerken kombiniert, die auf logische Schlussfolgerungen spezialisiert sind. Das Ergebnis ist ein Sprachmodell, das auch bei komplexen Aufgaben gut verallgemeinert.

Ein Team von Google DeepMind hat eine neue KI-Architektur namens TransNAR entwickelt. Sie kombiniert die Stärken zweier unterschiedlicher KI-Ansätze: die Sprachverarbeitungsfähigkeiten von Transformer-Sprachmodellen und die Robustheit spezialisierter KI-Systeme für algorithmisches Schlussfolgern, sogenannter Neural Algorithmic Reasoners (NARs).

Ziel war es, die Schwächen der einzelnen Ansätze auszugleichen. Transformer-Sprachmodelle wie GPT-4 sind sehr gut darin, natürliche Sprache zu verarbeiten und zu generieren. Sie versagen aber oft ohne externe Werkzeuge bei Aufgaben, die präzise algorithmische Berechnungen erfordern.

Genau darin sind NARs wiederum sehr gut. Diese auf Graph Neural Networks (GNNs) basierenden KI-Systeme können komplexe Algorithmen robust ausführen, wenn die Aufgaben in Graphenform vorliegen. Dazu benötigen sie jedoch eine starre Strukturierung der Eingabedaten und können nicht direkt auf unstrukturierte Probleme in natürlicher Sprache angewendet werden.

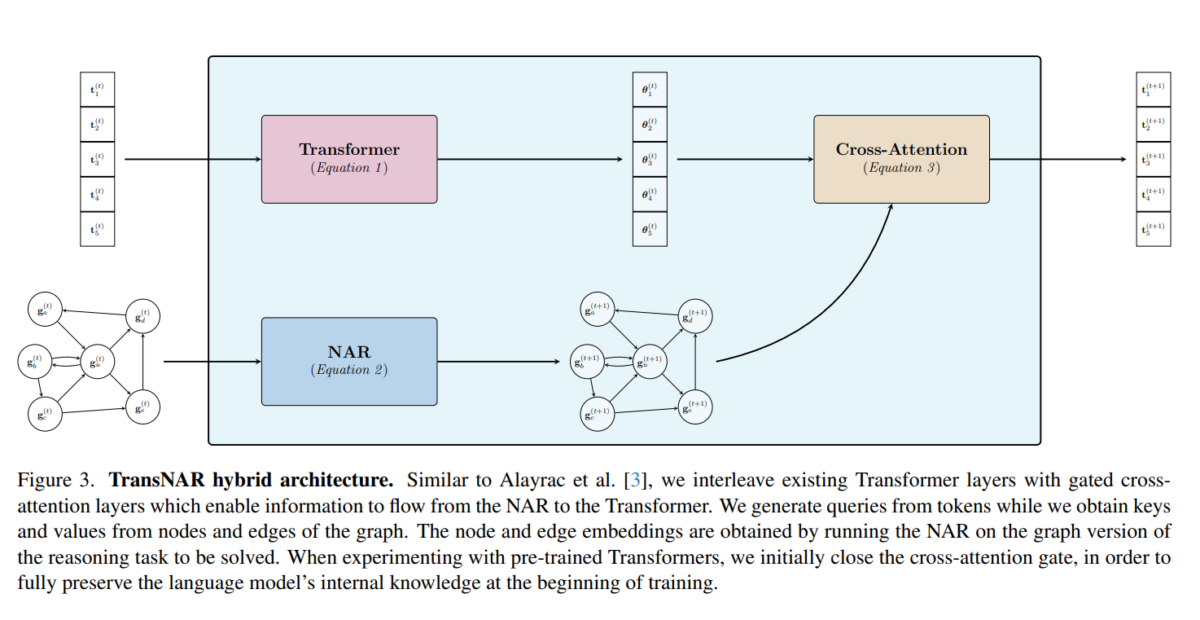

Die Forschenden von DeepMind haben nun beide Ansätze kombiniert: Ein Transformer-Sprachmodell verarbeitet den Text der Aufgabenstellung, während ein NAR die zugehörige Graphenrepräsentation verarbeitet. Über neuronale Aufmerksamkeitsmechanismen tauschen die beiden Modelle Informationen aus - das NAR kann also auch als eine Art "internes Werkzeug" verstanden werden: Die Kommunikation erfolgt nicht über eine API, sondern innerhalb der Embeddings.

Durch die hybride Architektur kann das Sprachmodell auf die robusten Berechnungen des NAR zugreifen und das System kann Algorithmen auf Basis einer natürlichsprachlichen Beschreibung auszuführen.

TransNAR schlägt reine Transformer teilweise mit großem Abstand

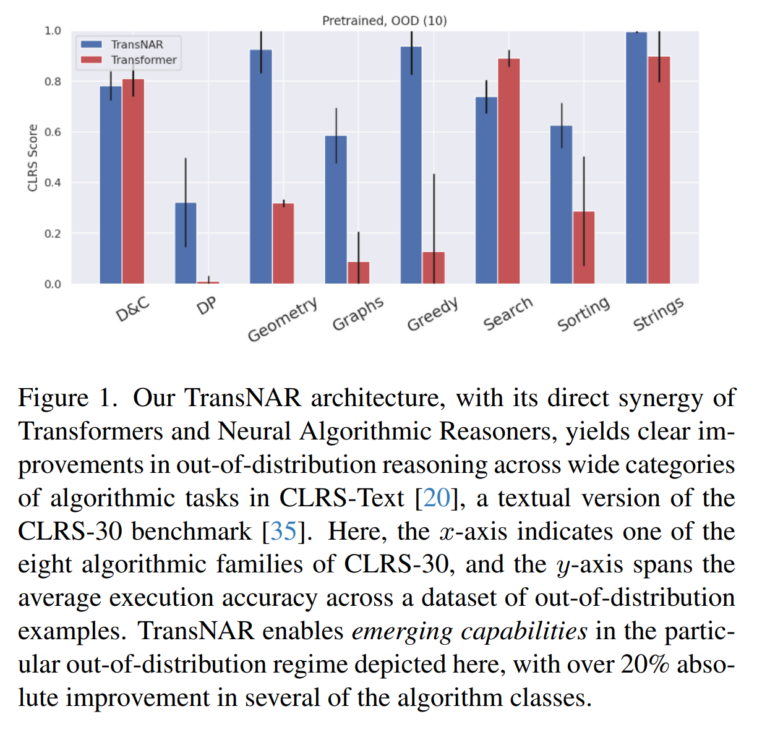

Die Forschenden testeten ihr TransNAR-Modell auf dem CLRS-Datensatz. Dieser enthält Beschreibungen von 30 verschiedenen Algorithmen aus der Informatik, wie z.B. binäre Suche oder Sortierverfahren.

Dabei zeigte sich, dass TransNAR insbesondere dann deutlich besser abschneidet als ein reines Transformer-Modell, wenn die Testdaten von den Trainingsdaten abweichen, das System also generalisieren muss. In mehreren Algorithmenklassen erzielte TransNAR eine um mehr als 20 Prozent höhere Genauigkeit.

Die Ergebnisse zeigen, so das Team, dass durch die Kombination komplementärer KI-Ansätze die Fähigkeit von Sprachmodellen, algorithmische Schlussfolgerungen zu ziehen, deutlich verbessert werden kann.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.