Viel Leistung für "wenig" Geld: Open-Sora 2.0 könnte ein Deepseek-Moment für Video-KI sein

Das Start-up HPC-AI Tech hat ein KI-System entwickelt, das qualitativ hochwertige Videos bei deutlich niedrigeren Trainingskosten erzeugen kann als aktuelle Alternativen.

Während Sprachmodelle bereits immer effizienter werden, beanspruchen Videomodelle weiterhin immense GPU-Ressourcen für ihr Training. Open-Sora 2.0 geht einen Kompromiss bei der Auflösung der generierten Clips ein, senkt die Kosten für das Training dadurch aber signifikant. Weitere Beispiele finden sich auf einer Projektseite.

Prompt: "Two women sit on a beige couch in a cozy, warmly lit room with a brick wall backdrop. They engage in a cheerful conversation, smiling and toasting red wine in an intimate medium shot." | Video: HPC-AI Tech

Prompt: "A group of anthropomorphic mushrooms having a disco party in the middle of a dark enchanted forest, with glowing neon lights and exaggerated dance moves, their smooth textures and reflective surfaces emphasizing a comical 3D look." | Video: HPC-AI Tech

Prompt: "A tomato surfing on a piece of lettuce down a waterfall of ranch dressing, with exaggerated surfing moves and creamy wave effects to highlight the 3D animated fun." | Video: HPC-AI Tech

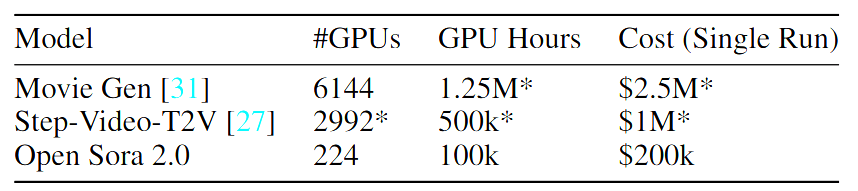

Mit rund 200.000 US-Dollar benötigte Open-Sora 2.0 laut Paper nur etwa ein Zehntel der geschätzten Kosten vergleichbarer Systeme wie Movie Gen oder Step-Video-T2V. In Tests erreicht das Modell eine ähnliche Qualität wie etablierte, kommerzielle Systeme wie Runway Gen-3 Alpha oder HunyuanVideo. Zum Training verwendete HPC-AI Tech nach eigenen Angaben 224 Einheiten von Nvidias H200-GPUs.

Komprimierte Videos in deutlich weniger Zeit

Die geringe Kostenbasis basiert auf einem dreistufigen Trainingsverfahren: Zunächst lernt das System mit niedrig aufgelösten Videos, dann folgt die Spezialisierung auf Bild-zu-Video-Konvertierung. In der letzten Phase erfolgt eine Feinabstimmung für hochauflösende Ausgaben. Durch die Nutzung vortrainierter Bildmodelle wie Flux sparten die Entwickler:innen zusätzlich Rechenressourcen.

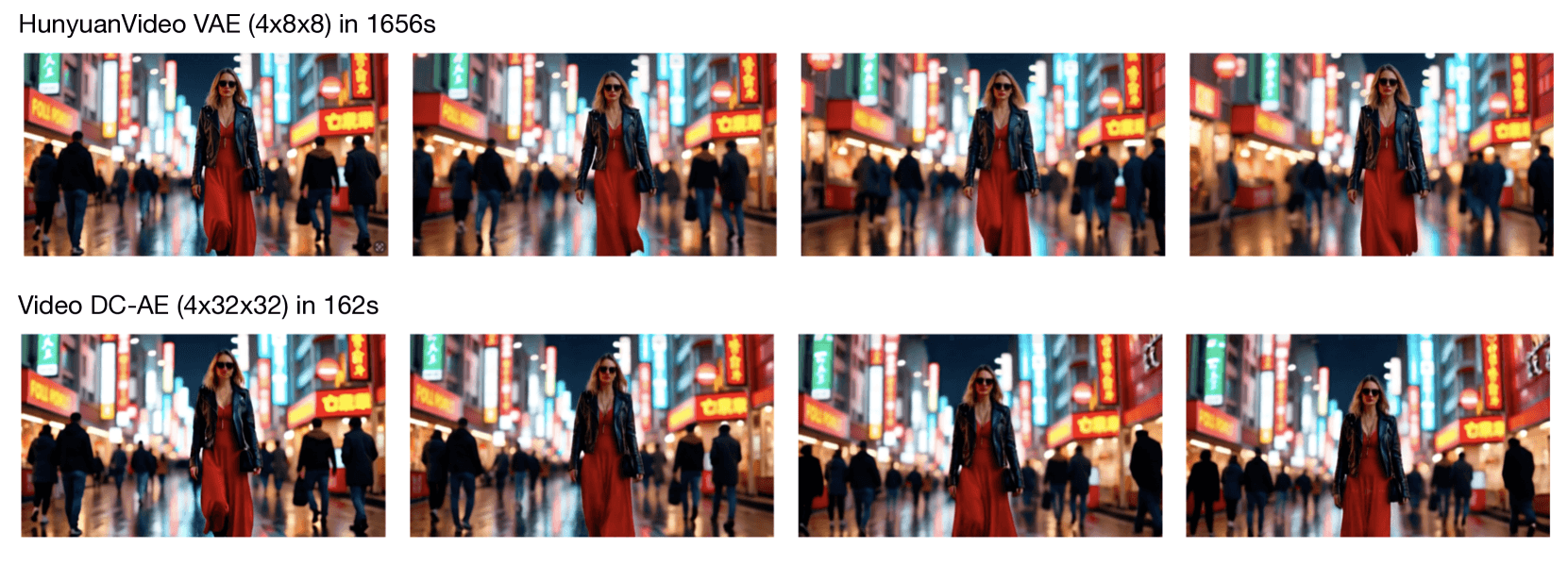

Eine wichtige technische Komponente ist der neue Video DC-AE Autoencoder zur Videokomprimierung. Das System erreicht höhere Kompressionsraten als bisherige Methoden und beschleunigt dadurch das Training um das 5,2-fache. Die Inferenzgeschwindigkeit verbessert sich den Forschenden zufolge um mehr als das Zehnfache.

Flexible Steuerung der Videogenerierung

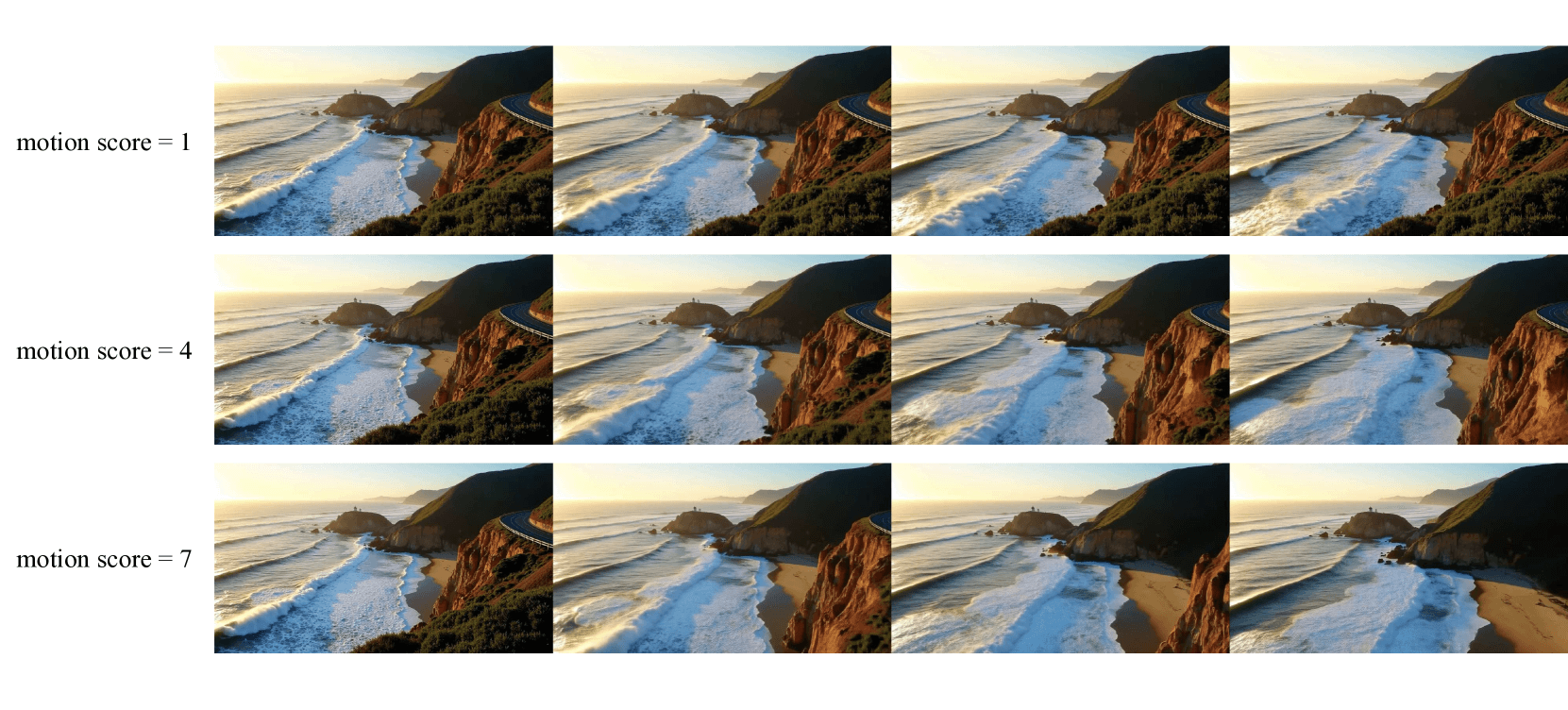

Open-Sora 2.0 unterstützt die Generierung von Videos sowohl aus Textbeschreibungen als auch aus Einzelbildern. Ein spezieller Motion Score erlaubt in Open-Sora außerdem die gezielte Steuerung der Bewegungsintensität in den generierten Videos.

Die höchste Auflösung ist mit 768x768 Pixeln jedoch eher niedrig und die maximale Länge von bis zu 128 Frames oder fünf Sekunden recht kurz. OpenAIs Sora, zu dem Open-Sora nur namentliche Ähnlichkeit aufweist, kann 20-sekündige Videos mit bis zu 1080p-Auflösung generieren.

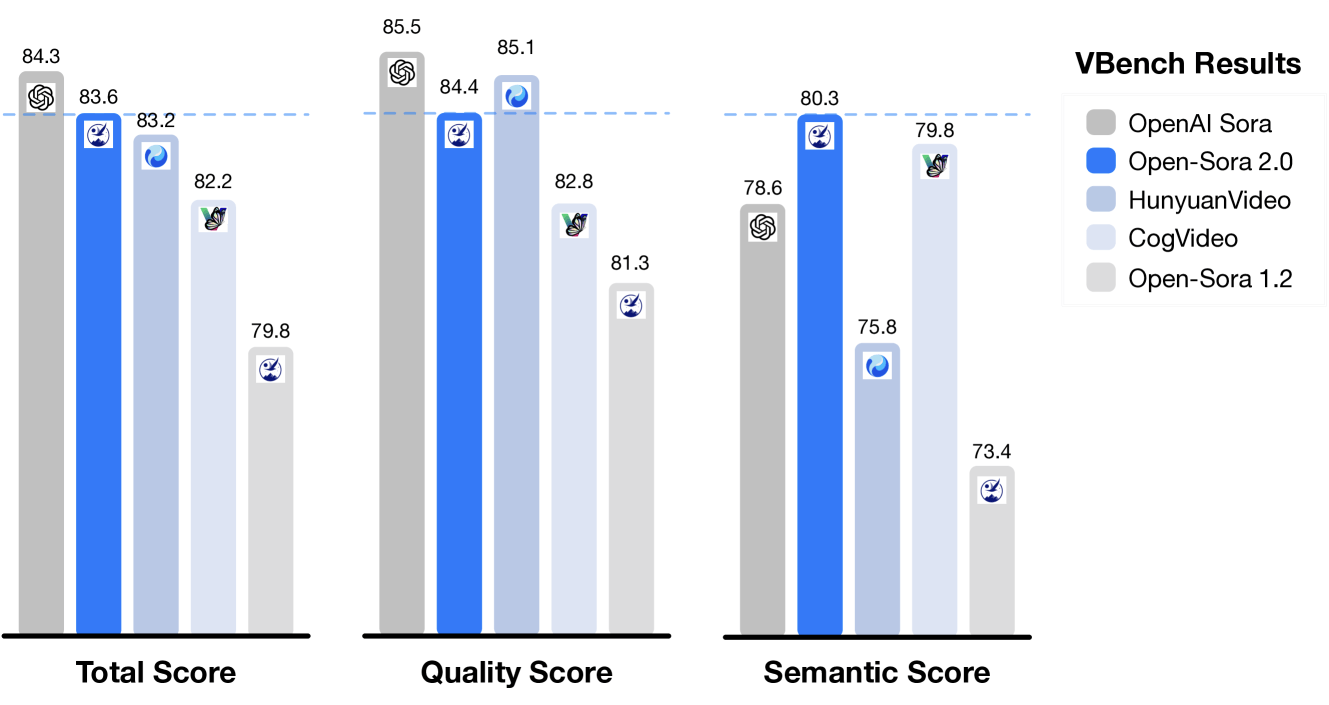

Benchmarks untersuchten drei Aspekte: die visuelle Qualität, die Übereinstimmung mit dem Textprompt und die Bewegungsqualität. In allen Bereichen erreicht das System Werte auf dem Niveau führender kommerzieller Modelle.

Im VBench-Test liegt Open-Sora 2.0 nur noch 0,69 Prozent hinter OpenAIs Sora - eine deutliche Verbesserung gegenüber der Vorgängerversion mit 4,52 Prozent Rückstand. Wie immer gilt natürlich, dass Benchmarkleistung und reale Performance nicht immer oder nur eingeschränkt übereinstimmen.

Open-Sora 2.0 zeigt deutlich bessere Leistung als dessen Vorgänger und verkleinert die Lücke zu kommerziellen Systemen. | Bild: HPC-AI TechHPC-AI Tech hat das System auf GitHub als Open Source verfügbar gemacht. Allerdings bestehen weiterhin technische Herausforderungen: Die generierten Videos zeigen gelegentlich unerwünschte Artefakte, zudem entsprechen die Bewegungen nicht immer den physikalischen Gesetzen. Auch andere KI-Videomodelle haben diese Probleme.

Ist das der "Deepseek"-Moment für Video-KI?

Fast wöchentlich erscheinen derzeit maßgeblich von chinesischen Unternehmen neue, teilweise ebenfalls quelloffene KI-Modelle zur Videogenerierung wie Genmo Mochi 1 oder MiniMax Video-01, die in Benchmarks bestehende Lösungen zwar immer wieder um ein paar Prozentpunkte übertreffen, aber keine völlig neuen Maßstäbe in puncto Videoqualität setzen.

Open-Sora 2.0 scheint nun jedoch Parallelen zum "Deepseek-Moment" der Sprachmodelle aufzuweisen: Das System kann ähnliche Leistungen wie kommerzielle Anbieter erbringen, aber durch intelligente Trainingsmethoden die Kosten deutlich senken.

Das könnte auf lange Sicht auch im Videobereich zu stärkeren Preiskämpfen führen. Bislang ist die Nutzung etwa von Googles neustem Video-Modell per API aufgrund des großen Bedarfs an Rechenressourcen noch mit Kosten von 0,50 cent pro Sekunde verbunden.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.