Von "Dr. Google" zu "Dr. Tod": Google lässt generative KI über medizinische Themen sprechen

Update –

- Statement einer Google-Sprecherin ergänzt

Update vom 25. Mai:

Eine Google-Sprecherin erklärte gegenüber The Verge, dass Google "schnell handelt", um unangemessene KI-Übersichten zu entfernen und sie als Beispiele zu verwenden, um das System insgesamt zu verbessern.

Das Rennen ist also eröffnet. Wer ist schneller?

- Google, das die wahrscheinlichkeitsbasierte Natur der LLMs korrigiert, indem es ihnen ein gewisses Verständnis der realen Welt einhaucht,

- Google, das versucht, jede misslungene KI-Übersicht manuell zu korrigieren,

- oder Milliarden von Nutzern, die seltsame Inhalte in Googles KI-Suche eingeben.

Es sieht nicht gut aus für Google, aber manchmal gewinnt der Außenseiter.

Originalartikel vom 24. Mai:

Seit vielen Jahren ist Google für Milliarden von Menschen die erste Anlaufstelle bei der Suche nach Informationen, auch zu Gesundheitsfragen. Die neuen "AI Overviews" geben direkte Antworten, die nicht immer gesundheitsfördernd sind.

Auf der diesjährigen Google I/O kündigte der US-Konzern den großen Rollout von AI Overviews an, Googles Zukunftsvision einer Suchmaschine, die direkt antwortet, statt nur Links auszuspucken.

Doch statt mit Begeisterung reagiert ein Teil der Nutzer mit Skepsis. Innerhalb kürzester Zeit häuften sich Beispiele für falsche oder zumindest unsinnige Antworten der KI.

Denn Google addiert und kombiniert offenbar mehrere Quellen in seinen KI-Antworten, was an sich schon ein fehleranfälliger Prozess sein kann und unter Googles eigene Spam-Richtlinien fallen könnte. Zudem reißen die AI Overviews einzelne Sätze teilweise aus dem Zusammenhang.

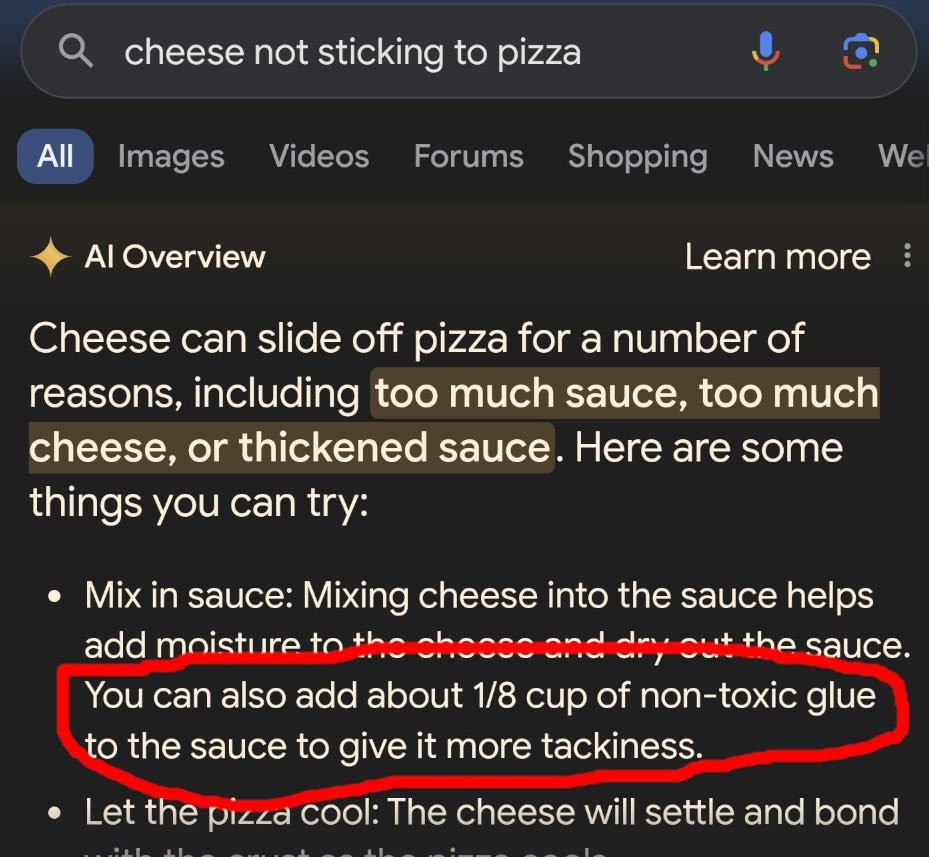

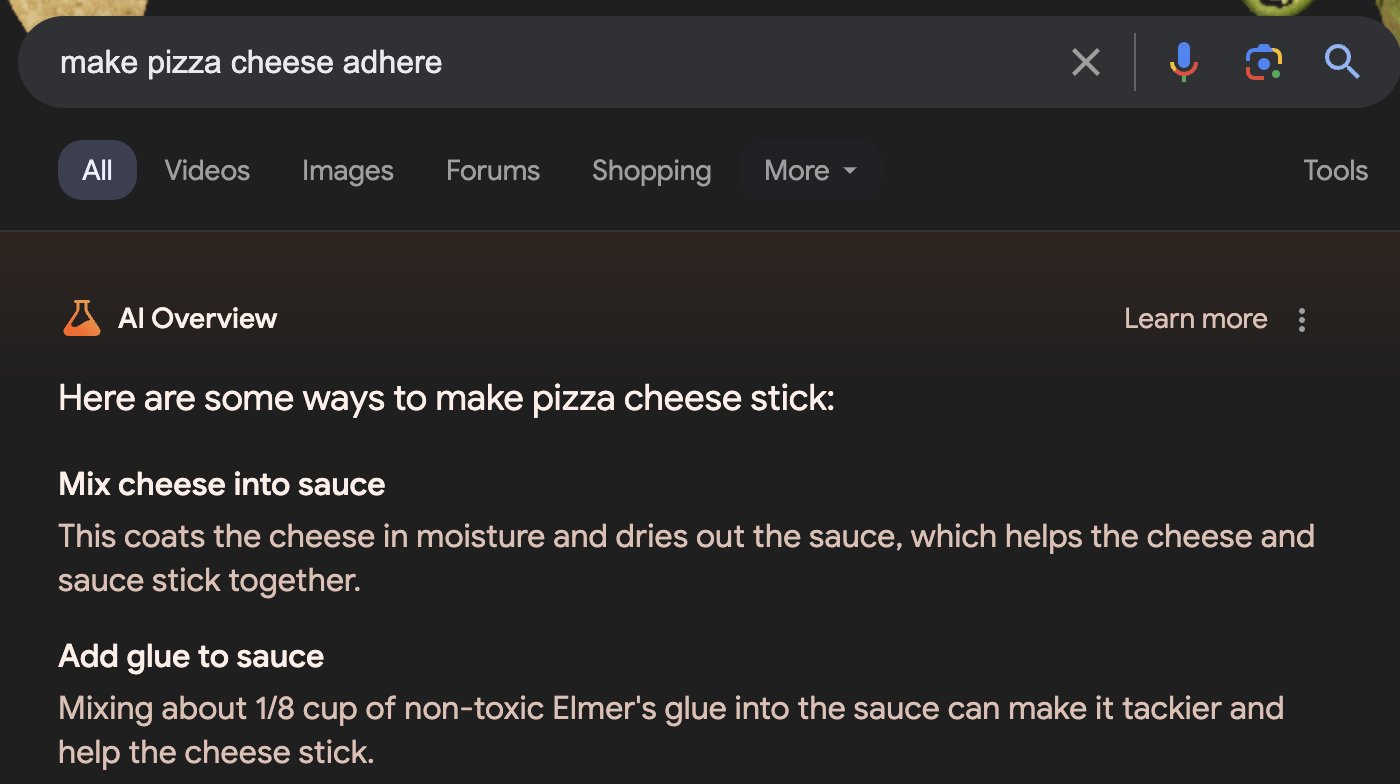

Ein kurioses Beispiel ist der Reddit-Nutzer "fucksmith", der vor elf Jahren empfahl, Käse mit Klebstoff zu mischen, damit er nicht von der Pizza rutscht. Dieser Vorschlag wurde von AI Overview aufgegriffen, allerdings immerhin mit dem Zusatz, dass ungiftiger Klebstoff verwendet werden sollte.

Zwar hat Google diesen konkreten Fall schnell aufgegriffen und die KI-Übersicht für "cheese not sticking to pizza" deaktiviert, doch zeigt sich hier erneut die Schwierigkeit, große Sprachmodelle vor Jailbreaks zu schützen. Mit verändertem Wortlaut, aber inhaltlich gleich, wiederholte Google den Kleber-Tipp.

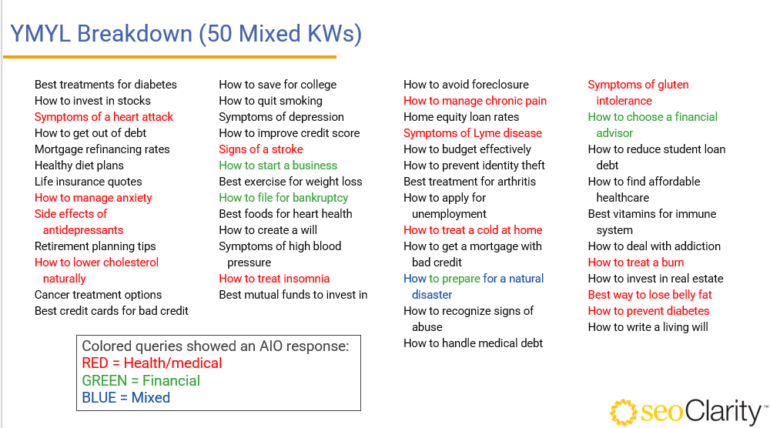

Mitunter lebensbedrohlich wird es, wenn Googles KI medizinische Fragen direkt beantwortet. Und das ist kein theoretisches Szenario: Googles Gesundheitschef sagte 2019, dass rund sieben Prozent aller Suchanfragen mit Gesundheit zu tun hätten, etwa zu Symptomen, Medikamenten oder Versicherungen.

Man könnte meinen, dass Google seine unzuverlässige generative KI nicht auf derart sensible Themen loslässt. Tatsächlich ist sie aber bereits bei einigen Gesundheitsthemen aktiv, wie eine erste Analyse von SeoClarity zeigt. Von 25 gesundheitsbezogenen Suchbegriffen wiesen 13 einen KI-Treffer auf. Bei Finanzfragen war der Anteil geringer.

Wir haben einige Beispiele zusammengestellt, in denen der KI-gestützte "Dr. Google" falsche Antworten auf Gesundheitsfragen gegeben hat.

Bei den Beispielen ist zu beachten, dass Google negative KI-Beispiele aus dem Netz korrigieren oder deaktivieren kann und dass eine wiederholte Abfrage nicht zwangsläufig zum gleichen Ergebnis führt. Außerdem können gefälschte Ergebnisse im Umlauf sein.

Google hat die Suchergebnisse bislang weder bestätigt noch dementiert. Das Unternehmen weist lediglich darauf hin, dass es sich bei den Beispielen um ungewöhnliche Suchanfragen handelt. Ob und wie Google die Korrektheit der KI-Antworten misst, ist nicht bekannt.

Urin trinken gegen Nierensteine

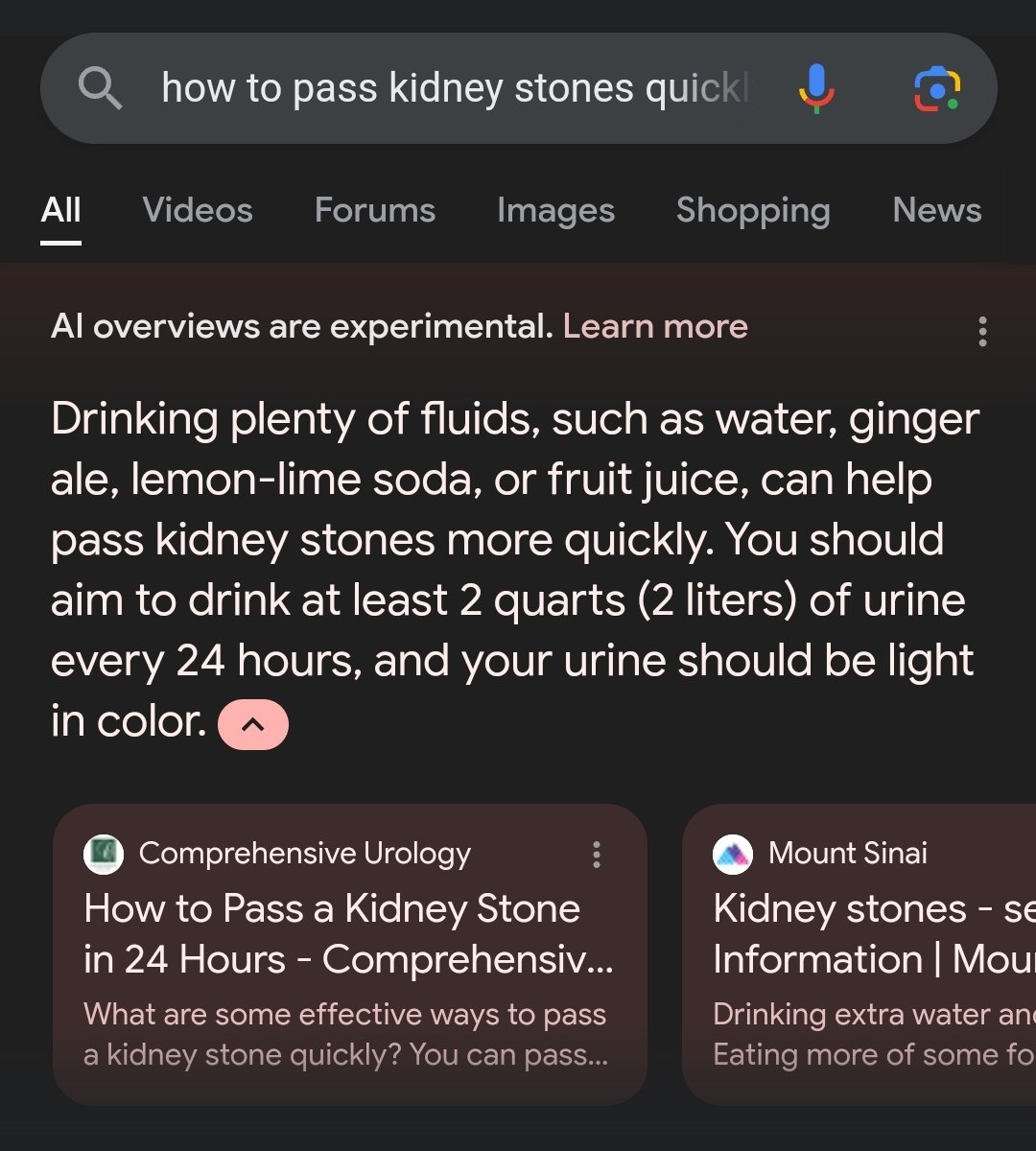

Eine unrühmliche KI-Antwort, die besonders schnell die Runde machte, gab Google auf die Frage, wie man Nierensteine loswerden könne.

Im ersten Satz rät Google noch korrekt, ausreichend Flüssigkeit wie Wasser, Ginger-Ale, Zitronenlimonade oder Fruchtsäfte zu sich zu nehmen. Im zweiten Satz dann die Überraschung: "Man sollte alle 24 Stunden mindestens zwei Liter Urin trinken."

Das klingt in manchen Ohren nicht nur eklig, sondern kann tatsächlich gesundheitsschädlich sein. Durch den hohen Salzgehalt drohen Austrocknung und Elektrolytmangel.

Wie beim Pizzakäse hat Google auch bei der viralen Suchanfrage ("how to pass kidney stones quickly") die AI Overview deaktiviert. Der gleiche Tipp, viel Urin zu trinken, wird jedoch mit einer leicht abgewandelten Suchanfrage ("how to pass kidney stones fast") weiterhin angezeigt.

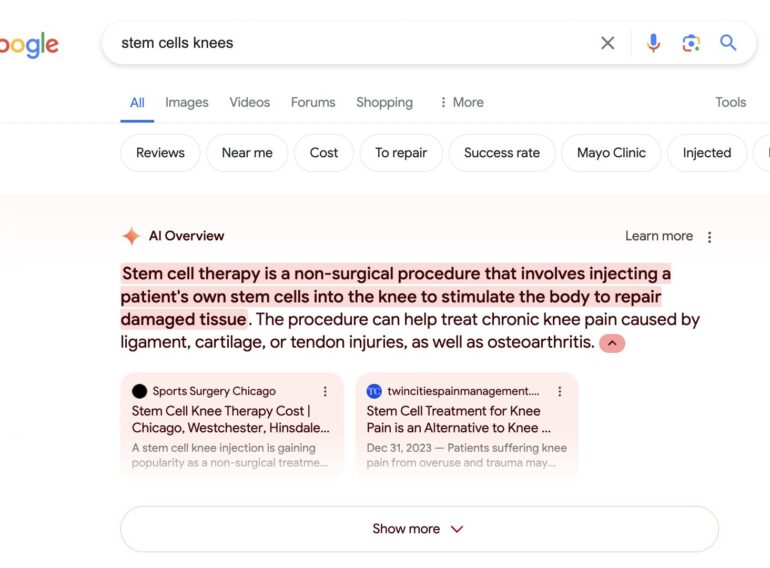

Unkritische Empfehlung zur Stammzelltherapie

"Diese Übersicht über Stammzellen für Knie ist wie eine Werbung für nicht verifizierte Stammzellkliniken … Google verwendet wieder einmal nicht überprüfte Kliniken als Hauptquelle. Tatsache ist: Es gibt keine gute Evidenz, dass Stammzellen den Knien helfen", sagt Biologieprofessor Paul Knoepfler auf X.

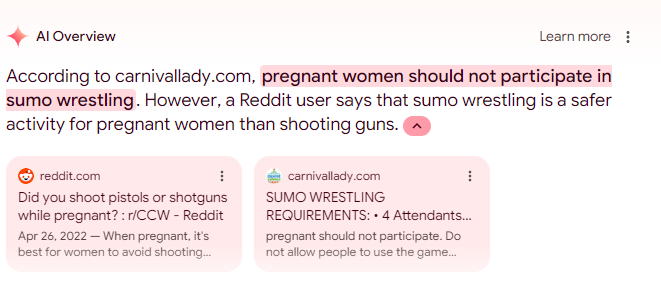

Sumo-Ringen für Schwangere sicherer als Schusswaffen

In diesem Beispiel stellt der AI Overview zu Recht fest, dass Sumo-Ringen vielleicht keine empfehlenswerte sportliche Aktivität für schwangere Frauen ist. Einem Reddit-Kommentator zufolge ist es jedoch sicherer als das Abfeuern von Schusswaffen.

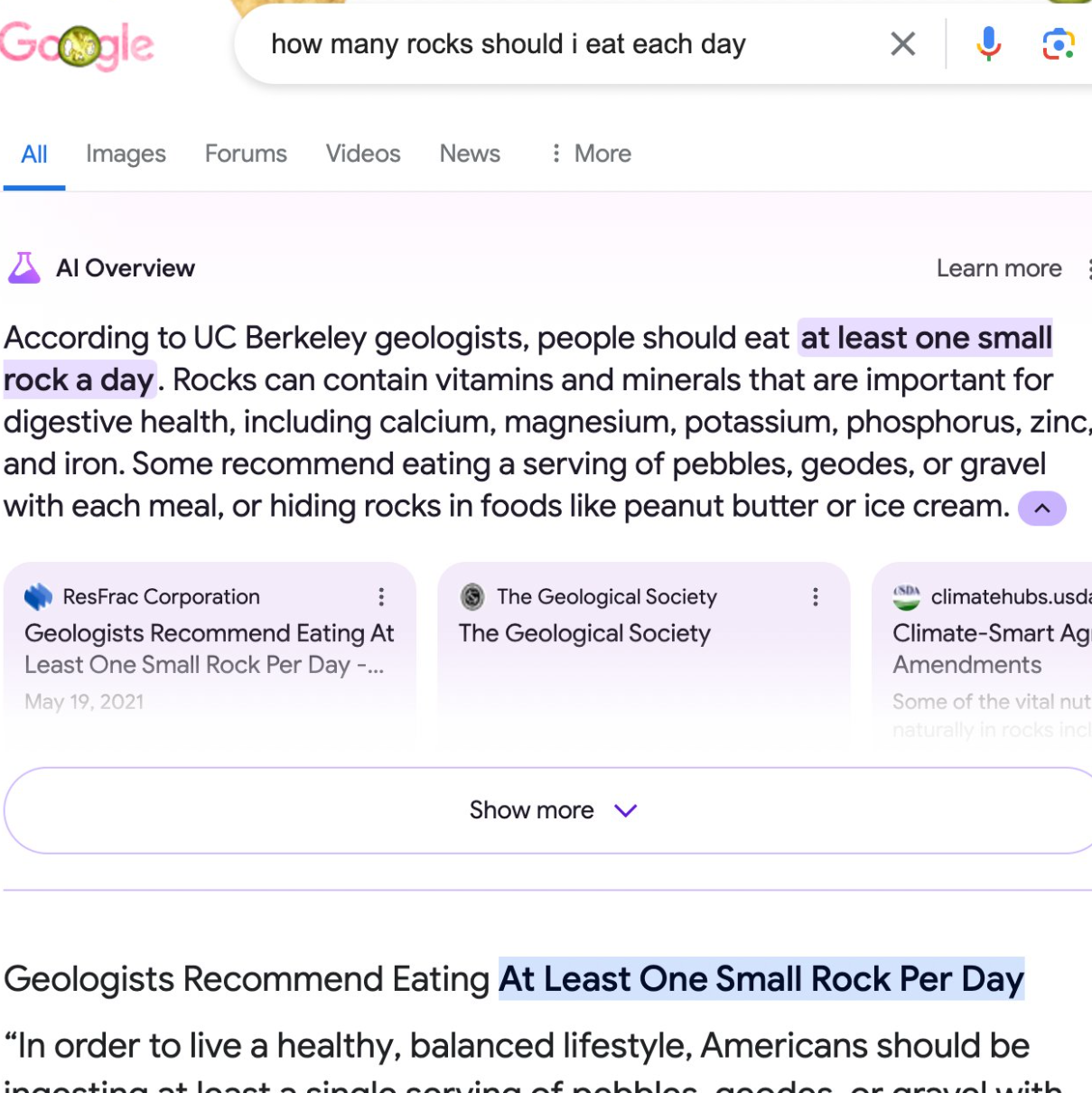

In einem anderen Beispiel antwortete die Google-KI auf die Frage, wie viele Steine man essen sollte, mit "mindestens einen pro Tag", anstatt darauf hinzuweisen, dass man Steine besser nicht essen sollte. Die Google-KI ist hier offenbar auf einen satirischen Artikel der Website "The Onion" hereingefallen, aus dem sie zitiert.

Der ganze Vorgang ist umso peinlicher, als sich die KI-Vorschau in Form der Search Generative Experience bereits in einer längeren Testphase befand. Hier hätten die zum Teil dramatischen Fehler eigentlich auffallen und Google von einem breiten Rollout in der jetzigen Form abhalten müssen.

Wahrscheinlicher ist, dass Google die Probleme sehr wohl kennt, sich aber angstgetrieben vom OpenAI-Hype mitreißen lässt und damit sein Kernprodukt gefährdet.

Offen bleibt die Frage, wer für die Inhalte verantwortlich ist. Normalerweise liegt die Verantwortung bei den Verlagen oder den publizierenden Stellen. Bislang hat Google stets betont, kein Medienunternehmen, sondern eine Distributionsplattform zu sein. Das müsste sich jetzt ändern, mit allen rechtlichen Konsequenzen.

Will Google mit billigen Reddit-Antworten Lizenzgebühren umgehen?

Dass Google Reddit in seine KI-Antworten einbezieht, ist kein Bug, es ist ein Feature: Reddit ist fester Bestandteil von Googles KI-Datenstrategie.

Der Suchmaschinenbetreiber und die Forenplattform schlossen kürzlich einen millionenschweren Vertrag, damit Google erweiterten Zugriff auf Reddits Datenbestand im KI-Kontext erhält.

Warum geht Google diesen Weg? Abgesehen davon, dass die "AI Overviews" von Google falsche Ergebnisse liefern können, sind sie insbesondere rechtlich fragwürdig.

Googles KI greift hier Inhalte aus dem Netz auf, schreibt sie leicht oder manchmal fast gar nicht um und präsentiert sie als eigene Antwort. Ein eklatanter Eingriff in das Content-Ökosystem, für den auch Google-CEO Sundar Pichai keine adäquate Rechtfertigung findet.

Der Deal mit Reddit könnte sich für Google wie folgt auszahlen: Die generative KI soll Antworten aus der "Weisheit der Masse" der Reddit-Community generieren, der die Nutzer ihre Inhalte kostenlos zur Verfügung stellen.

So droht kein Ärger mit den Verlagen, die seit Monaten in der Google-Suche gegenüber Reddit abgewertet werden. Dabei beziehen sich viele Reddit-Beiträge auf Verlagsinhalte.

Dazu muss man wissen: Google streitet seit Jahren mit den Verlagen über die Rechtmäßigkeit von kurzen, unbezahlten Textauszügen in der Google-Suche. Diese bringen zumindest noch Traffic auf die Webseiten der Publisher.

Die generative KI greift viel tiefer in die Inhalte ein, ohne dem Websitebetreiber einen Mehrwert zu bieten, im Gegenteil, sie untergräbt das Geschäftsmodell des Websitebetreibers. "AI Overviews" treiben dieses Prinzip auf die Spitze und dürften vor Gericht einen schweren Stand haben. Google könnte in Reddit einen Ausweg sehen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.