Warum uns KI-Systeme kognitiv überfordern - und wie sich das ändern lässt

Eine neue Studie von Microsoft Research zeigt: Generative KI stellt hohe Anforderungen an unsere Metakognition - also die Fähigkeit, die eigenen Gedanken zu überwachen und zu steuern. Die Forscher schlagen konkrete Verbesserungen vor.

Die professionelle und systematische Nutzung von generativen KI-Systemen überfordert viele Menschen kognitiv. Das liegt laut einer neuen Studie von Microsoft Research nicht nur an der Komplexität der Systeme selbst, sondern vor allem an den hohen Anforderungen an unsere Metakognition.

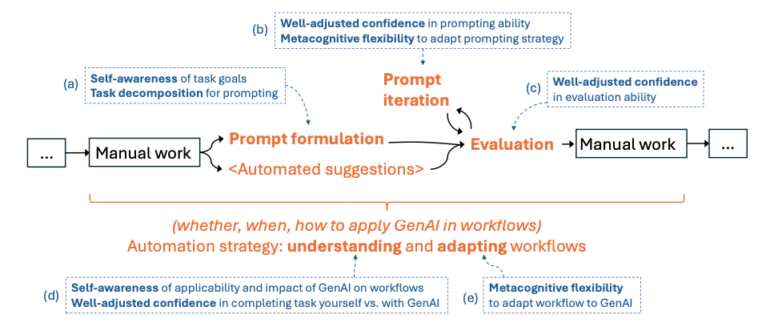

"Die metakognitiven Anforderungen bei der Arbeit mit GenAI-Systemen ähneln denen eines Managers, der Aufgaben an ein Team delegiert", schreiben die Forscher in ihrer Studie. "Ein Manager muss seine Ziele klar verstehen und formulieren, sie in kommunizierbare Aufgaben herunterbrechen, die Qualität der Team-Outputs selbstbewusst bewerten und Pläne entsprechend anpassen."

Genau diese Fähigkeiten werden auch im Umgang mit KI-Systemen gefordert - und das in drei Hauptbereichen:

Die drei großen Herausforderungen

Erstens beim "Prompting", also der Formulierung von Anweisungen an die KI. Hier müssen Nutzer ihre Ziele klar erkennen und in Teilaufgaben zerlegen können. Was beim manuellen Arbeiten oft implizit bleibt - etwa der gewünschte Ton einer E-Mail - muss der KI explizit mitgeteilt werden. Das zeigt sich klar in der systematischen Arbeit mit generativen Modellen, abseits des Chat-Prinzips. Hier müssen einzelnen Arbeitsschritte erst einmal gedanklich durchdacht, in Sequenz gebracht und als Anweisung für das Modell übersetzt werden.

Zweitens bei der Evaluation der KI-Outputs. Anders als bei Suchmaschinen sind die Antworten von GenAI nicht deterministisch, sondern können bei gleicher Anfrage unterschiedlich ausfallen. Das erfordert ein "angemessenes Vertrauen" in die eigene Bewertungsfähigkeit. Hier zeigt sich in anderen Studien ebenfalls, wer über viel Sachverständnis über die eigene Wissensdomäne verfügt, kann den KI-Output einfacher, besser und schneller auf Qualität bewerten.

Drittens bei der grundsätzlichen Entscheidung, ob und wie Aufgaben automatisiert werden sollen. Dies verlangt Selbstwahrnehmung bzw. ein Verständnis bezüglich der Eignung von KI für den eigenen Workflow sowie die Flexibilität, Arbeitsabläufe anzupassen.

Konkrete Verbesserungsvorschläge

Die Forscher schlagen verschiedene Strategien vor, wie Menschen ihre Interaktion mit KI-Systemen verbessern können:

- Bessere Planung durch "Think Aloud": Nutzer sollten ihre Gedanken während der KI-Nutzung laut aussprechen oder aufschreiben. Diese Verbalisierung hilft dabei, die eigenen Ziele klarer zu erkennen und Aufgaben systematischer in Teilschritte zu zerlegen.

- Aktive Selbstevaluierung: Die Forscher empfehlen, sich nach jeder KI-Interaktion kurz Zeit für Reflexion zu nehmen. Hilfreiche Fragen sind dabei:

- War meine Anweisung an die KI präzise genug?

- Wie viel Zeit habe ich mit dem Überarbeiten des KI-Outputs verbracht?

- Wäre eine andere Herangehensweise effizienter gewesen?

- Strategisches Selbstmanagement: Nutzer sollten bewusst verschiedene Arbeitsmodi definieren:

- Einen "Denk-Modus" für die sorgfältige Planung von Prompts

- Einen "Reflexions-Modus" zum Überdenken von Entscheidungen

- Einen "Explorations-Modus" zum kreativen Experimentieren mit der KI

"GenAI-Systeme haben durch ihre Flexibilität und Generalität das Potenzial, diese Art der Selbstevaluierung in Schlüsselmomenten adaptiv anzustoßen und effektiv als Coach oder Guide für Nutzer zu fungieren", schreiben die Forscher.

Wichtig sei dabei, dass diese Strategien nicht als zusätzliche Belastung empfunden werden. Sie sollten schrittweise in den eigenen Workflow integriert und mit zunehmender Erfahrung angepasst werden. Auch müsse jeder Nutzer für sich herausfinden, welche Methoden in seinem spezifischen Kontext am besten funktionieren.

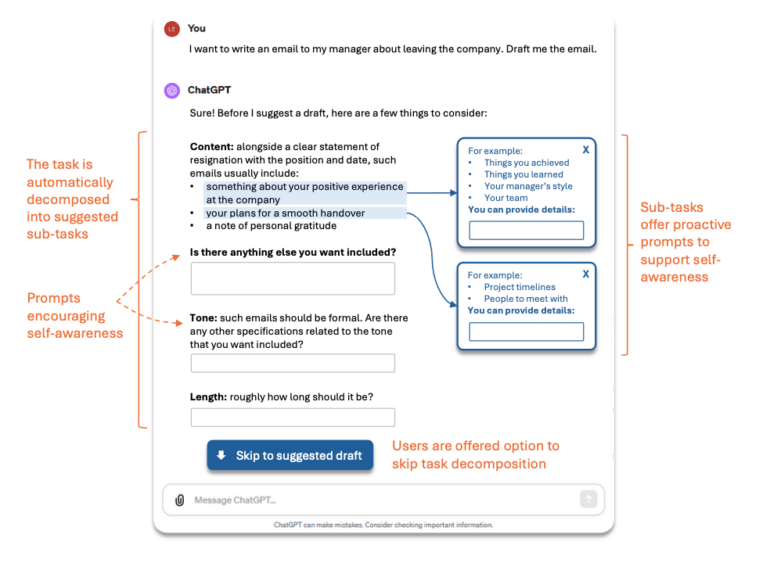

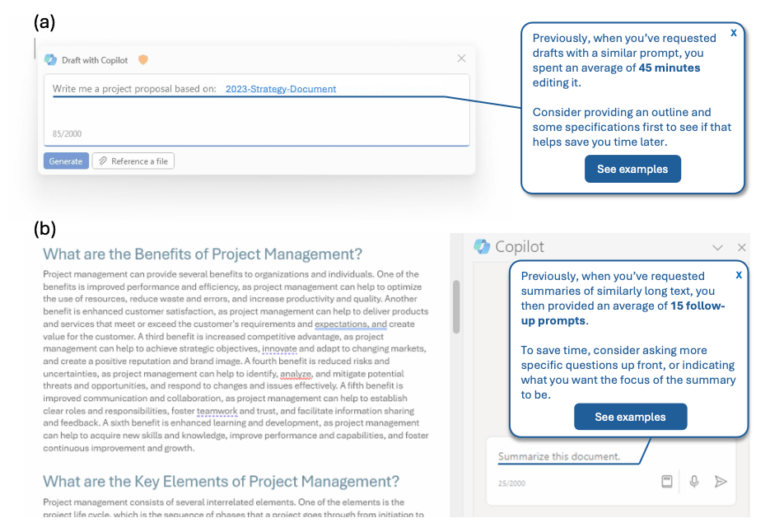

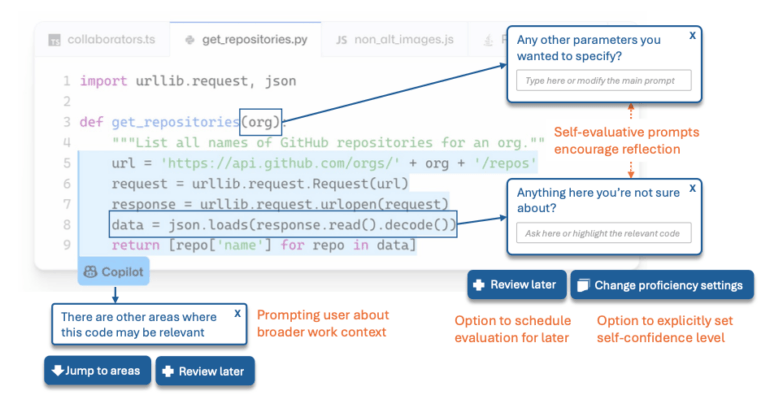

Die Autoren schlagen verschiedene Ansätze für ein interaktiveres Design von Chat-Oberflächen vor, um die metakognitiven Aufwände für Nutzende zu reduzieren:

Aktuelle Nutzungsprobleme

Dass Verbesserungen nötig sind, zeigten aktuelle Nutzungsdaten: 26 Prozent der befragten Programmierer vermeiden Tools wie GitHub Copilot wegen störender KI-Vorschläge, 38 Prozent wegen des zeitaufwändigen Debuggings von generiertem Code. Nur 20 bis 30 Prozent der Copilot-Vorschläge werden überhaupt von Nutzern akzeptiert.

Die Implementierung der vorgeschlagenen Verbesserungen muss dabei verschiedene Aspekte berücksichtigen: Die Interventionen sollten an Expertise und Workflow angepasst sein, die Unterstützung sollte mit zunehmender Erfahrung graduell reduziert werden, und es muss eine Balance zwischen Unterstützung und kognitiver Belastung gefunden werden.

Herausforderung im Umgang mit generativer KI

Das intensive Planen, Vorbereiten und Segmentieren von Aufgaben vor der Übergabe an generative KI-Systeme ist eine völlig neue Art zu arbeiten für die meisten Menschen. Sich genau zu überlegen, an welcher Stelle, in welchem Umfang und mit welcher Qualität systematische Prompts zu Ergebnissen führen, ist nicht einfach und verlangt Anleitung und Training. Aus der eigenen Erfahrung kann ich berichten: Wer die anfängliche mentale Hürde im professionellen Umgang mit generativer KI nimmt, erschließt sich eine neue Welt des Tandem-Arbeitens.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.