Eine neue Webseite macht KI-Trainingsbilder durchsuchbar

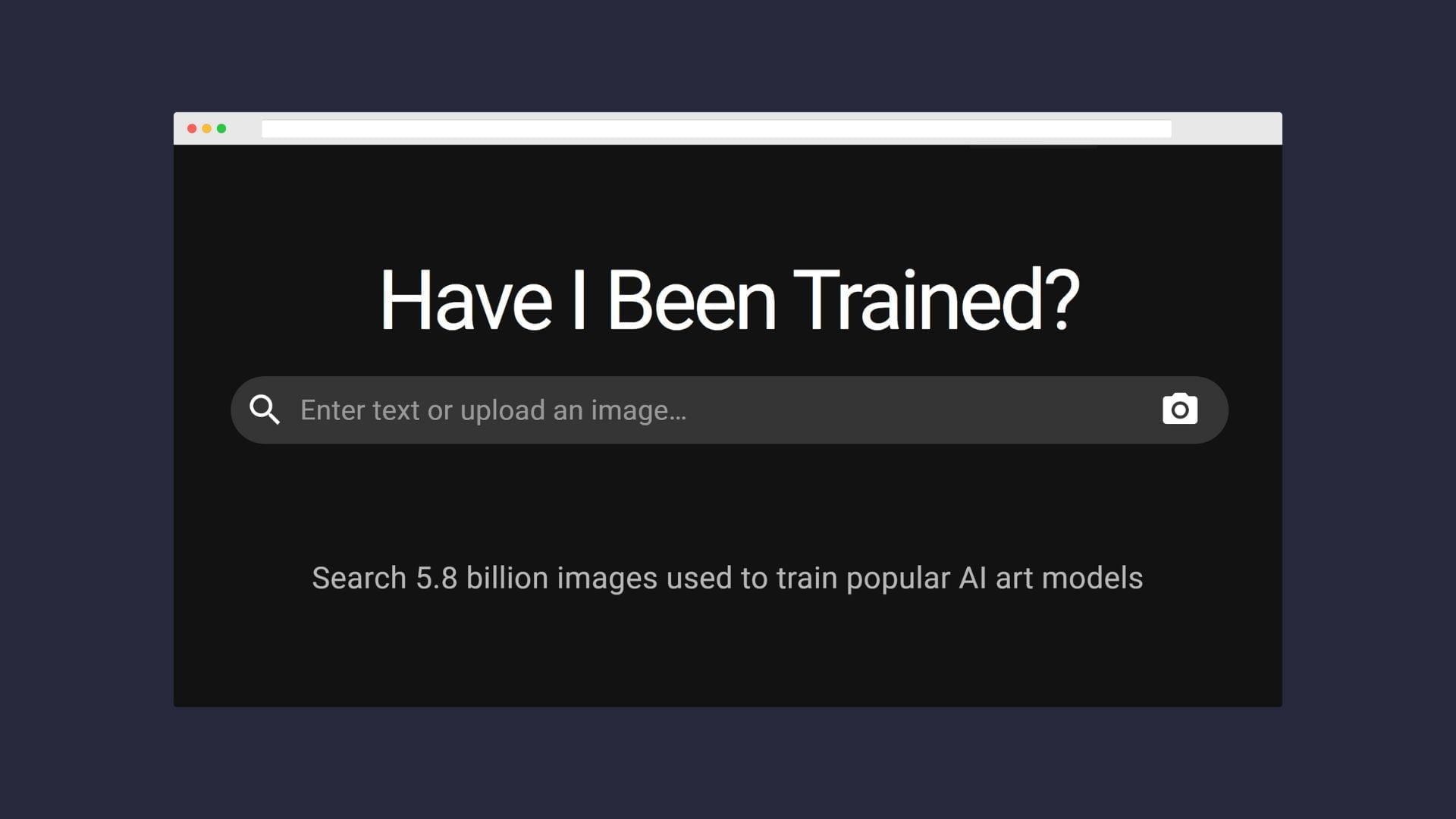

Auf der Webseite "haveibeentrained" können Interessierte mehr als fünf Milliarden Bilder durchsuchen, mit denen etwa DALL-E 2, Midjourney und Stable Diffusion trainiert wurden.

Die rasante Entwicklung aktueller generativer Bild-KI-Systeme wie DALL-E 2, Midjourney oder Stable Diffusion ist nur dank einer ungeheuren Menge an Daten möglich. Die Systeme benötigen Millionen mit Beschreibungen versehene Bilder, um die visuellen Eigenschaften einer riesigen Zahl von Begriffen zu lernen. Das wirft immer wieder Fragen in Bezug auf Urheberrecht und Datenschutz auf.

Eines dieser Datensets, mit denen Stable Diffusion, DALL-E 2 und Midjourney trainiert wurden, heißt LAION-5B und beinhaltet mehr als fünf Milliarden Bilder. Der LAION-Datensatz war zwar bereits zuvor öffentlich zugänglich, bot aber keine einfache Möglichkeit, durchsucht zu werden. Das ändert die Webseite haveibeentrained.com, die entweder anhand einzelner Schlagwörter oder mit einer Rückwärtsbildersuche das zugehörige Trainingsmaterial auswirft.

Hinter dem Projekt steckt Spawning AI. "Wir glauben, dass der beste Weg nach vorn darin besteht, den einzelnen Künstlern Werkzeuge an die Hand zu geben, mit denen sie [...] selbst bestimmen können, wie gut sie mit der sich verändernden technologischen Landschaft zurechtkommen", heißt es auf deren Webseite.

Sie seien nicht darauf aus, Einzelpersonen zu verfolgen, die mit der Arbeit anderer experimentieren. "Wir machen uns weniger Sorgen, dass Künstler Spaß haben, sondern vielmehr um die industrielle Nutzung von künstlerischen Trainingsdaten."

Frau entdeckt Foto aus ihrer Krankenakte in KI-Trainingsmaterial

Ihren Nutzen hat die Webseite schon kurz nach ihrer Veröffentlichung bewiesen. Eine Frau entdeckte ein Bild von sich selbst in der Datenbank, das eigentlich nicht dort hätte landen sollen. Laut Twitter-Nutzerin Lapine sei dieses Foto 2013 im Rahmen einer klinischen Dokumentation aufgenommen worden. Sie habe eine Erklärung unterschrieben, in der geregelt gewesen sei, dass das Foto nur für ihre Akte und nicht für die Öffentlichkeit bestimmt gewesen sei.

🚩My face is in the #LAION dataset. In 2013 a doctor photographed my face as part of clinical documentation. He died in 2018 and somehow that image ended up somewhere online and then ended up in the dataset- the image that I signed a consent form for my doctor- not for a dataset. pic.twitter.com/TrvjdZtyjD

— Lapine (@LapineDeLaTerre) September 16, 2022

Lapine ist offenbar kein Einzelfall, wie Ars Technica in einer Recherche herausgefunden hat. "Bei unserer Suche nach Lapines Fotos entdeckten wir im Datensatz auch Tausende ähnlicher Fotos aus Krankenakten von Patienten, von denen jedes einen ähnlich fragwürdigen ethischen oder rechtlichen Status haben könnte und von denen viele wahrscheinlich in beliebte Bildsynthesemodelle integriert wurden, die Unternehmen wie Midjourney und Stability AI als kommerzielle Dienstleistung anbieten."

Zwar könne nicht jeder plötzlich eine KI-Version ihres Gesichts generieren, auch weil ihr Name nicht mit dem Foto verknüpft sei. Aber es störe sie, dass private, medizinische Bilder jetzt Teil eines Produktes seien, so Lapine.

Rechte fürs KI-Training könnten zukünftig gesondert erteilt werden

Der LAION-Datensatz beinhaltet Verlinkungen auf die Bildstelle im Internet statt des Bildes. Laut Datenschutzerklärung von LAION ist die Nennung von Name und Gesicht Voraussetzung für die Löschung eines Bildlinks. Alternativ kann man versuchen, das Bild direkt an der Quelle zu löschen, dann läuft der LAION-Link ins Leere.

Ein unnötig komplizierter Prozess, findet das Team von haveibeentrained.com, die mit Source+ einen Standard für diese Angelegenheit schaffen wollen. Künstler:innen und Privatpersonen sollen darüber zukünftig einen Schalter umlegen können, ob ihre Werke für KI-Training verwendet werden dürfen oder nicht. Wenn Bilder allerdings unrechtmäßig im Internet veröffentlicht werden, wie die medizinischen Aufnahmen von Lapine, hilft auch dieser Schalter nicht.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.