Whiteboard-of-Thought: Neue Methode lässt Sprachmodelle mit Bildern denken

"Whiteboard-of-Thought" ermöglicht es multimodalen Sprachmodellen, Bilder als Zwischenschritte beim Denken zu verwenden. Dies verbessert ihre Leistung bei Aufgaben, die visuelles und räumliches Denken erfordern.

Forscher der Columbia University haben eine neue Technik entwickelt, mit der multimodale große Sprachmodelle (MLLMs) wie OpenAIs GPT-4o visuelle Zwischenschritte beim Denken nutzen können. Sie nennen diese Methode "Whiteboard-of-Thought" (WoT) in Anlehnung an die weit verbreitete "Chain-of-Thought"-Methode (CoT).

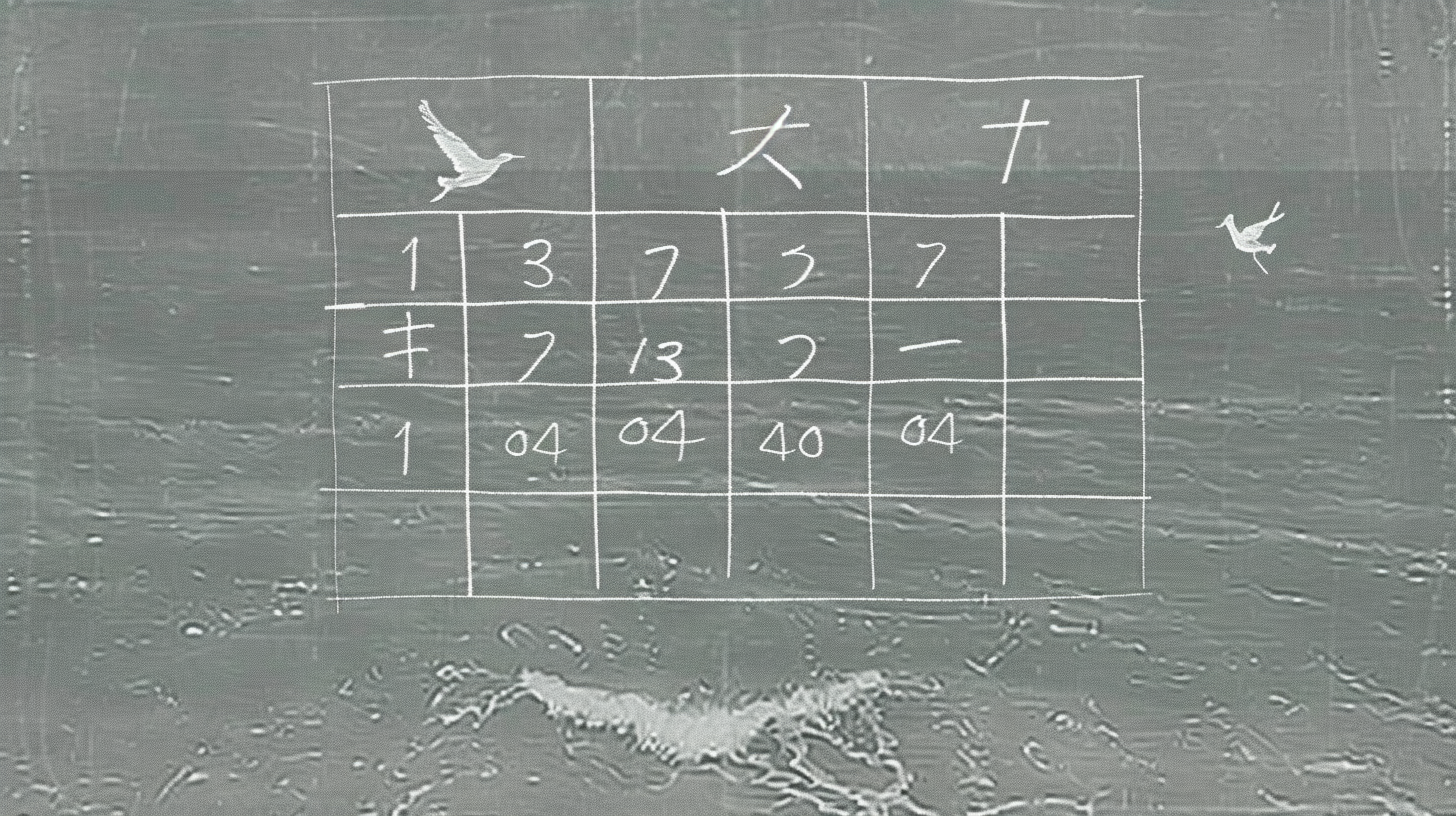

Während CoT Sprachmodelle dazu bringt Zwischenschritte in Schlussfolgerungen aufzuschreiben, stellt WoT den MLLMs eine metaphorische "Tafel" zur Verfügung, auf der sie die Ergebnisse von Zwischendenkschritten als Bilder festhalten können.

Dazu nutzen die Forscher die Fähigkeit der Modelle, Code mit Visualisierungsbibliotheken wie Turtle und Matplotlib zu schreiben. Der generierte Code wird ausgeführt, um ein Bild zu erzeugen. Dieses Bild wird dann als visueller Input an das multimodale Modell zurückgegeben, um weitere Schritte zur Erzeugung einer endgültigen Antwort durchzuführen.

Whiteboard-of-Thought bringt Leistungssprünge in visuellen Benchmarks

Die Forscher demonstrieren das Potenzial dieser Idee anhand von drei BIG-Bench-Aufgaben, bei denen es um das Verständnis von ASCII-Kunst geht, sowie anhand eines kürzlich veröffentlichten schwierigen Benchmarks zur Bewertung räumlicher Denkfähigkeiten.

Bei diesen Aufgaben, die sich bisher als schwierig für aktuelle Modelle erwiesen haben, ermöglicht WoT einen signifikanten Leistungssprung und übertrifft die Leistung von Modellen, die nur auf Text basieren, deutlich.

Die Autoren führen auch eine detaillierte Fehleranalyse durch, um zu verstehen, wo die Methode erfolgreich ist und wo ihre Grenzen liegen. Sie stellen fest, dass ein großer Teil der verbleibenden Fehler auf die visuelle Wahrnehmung zurückzuführen ist. Mit besseren Modellen werde der Nutzen von WoT weiter zunehmen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.