Wie die Hardware-Lotterie die KI-Forschung bestimmt

In der KI-Forschung setzt sich immer die beste Idee durch. Oder doch nicht? Die KI-Forschung ist ein Hardware-Glücksspiel, sagt Googles KI-Forscherin Sara Hooker.

2012 kündigt eine Gruppe Forscher der Universität Toronto an, sie habe einem Computer beigebracht, Bilder mit einem neuronalen Netzwerk zu erkennen. Der ImageNet-Moment genannte Durchbruch bringt sinnvolle kommerzielle Anwendungen und führt so zu einem signifikanten Anstieg von Investitionen in das maschinelle Lernen mit künstlichen neuronalen Netzwerken.

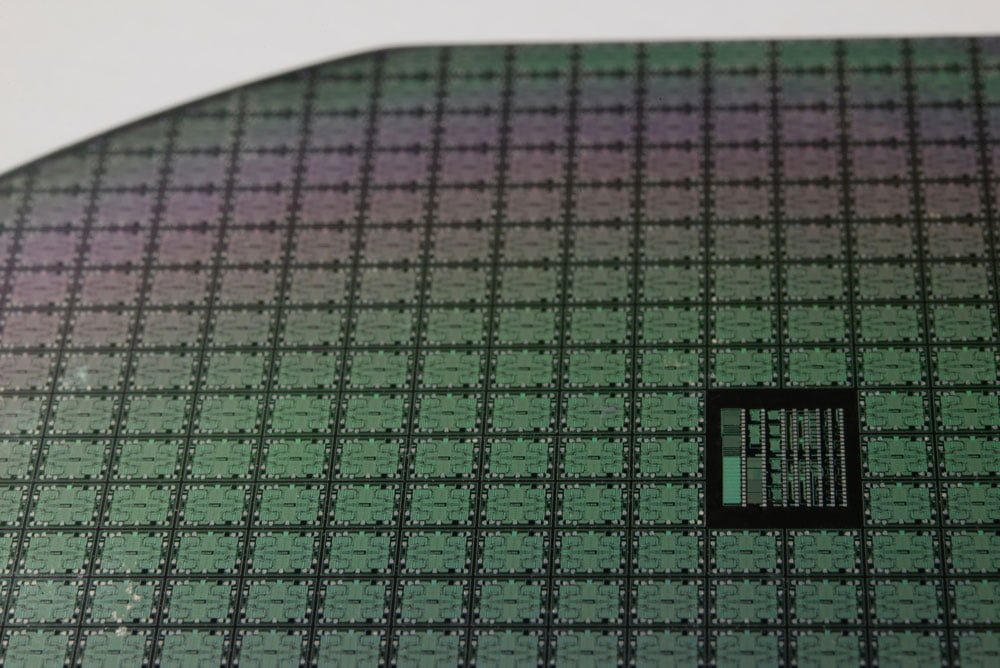

In der Folge dominieren neuronale Netze die KI-Forschung. Ihr Erfolg initiiert die Entwicklung spezialisierter Hardware, die das KI-Training effizienter machen. Einige Jahre später finden KI-Chips und KI-Anwendungen ihren Weg in unseren Alltag, ermöglichen neue und lukrative Geschäftsmodelle und noch größeren Investitionen in KI-Technologie.

Möglich war dieser rasante Aufstieg durch die Entwicklung immer leistungsfähigerer Grafikkarten (GPUs). Die wurden zwar für eine völlig andere Aufgabe entworfen, nämlich für das Gaming, eignen sich jedoch sehr gut für das Training tiefer neuronaler Netze.

Die verlorenen Dekaden

Doch womöglich hätte der Siegeszug der neuronalen Netze schon dreißig Jahre früher beginnen können, sagt Sara Hooker, KI-Forscherin bei Google Brain. Das am Erfolg maßgeblich beteiligte Backpropagation-Verfahren wurde schließlich schon 1963 entwickelt, tiefe neuronale Netze spätestens 1982 und beide Techniken in Kombination irgendwann zwischen 1987 und 1989 getestet.

Doch viele Fortschritte in der KI-Forschung seien ein Produkt ihrer Hard- und Software-Umgebung, so Hooker. Zahlreiche Forscher würden sich auf Software konzentrieren und dabei außer Acht lassen, dass Hardware diktiere, welche Art von Forschung überhaupt praktikabel sei.

Im Fall der neuronalen Netze hat der Fokus auf Expertensysteme und logische Programmiersprachen zur Entwicklung klassischer CPUs geführt. Forschung in alternative Hardware, die massive parallele Rechenoperationen ermöglichen, wurde nur vereinzelt und mit geringem Budget finanziert.

Rufe nach solch spezialisierter Hardware seien jedoch bereits Anfang der 1980er Jahre laut geworden, so Hooker. Doch ein Großteil der spezialisierten Hardware, wie die von der DARPA finanzierte Connection Machine, der Space- oder der Ring-Array-Prozessor seien für logische Programmiersprachen wie PROLOG und LISP gebaut worden.

Andere Projekte wie HipNet-1 oder der Analog Neural Network Chip seien zwar vielversprechend für neuronale Netze gewesen, doch die hohen Entwicklungskosten und der Bedarf an spezialisierten Silizium-Chips sei für die mit wenig Budget ausgestatteten Forscher nicht tragbar gewesen, so Hooker.

Ohne Videospiele keine KI-Revolution?

So ist es wohl dem Unterhaltungsdrang der Videospieler und der CGI-Industrie zu verdanken, dass auf Grafikkarten heute Computerchips existieren, die zufälligerweise die gleichen Aufgaben erledigen können, die auch für das KI-Training mit neuronalen Netzen benötigt werden.

Ob eine Forschungsidee in der Künstlichen Intelligenz erfolgreich ist, hängt also auch davon ab, ob entsprechende Hardware existiert, um die Idee umzusetzen. Da die Entwicklung neuer Hardware teuer und zeitaufwendig ist, gebe es immer Ideen, die zur falschen Zeit entstehen und daher zu den Verlierern der Hardware-Lotterie gehörten, sagt Hooker.

Neuronale Netze hätten wohl für immer zu diesen Verlierern gehören können: Gäbe es keine Grafikkarten, hätte die Menschheit womöglich nie von der Leistungsfähigkeit künstlicher neuronaler Netze erfahren.

Doch jetzt, wo neuronale Netze klar zu den Gewinnern der Hardware-Lotterie gehören – wer sind die neuen Verlierer?

Die ewige Hardware-Lotterie

Es sei wahrscheinlich, dass unser aktueller Fokus auf bessere Hardware für neuronale Netze eine neue Einschränkung für die KI-Wissenschaft bedeutet, meint Hooker. TPUs und andere KI-Chips seien für eine ganz bestimmte Form Künstlicher Intelligenz gebaut. Es gebe in der Forschung aber bereits Beispiele für alternative KI-Architekturen, die jedoch weder auf GPUs noch TPUs sonderlich effektiv laufen, schreibt Hooker.

Fehlende spezialisierte Hardware verhindere in solchen Fällen womöglich spektakuläre Ergebnisse wie den eingangs erwähnten Imagenet-Moment, was wiederum zu weniger Aufmerksamkeit unter Forschern und geringeren Investitionen führe.

Die Lösung wäre einfach: Organisationen und Unternehmen müssten auf Verdacht mehr Forschungsgelder in neue, unerprobte Hardware stecken.

Nur ist das ziemlich teuer. Eine neue Chip-Generation koste im Schnitt zwei bis drei Jahre Entwicklungszeit und 30 bis 80 Millionen US-Dollar. Der Bau einer Fertigungsanlage für eine neue Chip-Generation lag 2017 bei knapp sieben Milliarden US-Dollar, so Hooker.

Die Kosten für nicht etablierte Ansätze lägen um ein Vielfaches höher und benötigten oft bis zu zehn Jahre Forschungszeit. Als Beispiele nennt Hooker biologische, neuromorphische und optische Computer und quantenbasierte Ansätze.

Möglich seien auch Fortschritte in der Softwareentwicklung, vermutet Hooker. Spezialisierte Software könne einschätzen, auf welcher Hardware eine KI-Anwendung besser laufen würde und so Anstöße für neue Designs geben. Google verfolgt diesen Ansatz bereits: KI soll beim Chipdesign für KI-Chips helfen.

Software-, Hardware- und KI-Entwickler müssten sich bewusstwerden, dass die Leistung einer KI-Anwendung grundlegend mit der Soft- und Hardware, auf der sie läuft, verknüpft sei. Entscheidungen über beide Faktoren würden über Erfolg oder Misserfolg einer Forschungsidee bestimmen.

Ein Zitat aus der Satire-Serie Silicon Valley (Amazon Link) bringt das auf den Punkt, meint Hooker: Zu weit voraus zu sein ist dasselbe, wie falsch zu liegen.

Titelbild:Byte Magazine, Via: Arxiv

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.