Wie generative KI helfen kann, sich besser zu fühlen

Eine neue Studie zeigt, wie Menschen Systeme der generativen KI wie ChatGPT in ihre Selbstfürsorge-Praktiken integrieren. Die Forschenden identifizierten fünf Praktiken, die von der Suche nach Ratschlägen bis zur kreativen Selbstdarstellung reichen.

Forschende der University of Edinburgh, der Queensland University of Technology und des King’s College London haben untersucht, wie Menschen KI-Werkzeuge wie ChatGPT und DALL-E in ihre Selbstfürsorge-Routinen einbinden.

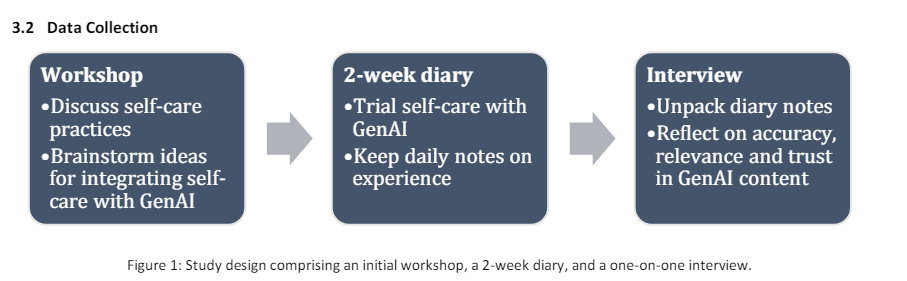

Dazu führten sie Workshops, Tagebuchstudien und Interviews mit fünf Forschenden und 24 Teilnehmenden durch, die regelmäßig Selbstfürsorge praktizieren.

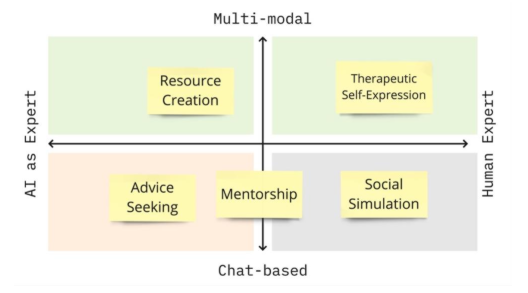

Die Studie identifizierte fünf Praktiken, wie Menschen von KI erstellte Inhalte für ihre Selbstfürsorge nutzen: Ratschläge einholen, Mentoring, Ressourcen erstellen, soziale Simulationen durchführen und sich selbst ausdrücken. Diese Praktiken unterscheiden sich in zwei Dimensionen: woher das Wissen kommt und den verwendeten Modalitäten.

Ratschläge einholen, war die häufigste Praxis. Dabei wandten sich die Teilnehmenden mit einer Frage an ChatGPT, etwa zu Stressbewältigung, Ernährung oder Schlafhygiene. Im Gegensatz zur allgemeinen Suche im Internet waren die KI-Antworten personalisierter und eher als Vorschläge denn als Fakten formuliert.

Das Mentoring ging noch einen Schritt weiter: Hier interagierten die Teilnehmenden über Tage und Wochen hinweg mit dem KI-System zu verschiedenen Aspekten desselben Themas, etwa als persönlicher Trainer oder Schlafcoach.

Die Teilnehmenden schätzten den KI-Mentor für seine ständige Verfügbarkeit und das Gefühl, nicht verurteilt zu werden. Sie sahen ihn aber nicht als Ersatz für menschliche Mentoren.

Beim Erstellen von Ressourcen nutzten die Teilnehmenden die multimodalen Fähigkeiten der KI, um Ressourcen wie geführte Meditationen, Bilder zum Ausmalen oder Quizfragen zu erstellen, die sie dann für ihre Selbstfürsorge verwendeten - teils auch, um Familienmitglieder und Freunde zu unterstützen.

Bei sozialen Simulationen experimentierten die Teilnehmenden mit ChatGPT, um soziale Situationen und Szenarien durchzuspielen. So konnten sie in einem geschützten Raum verschiedene Vorgehensweisen ausprobieren, bevor sie diese im echten Leben anwenden.

Der therapeutische Selbstausdruck schließlich umfasste kreative Aktivitäten, um Gefühle auszudrücken, etwa durch von der KI generierte Bilder oder Musik. Die multimodalen Fähigkeiten der KI waren hier besonders wichtig, da die Teilnehmenden so Aspekte ihrer Gefühle ausdrücken konnten, die sie in Worten nicht leicht erfassen konnten.

Zuhören ohne Vorbehalte

Ein wichtiger Aspekt war das Vertrauen in die KI-Systeme. Die Teilnehmenden empfanden die KI-generierten Inhalte größtenteils als zutreffend und angemessen für ihre Selbstfürsorge, auch wenn sie teils Informationen anzweifelten oder als zu allgemein empfanden. Überraschend war die Bereitschaft, intime persönliche Informationen mit der KI zu teilen, weil sie als nicht wertend wahrgenommen wurde.

"Ich hatte das Gefühl, dass ich mit der KI ehrlicher sein konnte als mit einem Psychologen. Denn wenn ich in einer realen Situation bin, ist es immer noch eine Person, die da ist. Man sagt es immer noch auf eine Art und Weise, die die Person respektiert, während man hier [auf ChatGPT] auf nichts Rücksicht nehmen muss. Du sagst einfach deine rohen, ehrlichen Gefühle. Und du weißt, dass es niemanden verletzen wird, weil es niemanden zu verletzen gibt."

Meinung einer 25-jährigen Studien-Teilnehmerin

Die Forschenden sehen hier Potenzial, weisen aber auch auf das Risiko vor einer zu starken emotionalen Bindung an KI-Systemen hin. Weitere Forschung sei nötig, um die Chancen und Risiken dieser Technologien für die Selbstfürsorge besser zu verstehen.

Die Studie liefere einen Rahmen für aufkommende Selbstfürsorge-Praktiken mit generativer KI und bietet Ansatzpunkte für die Gestaltung neuer Selbstfürsorge-Technologien.

"Wir glauben, dass die Inhalte von GenAI nicht nur wichtige Informationen für die Selbstfürsorge bieten (wie die Suche nach Beratung und Mentoring zeigt), sondern dass sie den Menschen auch die Möglichkeit geben, kreativ zu sein, indem sie Ressourcen und Simulationen aufbauen und sich selbst ausdrücken können", schreiben die Forscher.

Verwendet wurden größtenteils kostenlose Tools wie ChatGPT-3.5 oder Bing Image Creator. Hier ist absehbar, dass mit neuen Sprachfähigkeiten und multimodalen Modellen die Möglichkeiten für Selbstfürsorge noch zunehmen werden, da das Modell fließend zwischen gesprochener Sprache und Bildgenerierung wechseln kann und die Bilder genauer den Anweisungen entsprechen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.